このガイドでは、サポートされているオペレーティング システムを搭載した OpenStack 仮想マシン(VM)のベアメタルに Google Distributed Cloud(ソフトウェアのみ)をインストールする例について説明します。このデプロイでは、スクリプトを使用して OpenStack VM へのハイブリッド クラスタのインストールを簡素化します。また、サービスとしてのロード バランシング(LBaaS)を有効にする方法の一つについても説明します。Google Distributed Cloud で OpenStack LBaaS と Kubernetes OpenStack クラウド プロバイダを使用すると、Kubernetes サービスを OpenStack クラスタの外部に公開できます。

Google Distributed Cloud は、OpenStack VM を自動的にプロビジョニングしません。また、VM のプロビジョニングはこのガイドの範囲外です。VM の要件とデプロイの例を確認するには、OpenStack VM を作成する Terraform の例をご覧ください。

このガイドは、次のセクションで構成されています。

Google Distributed Cloud をデプロイする

インストールされたクラスタで Kubernetes 用の OpenStack Cloud Provider を構成して、Octavia ロードバランサと統合する

Kubernetes 用の OpenStack Cloud Provider の統合を検証する

このガイドでは OpenStack Ussuri を使用しますが、Google Distributed Cloud に OpenStack の特定のバージョンに対する要件はありません。このガイドでは、OpenStack VM を使用して、OpenStack で動作する 2 ノードの概念実証環境を提供します。Google Distributed Cloud の本番環境へのインストール要件については、インストールの前提条件をご覧ください。

デプロイの例

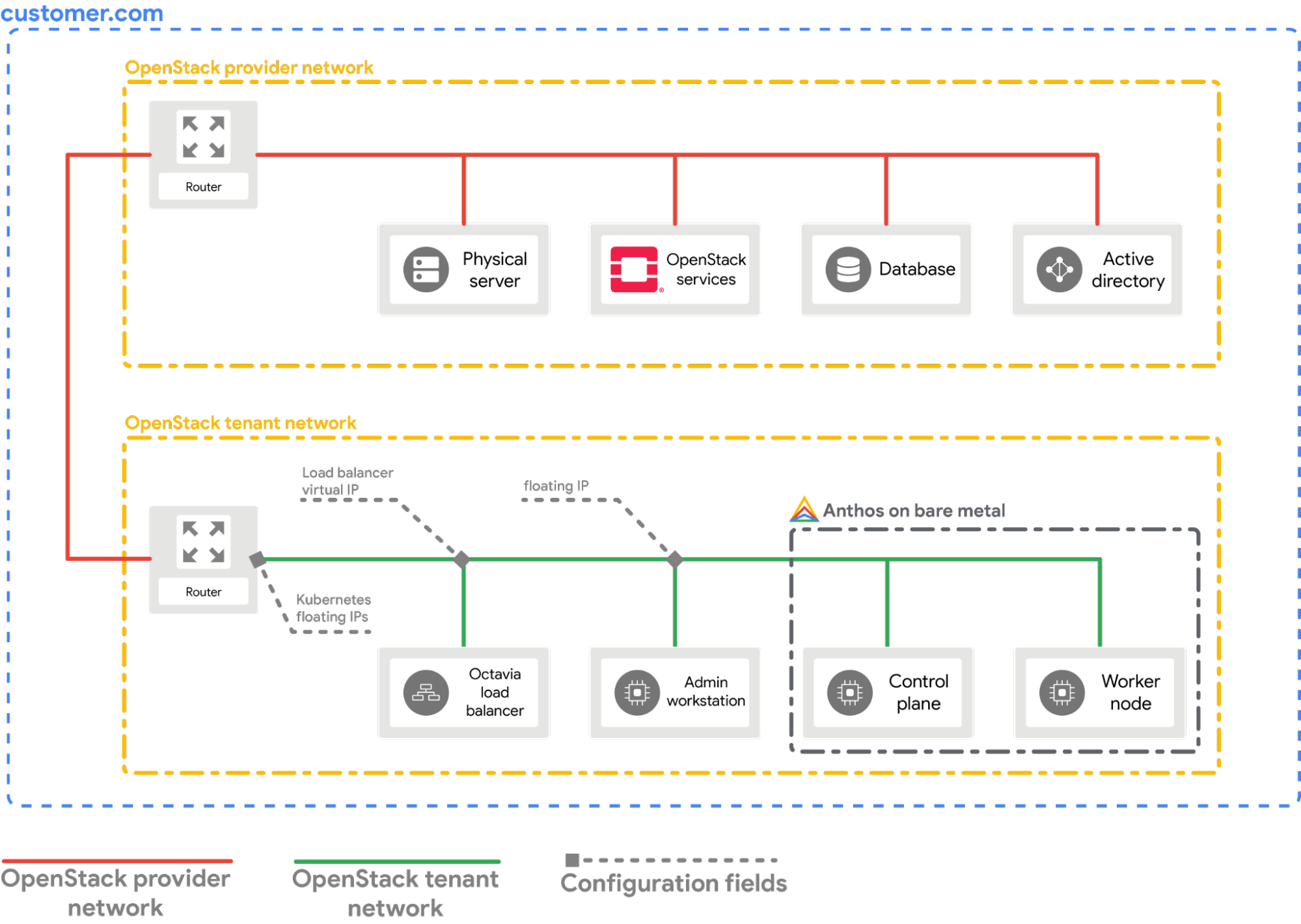

このガイドでは、OpenStack LBaaS と統合される OpenStack にベアメタル クラスタをデプロイする例を示します。コマンドと構成値を理解し、OpenStack 環境に合うように調整する必要があります。次の図は、デプロイの結果を示しています。

前提条件

- LBaaS v2 がデプロイされ、機能している OpenStack Ussuri

- bmctl ツールをダウンロードするためのサービス アカウント

- デプロイの例に示すように、OpenStack VM とネットワークを構成する。OpenStack 環境で同様の設定をプロビジョニングする場合は、次の方法があります。

- Terraform スクリプトを使用して、リソースを自動的にプロビジョニングする。

- リソースを手動でプロビジョニングする。

- 次の OpenStack VM を準備し、SSH 経由で使用できる状態にしておく必要があります。

| 名前 | IP アドレス | 目的 |

|---|---|---|

| abm-ws |

10.200.0.10 (プライベート IP) float_ip (パブリック IP) |

管理ワークステーションとして機能: Google Distributed Cloud を他のマシンにデプロイするために使用されます。 |

| abm-cp1 | 10.200.0.11 | クラスタ コントロール プレーン: このホストは、Kubernetes コントロール プレーンとロードバランサを実行します。 |

| abm-w1 | 10.200.0.12 | クラスタのワーカーノード: このホストは Kubernetes ワークロードを実行します。 |

Google Distributed Cloud をデプロイする

このセクションでは、次のタスクを行う方法を説明します。

- 必要なツールを

abm-ws管理ワークステーション VM にインストールする - デプロイを安全に実行するために必要なプロジェクト ID とサービス アカウントを構成する

- クラスタ構成ファイルを作成する

- クラスタを作成する

必要なツールをインストールする

abm-wsVM のパブリック フローティング IP アドレスを取得します。export OPENSTACK_IPS=$(openstack floating ip list --tags=abm_ws_floatingip -f json) export FLOATING_IP=$(jq -c '.[]."Floating IP Address"' <<< $OPENSTACK_IPS | tr -d '"')SSH を使用して

abm-wsVM に安全に接続し、rootユーザーとしてログインできることを確認します。Terraform スクリプト で構成されたrootユーザーはabmです。ssh ubuntu@$FLOATING_IP sudo -u abm -iSSH を使用して他のノードに接続できることを確認します。

ssh abm@10.200.0.11 'echo SSH to $HOSTNAME succeeded' ssh abm@10.200.0.12 'echo SSH to $HOSTNAME succeeded'上記のコマンドで想定されるレスポンスは次のとおりです。

SSH to abm-cp1 succeeded SSH to abm-w1 succeededabm-wsVM にkubectlコマンドライン ユーティリティをダウンロードします。curl -LO "https://storage.googleapis.com/kubernetes-release/release/$(curl -s https://storage.googleapis.com/kubernetes-release/release/stable.txt)/bin/linux/amd64/kubectl" chmod +x kubectl sudo mv kubectl /usr/local/sbin/abm-wsVM に Docker をインストールします。curl -fsSL https://get.docker.com -o get-docker.sh sh get-docker.sh sudo usermod -aG docker abm newgrp docker

Google Cloud プロジェクトとサービス アカウントを構成する

ユーザー アカウントの Google Cloud CLI アクセス認証情報を取得します。

これらの認証情報は、後続の

gcloudコマンドで使用されます。gcloud auth loginクラスタを登録する Google Cloud プロジェクトを使用するように Google Cloud CLI を構成します。

gcloud config set project PROJECT_ID管理ワークステーションで、ユーザー アカウントのアプリケーションのデフォルト認証情報(ADC)を設定します。これは、クラスタの作成に

bmctlツールを使用するときに使用されます。gcloud auth application-default loginbm-gcrサービス アカウントを作成します。このサービス アカウントを使用して、クラスタから認証を行います。gcloud iam service-accounts create bm-gcr gcloud iam service-accounts keys create bm-gcr.json \ --iam-account=bm-gcr@PROJECT_ID.iam.gserviceaccount.com必要な API を有効にします。

gcloud services enable \ anthos.googleapis.com \ anthosaudit.googleapis.com \ anthosgke.googleapis.com \ cloudresourcemanager.googleapis.com \ connectgateway.googleapis.com \ container.googleapis.com \ gkeconnect.googleapis.com \ gkehub.googleapis.com \ gkeonprem.googleapis.com \ iam.googleapis.com \ logging.googleapis.com \ monitoring.googleapis.com \ opsconfigmonitoring.googleapis.com \ serviceusage.googleapis.com \ stackdriver.googleapis.com \ storage.googleapis.combm-gcrサービス アカウントに追加の権限を付与します。権限を追加することで、サービスごとに複数のサービス アカウントを作成する必要がなくなります。gcloud projects add-iam-policy-binding PROJECT_ID \ --member="serviceAccount:bm-gcr@PROJECT_ID.iam.gserviceaccount.com" \ --role="roles/gkehub.connect" gcloud projects add-iam-policy-binding PROJECT_ID \ --member="serviceAccount:bm-gcr@PROJECT_ID.iam.gserviceaccount.com" \ --role="roles/gkehub.admin" gcloud projects add-iam-policy-binding PROJECT_ID \ --member="serviceAccount:bm-gcr@PROJECT_ID.iam.gserviceaccount.com" \ --role="roles/logging.logWriter" gcloud projects add-iam-policy-binding PROJECT_ID \ --member="serviceAccount:bm-gcr@PROJECT_ID.iam.gserviceaccount.com" \ --role="roles/monitoring.metricWriter" gcloud projects add-iam-policy-binding PROJECT_ID \ --member="serviceAccount:bm-gcr@PROJECT_ID.iam.gserviceaccount.com" \ --role="roles/monitoring.dashboardEditor" gcloud projects add-iam-policy-binding PROJECT_ID \ --member="serviceAccount:bm-gcr@PROJECT_ID.iam.gserviceaccount.com" \ --role="roles/stackdriver.resourceMetadata.writer" gcloud projects add-iam-policy-binding PROJECT_ID \ --member="serviceAccount:bm-gcr@PROJECT_ID.iam.gserviceaccount.com" \ --role="roles/opsconfigmonitoring.resourceMetadata.writer"

クラスタ構成ファイルを作成する

bmctlコマンドライン ユーティリティをダウンロードします。mkdir baremetal && cd baremetal gcloud storage cp gs://anthos-baremetal-release/bmctl/1.33.100-gke.89/linux-amd64/bmctl . chmod a+x bmctl sudo mv bmctl /usr/local/sbin/クラスタのクラスタ構成ファイルを作成します。

bmctl create config -c CLUSTER_NAMEOpenStack で使用するように構成ファイルを更新します。

cat > bmctl-workspace/CLUSTER_NAME/CLUSTER_NAME.yaml << EOB --- gcrKeyPath: /home/abm/bm-gcr.json sshPrivateKeyPath: /home/abm/.ssh/id_rsa gkeConnectAgentServiceAccountKeyPath: /home/abm/bm-gcr.json gkeConnectRegisterServiceAccountKeyPath: /home/abm/bm-gcr.json cloudOperationsServiceAccountKeyPath: /home/abm/bm-gcr.json --- apiVersion: v1 kind: Namespace metadata: name: openstack-cluster-ns --- apiVersion: baremetal.cluster.gke.io/v1 kind: Cluster metadata: name: CLUSTER_NAME namespace: openstack-cluster-ns annotations: baremetal.cluster.gke.io/external-cloud-provider: "true" spec: type: hybrid anthosBareMetalVersion: 1.33.100-gke.89 gkeConnect: projectID: PROJECT_ID controlPlane: nodePoolSpec: clusterName: CLUSTER_NAME nodes: - address: 10.200.0.11 clusterNetwork: pods: cidrBlocks: - 192.168.0.0/16 services: cidrBlocks: - 10.96.0.0/20 loadBalancer: mode: manual ports: controlPlaneLBPort: 443 vips: controlPlaneVIP: 10.200.0.101 ingressVIP: 10.200.0.102 clusterOperations: location: us-central1 projectID: PROJECT_ID storage: lvpNodeMounts: path: /mnt/localpv-disk storageClassName: node-disk lvpShare: numPVUnderSharedPath: 5 path: /mnt/localpv-share storageClassName: standard nodeAccess: loginUser: abm --- apiVersion: baremetal.cluster.gke.io/v1 kind: NodePool metadata: name: node-pool-1 namespace: openstack-cluster-ns spec: clusterName: CLUSTER_NAME nodes: - address: 10.200.0.12 EOB

クラスタを作成する

クラスタを作成します。

bmctl create cluster -c CLUSTER_NAME

bmctl コマンドを実行すると、新しいハイブリッド クラスタの設定が開始します。ノードでのプリフライト チェック、管理クラスタとユーザー クラスタの作成、Connect Agent を使用した Google Cloud へのクラスタの登録が行われます。設定全体で 15 分ほどかかります。クラスタの作成中は次の出力が表示されます。

Please check the logs at bmctl-workspace/CLUSTER_NAME/log/create-cluster-20210926-020741/create-cluster.log

[2021-09-26 02:07:59+0000] Creating bootstrap cluster... ⠦ kind get kubeconfig --name bmctl > ~/.kube/config && k get pods --all-namespaces

[2021-09-26 02:07:59+0000] Creating bootstrap cluster... OK

[2021-09-26 02:10:48+0000] Installing dependency components... OK

[2021-09-26 02:13:42+0000] Waiting for preflight check job to finish... OK

[2021-09-26 02:15:22+0000] - Validation Category: machines and network

[2021-09-26 02:15:22+0000] - [PASSED] gcp

[2021-09-26 02:15:22+0000] - [PASSED] node-network

[2021-09-26 02:15:22+0000] - [PASSED] 10.200.0.11

[2021-09-26 02:15:22+0000] - [PASSED] 10.200.0.11-gcp

[2021-09-26 02:15:22+0000] - [PASSED] 10.200.0.12

[2021-09-26 02:15:22+0000] - [PASSED] 10.200.0.12-gcp

[2021-09-26 02:15:22+0000] Flushing logs... OK

[2021-09-26 02:15:23+0000] Applying resources for new cluster

[2021-09-26 02:15:24+0000] Waiting for cluster to become ready OK

[2021-09-26 02:25:04+0000] Writing kubeconfig file

[2021-09-26 02:25:04+0000] kubeconfig of created cluster is at bmctl-workspace/CLUSTER_NAME/CLUSTER_NAME-kubeconfig, please run

[2021-09-26 02:25:04+0000] kubectl --kubeconfig bmctl-workspace/CLUSTER_NAME/CLUSTER_NAME-kubeconfig get nodes

[2021-09-26 02:25:04+0000] to get cluster node status.

[2021-09-26 02:25:04+0000] Please restrict access to this file as it contains authentication credentials of your cluster.

[2021-09-26 02:25:04+0000] Waiting for node pools to become ready OK

[2021-09-26 02:25:24+0000] Moving admin cluster resources to the created admin cluster

[2021-09-26 02:25:53+0000] Flushing logs... OK

[2021-09-26 02:25:53+0000] Deleting bootstrap cluster...

クラスタの確認と操作

クラスタの kubeconfig ファイルは、abm-ws VM の bmctl-workspace ディレクトリ内にあります。デプロイを確認するには、次の操作を行います。

KUBECONFIG環境変数にクラスタの構成ファイルのパスを設定し、クラスタでkubectlコマンドを実行します。export KUBECONFIG=$HOME/bmctl-workspace/CLUSTER_NAME/CLUSTER_NAME-kubeconfig kubectl get nodesクラスタのノードが次のように表示されます。

NAME STATUS ROLES AGE VERSION abm-cp1 Ready control-plane,master 5m24s v1.20.5-gke.1301 abm-w1 Ready <none> 2m17s v1.20.5-gke.1301

Google Cloud コンソールからクラスタにログインする

Google Cloud コンソールでワークロードをモニタリングするには、クラスタにログインする必要があります。クラスタへのログインの手順と詳細については、 Google Cloud コンソールからクラスタを操作するをご覧ください。

クリーンアップ

クラスタをクリーンアップするには、管理ワークステーション(abm-ws)VM で次のコマンドを実行します。

export KUBECONFIG=$HOME/bmctl-workspace/CLUSTER_NAME/CLUSTER_NAME-kubeconfig

bmctl reset --cluster CLUSTER_NAME

次のステップ

- 新しく作成したクラスタに OpenStack Cloud Provider をインストールするには、Kubernetes 用の OpenStack Cloud Provider を構成するの説明に従ってください。