Datastream supporta lo streaming di dati dai database Oracle, MySQL e PostgreSQL direttamente nei set di dati BigQuery. Tuttavia, se hai bisogno di un maggiore controllo sulla logica di elaborazione dei flussi, ad esempio la trasformazione dei dati o l'impostazione manuale delle chiavi primarie logiche, puoi integrare Datastream con i modelli di job Dataflow.

Questo tutorial mostra come Datastream si integra con Dataflow utilizzando i modelli di job Dataflow per trasmettere in streaming viste materializzate aggiornate in BigQuery per l'analisi.

Per le organizzazioni con molte origini dati isolate, l'accesso ai dati aziendali in tutta l'organizzazione, soprattutto in tempo reale, può essere limitato e lento. Ciò limita la capacità dell'organizzazione di eseguire l'introspezione.

Datastream fornisce accesso quasi in tempo reale ai dati modificati provenienti da varie origini dati on-premise e basate sul cloud. Datastream offre un'esperienza di configurazione in cui non devi eseguire molte configurazioni per lo streaming dei dati, perché Datastream lo fa per te. Datastream dispone anche di un'API di consumo unificata che democratizza l'accesso della tua organizzazione ai dati aziendali più recenti disponibili per creare scenari integrati.

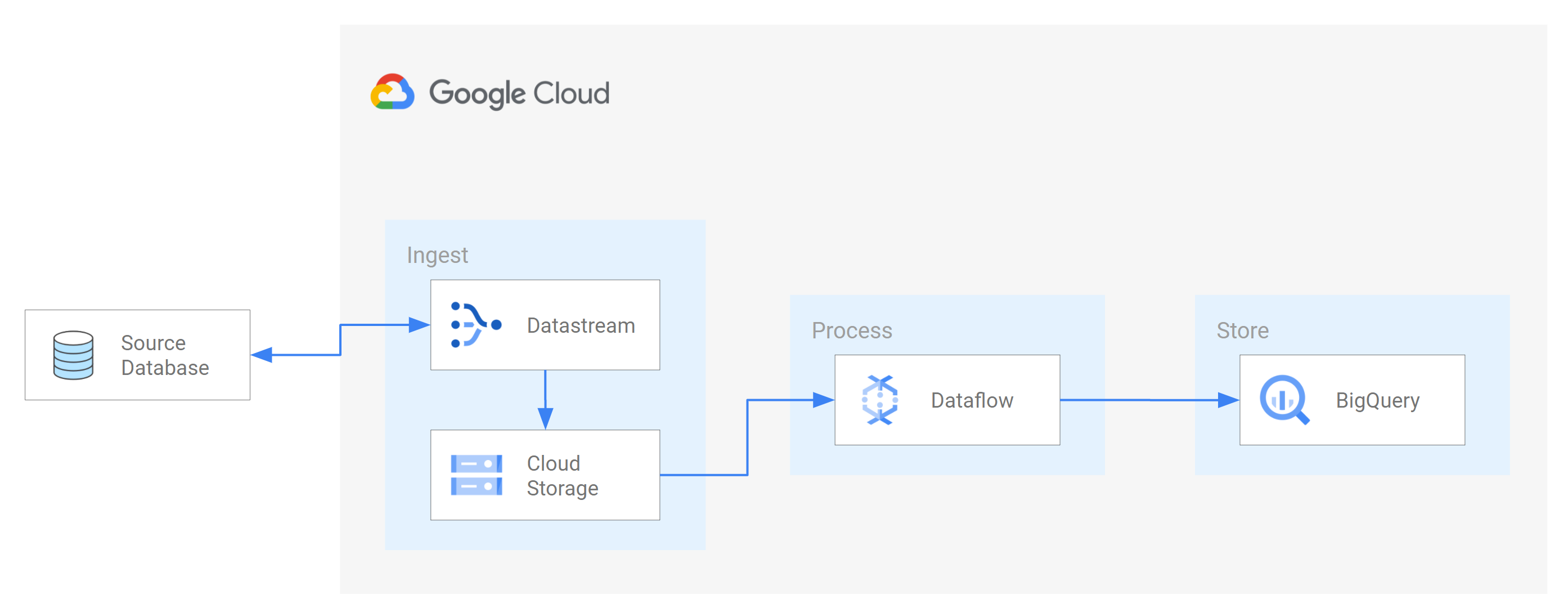

Uno di questi scenari è il trasferimento di dati da un database di origine a un servizio di archiviazione o a una coda di messaggistica basati sul cloud. Dopo che Datastream trasmette i dati, questi vengono trasformati in un formato leggibile da altre applicazioni e servizi. In questo tutorial, Dataflow è il servizio web che comunica con il servizio di archiviazione o la coda di messaggi per acquisire ed elaborare i dati su Google Cloud.

Scopri come utilizzare Datastream per trasmettere in streaming le modifiche (dati inseriti, aggiornati o eliminati) da un database MySQL di origine a una cartella in un bucket Cloud Storage. Poi, configuri il bucket Cloud Storage per inviare notifiche che Dataflow utilizza per conoscere i nuovi file contenenti le modifiche ai dati che Datastream trasmette in streaming dal database di origine. Un job Dataflow elabora quindi i file e trasferisce le modifiche in BigQuery.

Obiettivi

In questo tutorial:- Crea un bucket in Cloud Storage. Questo è il bucket di destinazione in cui Datastream trasmette schemi, tabelle e dati da un database MySQL di origine.

- Attiva le notifiche Pub/Sub per il bucket Cloud Storage. In questo modo, configuri il bucket per inviare notifiche che Dataflow utilizza per conoscere i nuovi file pronti per l'elaborazione. Questi file contengono le modifiche ai dati che Datastream trasmette in streaming dal database di origine al bucket.

- Crea set di dati in BigQuery. BigQuery utilizza i set di dati per contenere i dati che riceve da Dataflow. Questi dati rappresentano le modifiche nel database di origine che Datastream trasmette in streaming nel bucket Cloud Storage.

- Crea e gestisci profili di connessione per un database di origine e un bucket di destinazione in Cloud Storage. Un flusso in Datastream utilizza le informazioni nei profili di connessione per trasferire i dati dal database di origine al bucket.

- Crea e avvia uno stream. Questo flusso trasferisce dati, schemi e tabelle dal database di origine al bucket.

- Verifica che Datastream trasferisca nel bucket i dati e le tabelle associati a uno schema del database di origine.

- Crea un job in Dataflow. Dopo che Datastream trasmette in streaming le modifiche ai dati dal database di origine al bucket Cloud Storage, vengono inviate notifiche a Dataflow sui nuovi file contenenti le modifiche. Il job Dataflow elabora i file e trasferisce le modifiche in BigQuery.

- Verifica che Dataflow elabori i file contenenti le modifiche associate a questi dati e trasferisca le modifiche in BigQuery. Di conseguenza, hai un'integrazione end-to-end tra Datastream e BigQuery.

- Pulisci le risorse che hai creato su Datastream, Cloud Storage, Pub/Sub, Dataflow e BigQuery in modo che non occupino quota e non ti vengano addebitate in futuro.

Costi

In questo documento vengono utilizzati i seguenti componenti fatturabili di Google Cloud:

- Datastream

- Cloud Storage

- Pub/Sub

- Dataflow

- BigQuery

Per generare una stima dei costi in base all'utilizzo previsto,

utilizza il calcolatore prezzi.

Prima di iniziare

- Sign in to your Google Cloud account. If you're new to Google Cloud, create an account to evaluate how our products perform in real-world scenarios. New customers also get $300 in free credits to run, test, and deploy workloads.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

-

In the Google Cloud console, on the project selector page, select or create a Google Cloud project.

Roles required to select or create a project

- Select a project: Selecting a project doesn't require a specific IAM role—you can select any project that you've been granted a role on.

-

Create a project: To create a project, you need the Project Creator

(

roles/resourcemanager.projectCreator), which contains theresourcemanager.projects.createpermission. Learn how to grant roles.

-

Verify that billing is enabled for your Google Cloud project.

- Abilitare l'API Datastream.

- Assicurati di aver concesso il ruolo Amministratore Datastream al tuo account utente.

- Assicurati di avere un database MySQL di origine a cui Datastream possa accedere. Inoltre, verifica di disporre di dati, tabelle e schemi nel database.

- Configura il database MySQL in modo da consentire le connessioni in entrata dagli indirizzi IP pubblici di Datastream. Per un elenco di tutte le regioni Datastream e dei relativi indirizzi IP pubblici, consulta Liste consentite e regioni IP.

- Configura Change Data Capture (CDC) per il database di origine. Per ulteriori informazioni, consulta Configurare un database MySQL di origine.

Assicurati di soddisfare tutti i prerequisiti per attivare le notifiche Pub/Sub per Cloud Storage.

In questo tutorial, creerai un bucket di destinazione in Cloud Storage e attiverai le notifiche Pub/Sub per il bucket. In questo modo, Dataflow può ricevere notifiche sui nuovi file che Datastream scrive nel bucket. Questi file contengono le modifiche ai dati che Datastream trasmette in streaming dal database di origine al bucket.

Requisiti

Datastream offre una serie di opzioni di origine, opzioni di destinazione e metodi di connettività di rete.

Per questo tutorial, presupponiamo che tu stia utilizzando un database MySQL autonomo e un servizio Cloud Storage di destinazione. Per il database di origine, dovresti essere in grado di configurare la rete per aggiungere una regola firewall in entrata. Il database di origine può essere on-premise o in un provider cloud. Per la destinazione Cloud Storage, non è necessaria alcuna configurazione della connettività.

Poiché non possiamo conoscere i dettagli del tuo ambiente, non possiamo fornire passaggi dettagliati per la configurazione della rete.

Per questo tutorial, seleziona Lista consentita IP come metodo di connettività di rete. L'inserimento degli indirizzi IP nella lista consentita è una funzionalità di sicurezza spesso utilizzata per limitare e controllare l'accesso ai dati nel database di origine agli utenti attendibili. Puoi utilizzare le liste consentite di indirizzi IP per creare elenchi di indirizzi IP o intervalli IP attendibili da cui i tuoi utenti e altri servizi Google Cloud come Datastream possono accedere a questi dati. Per utilizzare le liste consentite di indirizzi IP, devi aprire il database di origine o il firewall alle connessioni in entrata da Datastream.

Crea un bucket in Cloud Storage

Crea un bucket di destinazione in Cloud Storage in cui Datastream trasmette schemi, tabelle e dati da un database MySQL di origine.

Nella console Google Cloud , vai alla pagina Browser per Cloud Storage.

Fai clic su Crea bucket. Viene visualizzata la pagina Crea un bucket.

Nel campo di testo della sezione Assegna un nome al bucket, inserisci un nome univoco per il bucket, quindi fai clic su Continua.

Accetta le impostazioni predefinite per ogni regione rimanente della pagina. Alla fine di ogni regione, fai clic su Continua.

Fai clic su Crea.

Attiva le notifiche Pub/Sub per il bucket Cloud Storage

In questa sezione, attivi le notifiche Pub/Sub per il bucket Cloud Storage che hai creato. In questo modo, configuri il bucket in modo che invii una notifica a Dataflow di tutti i nuovi file che Datastream scrive nel bucket. Questi file contengono le modifiche ai dati che Datastream trasmette in streaming da un database MySQL di origine al bucket.

Accedi al bucket Cloud Storage che hai creato. Viene visualizzata la pagina Dettagli bucket.

Fai clic su Attiva Cloud Shell.

Al prompt, inserisci questo comando:

gcloud storage buckets notifications create gs://bucket-name --topic=my_integration_notifs --payload-format=json --object-prefix=integration/tutorial/(Facoltativo) Se viene visualizzata una finestra Autorizza Cloud Shell, fai clic su Autorizza.

Verifica di visualizzare le seguenti righe di codice:

Created Cloud Pub/Sub topic projects/project-name/topics/my_integration_notifs Created notification config projects/_/buckets/bucket-name/notificationConfigs/1

Nella console Google Cloud , vai alla pagina Argomenti per Pub/Sub.

Fai clic sull'argomento my_integration_notifs che hai creato.

Nella pagina my_integration_notifs, vai in fondo alla pagina. Verifica che la scheda Abbonamenti sia attiva e che venga visualizzato il messaggio Nessun abbonamento da visualizzare.

Fai clic su Crea sottoscrizione.

Nel menu visualizzato, seleziona Crea sottoscrizione.

Nella pagina Aggiungi sottoscrizione all'argomento:

- Nel campo ID sottoscrizione, inserisci

my_integration_notifs_sub. - Imposta il valore Scadenza conferma su

120secondi. In questo modo, Dataflow ha tempo sufficiente per riconoscere i file che ha elaborato e contribuisce a migliorare il rendimento complessivo del job Dataflow. Per maggiori informazioni sulle proprietà delle sottoscrizioni Pub/Sub, consulta Proprietà delle sottoscrizioni. - Lascia invariati tutti gli altri valori predefiniti della pagina.

- Fai clic su Crea.

- Nel campo ID sottoscrizione, inserisci

Più avanti in questo tutorial, creerai un job Dataflow. Nell'ambito della creazione di questo job, assegni a Dataflow il ruolo di abbonato alla sottoscrizione my_integration_notifs_sub. In questo modo, Dataflow può ricevere notifiche sui nuovi file che Datastream scrive in Cloud Storage, elaborare i file e trasferire le modifiche ai dati in BigQuery.

Crea set di dati in BigQuery

In questa sezione, crei set di dati in BigQuery. BigQuery utilizza i set di dati per contenere i dati che riceve da Dataflow. Questi dati rappresentano le modifiche nel database MySQL di origine che Datastream trasmette in streaming nel tuo bucket Cloud Storage.

Vai alla pagina SQL Workspace per BigQuery nella console Google Cloud .

Nel riquadro Explorer, accanto al nome del progetto Google Cloud , fai clic su Visualizza azioni.

Nel menu visualizzato, seleziona Crea set di dati.

Nella finestra Crea set di dati:

- Nel campo ID set di dati, inserisci un ID per il set di dati. Per questo tutorial, inserisci

My_integration_dataset_lognel campo. - Lascia invariati tutti gli altri valori predefiniti nella finestra.

- Fai clic su Crea set di dati.

- Nel campo ID set di dati, inserisci un ID per il set di dati. Per questo tutorial, inserisci

Nel riquadro Explorer, accanto al nome del progetto Google Cloud , fai clic su Espandi nodo e verifica di visualizzare il set di dati che hai creato.

Utilizza i passaggi di questa procedura per creare un secondo set di dati: My_integration_dataset_final.

Accanto a ogni set di dati, espandi Espandi nodo.

Verifica che ogni set di dati sia vuoto.

Dopo che Datastream trasmette in streaming le modifiche ai dati dal database di origine al bucket Cloud Storage, un job Dataflow elabora i file contenenti le modifiche e le trasferisce nei set di dati BigQuery.

Crea profili di connessione in Datastream

In questa sezione, crei profili di connessione in Datastream per un database di origine e una destinazione. Durante la creazione dei profili di connessione, seleziona MySQL come tipo di profilo per il profilo di connessione di origine e Cloud Storage come tipo di profilo per il profilo di connessione di destinazione.

Datastream utilizza le informazioni definite nei profili di connessione per connettersi sia all'origine sia alla destinazione, in modo da poter trasmettere in streaming i dati dal database di origine al bucket di destinazione in Cloud Storage.

Crea un profilo di connessione di origine per il database MySQL

Nella console Google Cloud , vai alla pagina Profili di connessione per Datastream.

Fai clic su Crea profilo.

Per creare un profilo di connessione di origine per il database MySQL, nella pagina Crea un profilo di connessione, fai clic sul tipo di profilo MySQL.

Nella sezione Definisci le impostazioni di connessione della pagina Crea profilo MySQL, fornisci le seguenti informazioni:

- Nel campo Nome profilo di connessione, inserisci

My Source Connection Profile. - Mantieni l'ID profilo di connessione generato automaticamente.

Seleziona la regione in cui vuoi archiviare il profilo di connessione.

Inserisci i dettagli della connessione:

- Nel campo Nome host o IP, inserisci un nome host o un indirizzo IP pubblico che Datastream possa utilizzare per la connessione al database di origine. Stai fornendo un indirizzo IP pubblico perché utilizzi la lista consentita IP come metodo di connettività di rete per questo tutorial.

- Nel campo Porta, inserisci il numero di porta riservato al database di origine. Per un database MySQL, la porta predefinita è in genere

3306. - Inserisci un Nome utente e una Password per l'autenticazione al database di origine.

- Nel campo Nome profilo di connessione, inserisci

Nella sezione Definisci impostazioni di connessione, fai clic su Continua. La sezione Proteggi la connessione all'origine della pagina Crea profilo MySQL è attiva.

Nel menu Tipo di crittografia, seleziona Nessuno. Per ulteriori informazioni su questo menu, consulta Crea un profilo di connessione per il database MySQL.

Nella sezione Proteggi la connessione all'origine, fai clic su Continua. La sezione Definisci metodo di connettività della pagina Crea profilo MySQL è attiva.

Nel menu a discesa Metodo di connettività, scegli il metodo di networking che vuoi utilizzare per stabilire la connettività tra Datastream e il database di origine. Per questo tutorial, seleziona Lista consentita IP come metodo di connettività.

Configura il database di origine in modo da consentire le connessioni in entrata dagli indirizzi IP pubblici di Datastream visualizzati.

Nella sezione Definisci metodo di connettività, fai clic su Continua. La sezione Testa profilo di connessione della pagina Crea profilo MySQL è attiva.

Fai clic su Esegui test per verificare che il database di origine e Datastream possano comunicare tra loro.

Verifica che sia visualizzato lo stato Test superato.

Fai clic su Crea.

Crea un profilo di connessione di destinazione per Cloud Storage

Nella console Google Cloud , vai alla pagina Profili di connessione per Datastream.

Fai clic su Crea profilo.

Per creare un profilo di connessione di destinazione per Cloud Storage, nella pagina Crea un profilo di connessione, fai clic sul tipo di profilo Cloud Storage.

Nella pagina Crea profilo Cloud Storage, fornisci le seguenti informazioni:

- Nel campo Nome profilo di connessione, inserisci

My Destination Connection Profile. - Mantieni l'ID profilo di connessione generato automaticamente.

- Seleziona la regione in cui vuoi archiviare il profilo di connessione.

Nel riquadro Dettagli connessione, fai clic su Sfoglia per selezionare il bucket Cloud Storage che hai creato in precedenza in questo tutorial. Questo è il bucket in cui Datastream trasferisce i dati dal database di origine. Dopo aver effettuato la selezione, fai clic su Seleziona.

Il tuo bucket viene visualizzato nel campo Nome bucket del riquadro Dettagli connessione.

Nel campo Prefisso di percorso del profilo di connessione, fornisci un prefisso per il percorso che vuoi aggiungere al nome bucket quando Datastream trasmette i dati alla destinazione. Assicurati che Datastream scriva i dati in un percorso all'interno del bucket, non nella cartella principale del bucket. Per questo tutorial, utilizza il percorso che hai definito quando hai configurato la notifica Pub/Sub. Inserisci

/integration/tutorialnel campo.

- Nel campo Nome profilo di connessione, inserisci

Fai clic su Crea.

Dopo aver creato un profilo di connessione di origine per il database MySQL e un profilo di connessione di destinazione per Cloud Storage, puoi utilizzarli per creare uno stream.

Crea uno stream in Datastream

In questa sezione, creerai uno stream. Questo stream utilizza le informazioni nei profili di connessione per trasferire i dati da un database MySQL di origine a un bucket di destinazione in Cloud Storage.

Definisci le impostazioni per lo stream

Nella console Google Cloud , vai alla pagina Stream di Datastream.

Fai clic su Crea stream.

Fornisci le seguenti informazioni nel riquadro Definisci dettagli flusso della pagina Crea stream:

- Nel campo Nome stream, inserisci

My Stream. - Mantieni l'ID stream generato automaticamente.

- Nel menu Regione, seleziona la regione in cui hai creato i profili di connessione di origine e di destinazione.

- Nel menu Tipo di origine, seleziona il tipo di profilo MySQL.

- Nel menu Tipo di destinazione, seleziona il tipo di profilo Cloud Storage.

- Nel campo Nome stream, inserisci

Rivedi i prerequisiti richiesti generati automaticamente per riflettere la preparazione dell'ambiente per uno stream. Questi prerequisiti possono includere la configurazione del database di origine e la connessione di Datastream al bucket di destinazione in Cloud Storage.

Fai clic su Continua. Viene visualizzato il riquadro Definisci profilo di connessione MySQL della pagina Crea stream.

Specifica le informazioni sul profilo di connessione di origine

In questa sezione, seleziona il profilo di connessione che hai creato per il database di origine (il profilo di connessione di origine). Per questo tutorial, è Il mio profilo di connessione di origine.

Nel menu Profilo di connessione di origine, seleziona il profilo di connessione di origine per il database MySQL.

Fai clic su Esegui test per verificare che il database di origine e Datastream possano comunicare tra loro.

Se il test non va a buon fine, viene visualizzato il problema associato al profilo di connessione. Per la procedura di risoluzione dei problemi, consulta la pagina Diagnostica i problemi. Apporta le modifiche necessarie per correggere il problema e poi esegui di nuovo il test.

Fai clic su Continua. Viene visualizzato il riquadro Configura origine stream della pagina Crea stream.

Configura le informazioni sul database di origine per lo stream

In questa sezione, configura le informazioni sul database di origine per lo stream specificando le tabelle e gli schemi nel database di origine che Datastream:

- Può essere trasferito nella destinazione.

- Non è possibile trasferire il saldo nella destinazione.

Determina inoltre se Datastream esegue il backfill dei dati storici, se trasmette in streaming le modifiche in corso nella destinazione o se trasmette in streaming solo le modifiche ai dati.

Utilizza il menu Oggetti da includere per specificare le tabelle e gli schemi nel database di origine che Datastream può trasferire in una cartella nel bucket di destinazione in Cloud Storage. Il menu viene caricato solo se il database contiene fino a 5000 oggetti.

Per questo tutorial, vuoi che Datastream trasferisca tutte le tabelle e gli schemi. Pertanto, seleziona Tutte le tabelle di tutti gli schemi dal menu.

Verifica che il riquadro Seleziona gli oggetti da escludere sia impostato su Nessuno. Non vuoi impedire a Datastream di trasferire tabelle e schemi dal database di origine a Cloud Storage.

Verifica che il riquadro Scegli la modalità di backfill per i dati storici sia impostato su Automatico. Datastream trasmette in streaming tutti i dati esistenti, oltre alle modifiche ai dati, dall'origine alla destinazione.

Fai clic su Continua. Viene visualizzato il riquadro Definisci profilo di connessione Cloud Storage della pagina Crea stream.

Seleziona un profilo di connessione di destinazione

In questa sezione, seleziona il profilo di connessione che hai creato per Cloud Storage (il profilo di connessione di destinazione). Per questo tutorial, è My Destination Connection Profile.

Nel menu Profilo di connessione di destinazione, seleziona il tuo profilo di connessione di destinazione per Cloud Storage.

Fai clic su Continua. Viene visualizzato il riquadro Configura destinazione stream della pagina Crea stream.

Configura le informazioni sulla destinazione dello stream

In questa sezione configuri le informazioni sul bucket di destinazione per lo stream. Queste informazioni comprendono:

- Il formato di output dei file scritti in Cloud Storage.

- La cartella del bucket di destinazione in cui Datastream trasferisce schemi, tabelle e dati dal database di origine.

Nel campo Formato di output, seleziona il formato dei file scritti in Cloud Storage. Datastream supporta due formati di output: Avro e JSON. Per questo tutorial, Avro è il formato file.

Fai clic su Continua. Viene visualizzato il riquadro Rivedi dettagli flusso e crea della pagina Crea stream.

Crea lo stream

Verifica i dettagli dello stream, nonché i profili di connessione di origine e di destinazione che lo stream utilizza per trasferire i dati da un database MySQL di origine a un bucket di destinazione in Cloud Storage.

Per convalidare lo stream, fai clic su Esegui convalida. Convalidando uno stream, Datastream verifica che l'origine sia configurata correttamente, che lo stream possa connettersi sia all'origine che alla destinazione e che la configurazione end-to-end dello stream sia corretta.

Dopo aver superato tutti i controlli di convalida, fai clic su Crea.

Nella finestra di dialogo Crea stream?, fai clic su Crea.

Avviare lo stream

Per questo tutorial, crei e avvii un flusso separatamente nel caso in cui il processo di creazione del flusso comporti un carico maggiore sul database di origine. Per posticipare il carico, crei lo stream senza avviarlo e poi lo avvii quando il database è in grado di gestirlo.

Avviando lo stream, Datastream può trasferire dati, schemi e tabelle dal database di origine alla destinazione.

Nella console Google Cloud , vai alla pagina Stream di Datastream.

Seleziona la casella di controllo accanto allo stream che vuoi avviare. Per questo tutorial, questo è Il mio stream.

Fai clic su Avvia.

Nella finestra di dialogo, fai clic su Avvia. Lo stato dello stream cambia da

Not startedaStartinge poi aRunning.

Dopo aver avviato uno stream, puoi verificare che Datastream abbia trasferito i dati dal database di origine alla destinazione.

Verifica lo stream

In questa sezione, confermi che Datastream trasferisce i dati da tutte le tabelle di un database MySQL di origine nella cartella /integration/tutorial del bucket di destinazione Cloud Storage.

Nella console Google Cloud , vai alla pagina Stream di Datastream.

Fai clic sullo stream che hai creato. Per questo tutorial, questo è Il mio stream.

Nella pagina Dettagli stream, fai clic sul link bucket-name/integration/tutorial, dove bucket-name è il nome che hai assegnato al bucket Cloud Storage. Questo link viene visualizzato dopo il campo Percorso scrittura destinazione. La pagina Dettagli bucket di Cloud Storage si apre in una scheda separata.

Verifica che siano visualizzate cartelle che rappresentano le tabelle del database di origine.

Fai clic su una delle cartelle delle tabelle e poi su ogni sottocartella finché non visualizzi i dati associati alla tabella.

Crea un job Dataflow

In questa sezione, creerai un job in Dataflow. Dopo che Datastream trasmette in streaming le modifiche ai dati da un database MySQL di origine al tuo bucket Cloud Storage, Pub/Sub invia notifiche a Dataflow sui nuovi file contenenti le modifiche. Il job Dataflow elabora i file e trasferisce le modifiche in BigQuery.

Nella console Google Cloud , vai alla pagina Job per Dataflow.

Fai clic su Crea job da modello.

Nel campo Nome job della pagina Crea job da modello, inserisci un nome per il job Dataflow che stai creando. Per questo tutorial, inserisci

my-dataflow-integration-jobnel campo.Nel menu Endpoint a livello di regione, seleziona la regione in cui vuoi archiviare il job. Si tratta della stessa regione selezionata per il profilo di connessione di origine, il profilo di connessione di destinazione e lo stream che hai creato.

Nel menu Modello Dataflow, seleziona il modello che utilizzi per creare il job. Per questo tutorial, seleziona Datastream a BigQuery.

Dopo aver effettuato questa selezione, vengono visualizzati altri campi correlati a questo modello.

Nel campo Posizione del file per l'output del file Datastream in Cloud Storage, inserisci il nome del bucket Cloud Storage utilizzando il seguente formato:

gs://bucket-name.Nel campo Abbonamento Pub/Sub utilizzato in un criterio di notifica di Cloud Storage, inserisci il percorso che contiene il nome dell'abbonamento Pub/Sub. Per questo tutorial, inserisci

projects/project-name/subscriptions/my_integration_notifs_sub.Nel campo Formato file di output di Datastream (avro/json), inserisci

avroperché, per questo tutorial, Avro è il formato dei file che Datastream scrive in Cloud Storage.Nel campo Nome o modello del set di dati che deve contenere le tabelle di staging, inserisci

My_integration_dataset_logperché Dataflow utilizza questo set di dati per eseguire lo staging delle modifiche ai dati che riceve da Datastream.Nel campo Modello per il set di dati che deve contenere le tabelle di replica, inserisci

My_integration_dataset_finalperché questo è il set di dati in cui vengono unite le modifiche temporanee nel set di dati My_integration_dataset_log per creare una replica uno a uno delle tabelle nel database di origine.Nel campo Directory della coda di messaggi non recapitabili, inserisci il percorso che contiene il nome del bucket Cloud Storage e una cartella per una coda di messaggi non recapitabili. Assicurati di non utilizzare un percorso nella cartella principale e che il percorso sia diverso da quello in cui Datastream scrive i dati. Le modifiche ai dati che Dataflow non riesce a trasferire in BigQuery vengono archiviate nella coda. Puoi correggere i contenuti nella coda in modo che Dataflow possa rielaborarli.

Per questo tutorial, inserisci

gs://bucket-name/dlqnel campo Directory della coda di messaggi non recapitabili (dove bucket-name è il nome del tuo bucket e dlq è la cartella della coda di messaggi non recapitabili).Fai clic su Esegui job.

Verificare l'integrazione

Nella sezione Verifica lo stream di questo tutorial, hai confermato che Datastream ha trasferito i dati da tutte le tabelle di un database MySQL di origine nella cartella /integration/tutorial del bucket di destinazione Cloud Storage.

In questa sezione, verifichi che Dataflow elabori i file contenenti le modifiche associate a questi dati e trasferisca le modifiche in BigQuery. Di conseguenza, hai un'integrazione end-to-end tra Datastream e BigQuery.

Nella console Google Cloud , vai alla pagina Area di lavoro SQL per BigQuery.

Nel riquadro Explorer, espandi il nodo accanto al nome del progetto Google Cloud .

Espandi i nodi accanto ai set di dati My_integration_dataset_log e My_integration_dataset_final.

Verifica che ogni set di dati ora contenga dati. Ciò conferma che Dataflow ha elaborato i file contenenti le modifiche associate ai dati che Datastream ha trasmesso in streaming a Cloud Storage e ha trasferito queste modifiche in BigQuery.

Esegui la pulizia

Per evitare che al tuo account Google Cloud vengano addebitati costi relativi alle risorse utilizzate in questo tutorial, utilizza la console Google Cloud per svolgere le seguenti operazioni:

- Elimina il progetto, lo stream Datastream e i profili di connessione Datastream.

- Arresta il job Dataflow.

- Elimina i set di dati BigQuery, l'argomento e l'abbonamento Pub/Sub e il bucket Cloud Storage.

Se pulisci le risorse che hai creato su Datastream, Dataflow, BigQuery, Pub/Sub e Cloud Storage, impedisci che le risorse occupino la quota e non ti verranno addebitate in futuro.

Elimina il progetto

Il modo più semplice per eliminare la fatturazione è eliminare il progetto che hai creato per questo tutorial.

Nella console Google Cloud , vai alla pagina Gestisci risorse.

Nell'elenco dei progetti, seleziona il progetto che vuoi eliminare, quindi fai clic su Elimina.

Per eliminare il progetto, nella finestra di dialogo, digita l'ID progetto e fai clic su Chiudi.

Elimina lo stream

Nella console Google Cloud , vai alla pagina Stream di Datastream.

Fai clic sullo stream che vuoi eliminare. Per questo tutorial, questo è Il mio stream.

Fai clic su Metti in pausa.

Nella finestra di dialogo, fai clic su Metti in pausa.

Nel riquadro Stato stream della pagina Dettagli stream, verifica che lo stato dello stream sia

Paused.Fai clic su Elimina.

Nella finestra di dialogo, inserisci

Deletenel campo di testo e fai clic su Elimina.

Eliminare i profili di connessione

Nella console Google Cloud , vai alla pagina Profili di connessione per Datastream.

Seleziona la casella di controllo per ogni profilo di connessione da eliminare: Il mio profilo di connessione di origine e Il mio profilo di connessione di destinazione.

Fai clic su Elimina.

Nella finestra di dialogo, fai clic su Elimina.

Arresta il job Dataflow

Nella console Google Cloud , vai alla pagina Job per Dataflow.

Fai clic sul job che vuoi interrompere. Per questo tutorial, è my-dataflow-integration-job.

Fai clic su Arresta.

Nella finestra di dialogo Arresta job, seleziona l'opzione Svuota, quindi fai clic su Arresta job.

Elimina i set di dati BigQuery

Nella console Google Cloud , vai alla pagina Area di lavoro SQL per BigQuery.

Nel riquadro Explorer, espandi il nodo accanto al nome del progetto Google Cloud .

Fai clic sul pulsante Visualizza azioni a destra di uno dei set di dati che hai creato in Creare set di dati in BigQuery. Questo pulsante ha l'aspetto di un'ellissi verticale.

Per questo tutorial, fai clic sul pulsante Visualizza azioni a destra di My_integration_dataset_log.

Seleziona Elimina dal menu a discesa visualizzato.

Nella finestra di dialogo Vuoi eliminare il set di dati?, inserisci

deletenel campo di testo e fai clic su Elimina.Ripeti i passaggi di questa procedura per eliminare il secondo set di dati che hai creato: My_integration_dataset_final.

Elimina l'argomento e la sottoscrizione Pub/Sub

Nella console Google Cloud , vai alla pagina Sottoscrizioni per Pub/Sub.

Fai clic sulla casella di controllo accanto all'abbonamento da eliminare. Per questo tutorial, fai clic sulla casella di controllo accanto all'abbonamento my_integration_notifs_sub.

Fai clic su Elimina.

Nella finestra di dialogo Elimina abbonamento, fai clic su Elimina.

Nella console Google Cloud , vai alla pagina Argomenti per Pub/Sub.

Fai clic sulla casella di controllo accanto all'argomento my_integration_notifs.

Fai clic su Elimina.

Nella finestra di dialogo Elimina argomento, inserisci

deletenel campo di testo e fai clic su Elimina.

Elimina il bucket Cloud Storage

Nella console Google Cloud , vai alla pagina Browser per Cloud Storage.

Seleziona la casella di controllo accanto al tuo bucket.

Fai clic su Elimina.

Nella finestra di dialogo, inserisci

Deletenel campo di testo e fai clic su Elimina.

Passaggi successivi

- Scopri di più su Datastream.

- Utilizza l'API Streaming precedente per eseguire funzionalità avanzate con lo streaming di dati in BigQuery.

- Prova le altre funzionalità di Google Cloud . Dai un'occhiata ai nostri tutorial.