Etapa 3: determinar o mecanismo de integração

Esta página descreve a terceira etapa para implantar a Data Foundation do Cortex Framework, o núcleo do Cortex Framework. Nesta etapa, você vai configurar a integração com a fonte de dados escolhida. Se você estiver usando dados de amostra, pule esta etapa.

Visão geral da integração

O Cortex Framework ajuda a centralizar dados de várias fontes, além de outras plataformas. Isso cria uma única fonte de verdade para seus dados. A Cortex Data Foundation se integra a cada fonte de dados de maneiras diferentes, mas a maioria delas segue um procedimento semelhante:

- Camada de origem para bruta:ingere dados da fonte para o conjunto de dados brutos usando APIs. Isso é feito usando pipelines do Dataflow acionados por DAGs do Cloud Composer.

- Camada bruta para camada de CDC: aplique o processamento de CDC ao conjunto de dados brutos e armazene a saída no conjunto de dados de CDC. Isso é feito com DAGs do Cloud Composer que executam SQLs do BigQuery.

- Camada de CDC para camada de relatórios:cria tabelas de relatórios finais com base em tabelas de CDC no conjunto de dados de relatórios. Isso é feito criando visualizações de tempo de execução sobre tabelas de CDC ou executando DAGs do Cloud Composer para dados materializados em tabelas do BigQuery, dependendo da configuração. Para mais informações sobre a configuração, consulte Personalizar o arquivo de configurações de relatórios.

O arquivo config.json configura as definições necessárias para se conectar a fontes de dados e transferir dados de várias cargas de trabalho. Consulte as opções de integração para cada fonte de dados nos seguintes recursos.

- Operacional:

- Marketing:

- Sustentabilidade:

Para mais informações sobre os diagramas de entidade-relacionamento que cada fonte de dados oferece suporte, consulte a pasta docs no repositório da Data Foundation do Cortex Framework.

Implantação de K9

O implantador do K9 simplifica a integração de várias fontes de dados. O implantador do K9 é um conjunto de dados predefinido no ambiente do BigQuery responsável pela ingestão, processamento e modelagem de componentes reutilizáveis em diferentes fontes de dados.

Por exemplo, a dimensão time pode ser reutilizada em todas as fontes de dados em que as tabelas precisam usar resultados analíticos com base em um calendário gregoriano. O implantador do K9 combina dados externos, como clima ou Google Trends, com outras fontes de dados (por exemplo, SAP, Salesforce, marketing). Esse conjunto de dados enriquecido permite insights mais profundos e análises mais abrangentes.

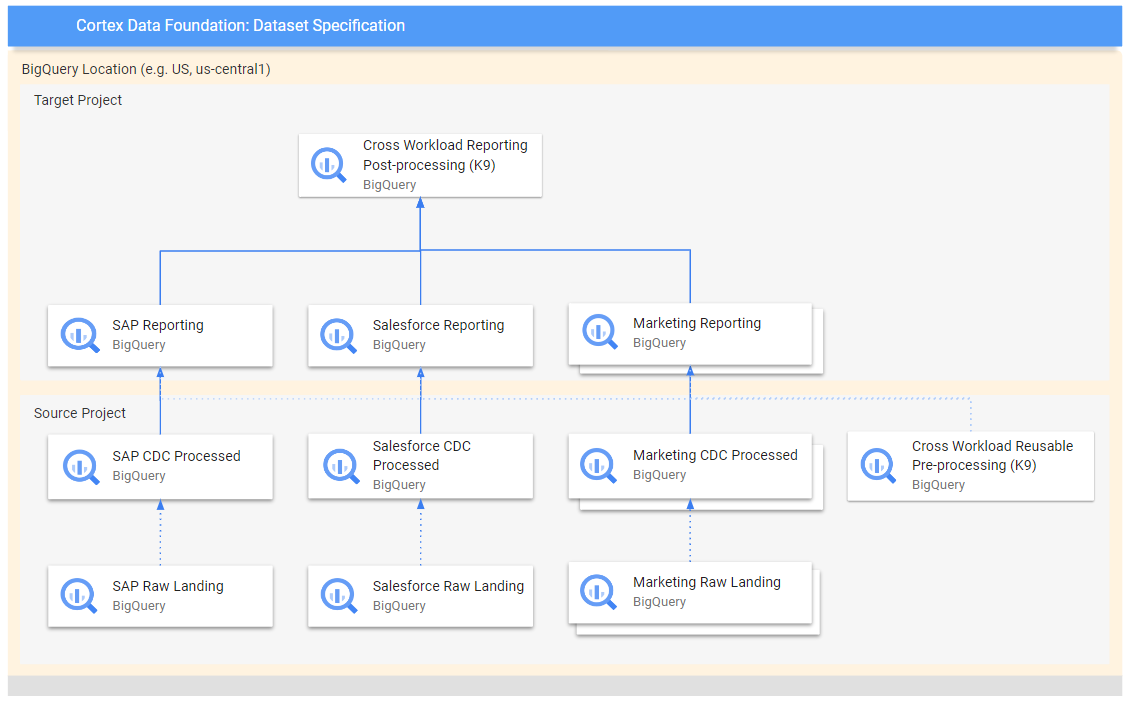

O diagrama a seguir mostra o fluxo de dados de diferentes fontes brutas para várias camadas de relatórios:

No diagrama, o projeto de origem contém os dados brutos das fontes escolhidas (SAP, Salesforce e Marketing). O projeto de destino contém dados processados, derivados do processo de captura de dados alterados (CDC).

A etapa de pré-processamento do K9 é executada antes que todas as cargas de trabalho iniciem a implantação. Assim, os modelos reutilizáveis ficam disponíveis durante a implantação. Essa etapa transforma dados de várias fontes para criar um conjunto de dados consistente e reutilizável.

As etapas de pós-processamento do K9 ocorrem depois que todas as cargas de trabalho implantam os modelos de relatórios para ativar a geração de relatórios entre cargas de trabalho ou aumentar os modelos para encontrar as dependências necessárias em cada conjunto de dados de relatórios individual.

Configurar a implantação do K9

Configure os gráficos acíclicos dirigidos (DAGs) e os modelos a serem gerados no arquivo de manifesto K9.

A etapa de pré-processamento do K9 é importante porque garante que todas as cargas de trabalho no pipeline de dados tenham acesso a dados preparados de forma consistente. Isso reduz a redundância e garante a consistência dos dados.

Para mais informações sobre como configurar conjuntos de dados externos para o K9, consulte Configurar conjuntos de dados externos para o K9.

Próximas etapas

Depois de concluir essa etapa, siga para as etapas de implantação a seguir:

- Estabelecer cargas de trabalho.

- Clonar repositório.

- Determine o mecanismo de integração (esta página).

- Configurar componentes.

- Configurar a implantação.

- Executar a implantação.