TPU v6e

이 문서에서는 Cloud TPU v6e(Trillium)의 아키텍처 및 지원되는 구성에 대해 설명합니다.

Trillium은 Cloud TPU의 최신 세대 AI 가속기입니다. API 및 로그와 같은 모든 기술적 측면과 이 문서 전체에서 Trillium은 v6e로 지칭됩니다.

포드당 256개의 칩 공간을 갖춘 v6e는 v5e와 많은 유사점을 공유합니다. 이 시스템은 변환기, 텍스트-이미지, 컨볼루셔널 신경망(CNN) 학습, 미세 조정, 서빙에 높은 효용성을 제공하는 제품이 되도록 최적화되어 있습니다.

시스템 아키텍처

각 v6e 칩에는 TensorCore 하나가 포함됩니다. 각 TensorCore에는 행렬 곱셈 단위(MXU) 2개, 벡터 단위 1개, 스칼라 단위 1개가 있습니다. 다음 표에는 TPU v5e와 비교한 TPU v6e의 주요 사양과 값이 표시되어 있습니다.

| 사양 | v5e | v6e |

|---|---|---|

| 성능/총소유비용(TCO)(예상) | 0.65x | 1 |

| 칩당 최고 컴퓨팅(bf16) | 197TFLOPs | 918 TFLOPs |

| 칩당 최고 컴퓨팅(Int8) | 393 TOPs | 1836 TOPs |

| 칩당 HBM 용량 | 16GB | 32GB |

| 칩당 HBM 대역폭 | 800GBps | 1600GBps |

| 칩 간 상호 연결(ICI) 대역폭 | 1600Gbps | 3200Gbps |

| 칩당 ICI 포트 | 4 | 4 |

| 호스트당 DRAM | 512GiB | 1,536GiB |

| 호스트당 칩 | 8 | 8 |

| TPU Pod 크기 | 칩 256개 | 칩 256개 |

| 상호 연결 토폴로지 | 2D 토러스 | 2D 토러스 |

| 포드당 BF16 최고 컴퓨팅 | 50.63 PFLOPs | 234.9 PFLOPs |

| 포드당 올리듀스 대역폭 | 51.2TB/초 | 102.4 TB/s |

| 포드당 바이섹션 대역폭 | 1.6TB/초 | 3.2 TB/s |

| 호스트별 NIC 구성 | 100Gbps NIC 2개 | 4 x 200 Gbps NIC |

| 포드당 데이터 센터 네트워크 대역폭 | 6.4Tbps | 25.6Tbps |

| 특징 | - | SparseCore |

지원되는 구성

다음 표에는 v6e에서 지원되는 2D 슬라이스 형태가 나와 있습니다.

| 토폴로지 | TPU 칩 | 호스트 | VM | 가속기 유형(TPU API) | 머신 유형(GKE API) | 범위 |

|---|---|---|---|---|---|---|

| 1x1 | 1 | 1/8 | 1 | v6e-1 |

ct6e-standard-1t |

하위 호스트 |

| 2x2 | 4 | 1/2 | 1 | v6e-4 |

ct6e-standard-4t |

하위 호스트 |

| 2x4 | 8 | 1 | 1 | v6e-8 |

ct6e-standard-8t |

단일 호스트 |

| 2x4 | 8 | 1 | 2 | - | ct6e-standard-4t |

단일 호스트 |

| 4x4 | 16 | 2 | 4 | v6e-16 |

ct6e-standard-4t |

멀티 호스트 |

| 4x8 | 32 | 4 | 8 | v6e-32 |

ct6e-standard-4t |

멀티 호스트 |

| 8x8 | 64 | 8 | 16 | v6e-64 |

ct6e-standard-4t |

멀티 호스트 |

| 8x16 | 128 | 16 | 32 | v6e-128 |

ct6e-standard-4t |

멀티 호스트 |

| 16x16 | 256 | 32 | 64 | v6e-256 |

ct6e-standard-4t |

멀티 호스트 |

단일 VM에 연결된 8개의 칩(v6e-8)이 있는 슬라이스는 추론에 최적화되어 단일 서빙 워크로드에서 8개의 칩을 모두 사용할 수 있습니다. Cloud에서 Pathways를 사용하여 멀티 호스트 추론을 수행할 수 있습니다. 자세한 내용은 Pathways를 사용하여 멀티 호스트 추론 수행을 참조하세요.

각 토폴로지의 VM 수에 대한 자세한 내용은 VM 유형을 참조하세요.

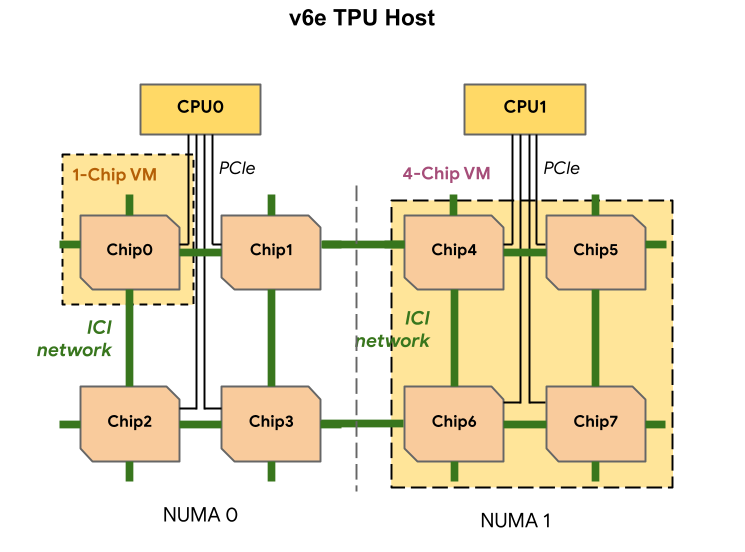

VM 유형

각 TPU v6e VM에는 1개, 4개 또는 8개의 칩이 포함될 수 있습니다. 4칩의 작은 슬라이스는 동일한 비균일 메모리 액세스(NUMA) 노드를 갖게 됩니다. NUMA 노드에 대한 자세한 내용은 Wikipedia에서 비균일 메모리 액세스를 참고하세요.

v6e 슬라이스는 각각 TPU 칩 4개가 있는 절반 호스트 VM을 사용하여 생성됩니다. 이 규칙에는 두 가지 예외가 있습니다.

v6e-1: 테스트를 위해 설계된 단일 칩 VMv6e-8: 단일 VM에 8개의 칩이 모두 연결되어 추론 사용 사례에 최적화된 전체 호스트 VM

다음 표에서는 TPU v6e VM 유형을 비교합니다.

| VM 유형 | VM당 vCPU 수 | VM당 RAM(GB) | VM당 NUMA 노드 수 |

|---|---|---|---|

| 1칩 VM | 44 | 176 | 1 |

| 4칩 VM | 180 | 720 | 1 |

| 8칩 VM | 180 | 1440 | 2 |

v6e 구성 지정

TPU API를 사용하여 TPU v6e 슬라이스를 할당할 때 AcceleratorType 매개변수를 사용하여 크기와 모양을 지정합니다.

GKE를 사용하는 경우 --machine-type 플래그를 사용하여 사용하려는 TPU를 지원하는 머신 유형을 지정합니다. 자세한 내용은 GKE 문서의 GKE에서 TPU 계획을 참고하세요.

AcceleratorType 사용

TPU 리소스를 할당할 때 AcceleratorType을 사용하여 슬라이스에서 TensorCore 수를 지정합니다. AcceleratorType에 지정하는 값은 v$VERSION-$TENSORCORE_COUNT 형식의 문자열입니다.

예를 들어 v6e-8은 TensorCore 8개가 있는 v6e TPU 슬라이스를 지정합니다.

다음 예시에서는 AcceleratorType을 사용하여 TensorCore 32개가 포함된 TPU v6e 슬라이스를 만드는 방법을 보여줍니다.

gcloud

$ gcloud compute tpus tpu-vm create tpu-name \ --zone=zone \ --accelerator-type=v6e-32 \ --version=v2-alpha-tpuv6e

콘솔

Google API 콘솔에서 TPU 페이지로 이동합니다.

TPU 만들기를 클릭합니다.

이름 필드에 TPU의 이름을 입력합니다.

영역 상자에서 TPU를 만들 영역을 선택합니다.

TPU 유형 상자에서

v6e-32를 선택합니다.TPU 소프트웨어 버전 상자에서

v2-alpha-tpuv6e를 선택합니다. Cloud TPU VM을 만들 때 TPU 소프트웨어 버전은 설치할 TPU 런타임 버전을 지정합니다. 자세한 내용은 TPU VM 이미지를 참고하세요.큐 사용 설정 전환 버튼을 클릭합니다.

큐에 추가된 리소스 이름 필드에 큐에 추가된 리소스 요청의 이름을 입력합니다.

만들기를 클릭합니다.