您可以使用 Dataplex 通用目錄資料品質工作,在 BigQuery 和 Cloud Storage 的資料表中定義並執行資料品質檢查。您也可以透過 Dataplex 通用目錄資料品質工作,在 BigQuery 環境中套用一般資料控管機制。

建立 Dataplex 通用目錄資料品質工作時機

Dataplex 通用目錄資料品質工作可協助您完成以下工作:

- 在資料製作管道中驗證資料。

- 定期監控資料集品質是否符合預期。

- 根據法規要求建立資料品質報表。

優點

- 可自訂規格。您可以使用高度彈性的 YAML 語法宣告資料品質規則。

- 無伺服器導入方式。Dataplex 通用目錄不需要任何基礎架構設定。

- 零複製和自動推送。YAML 檢查會轉換為 SQL,並推送至 BigQuery,因此不會複製資料。

- 可排定時間的資料品質檢查。您可以透過 Dataplex 通用目錄中的無伺服器排程器安排資料品質檢查,也可以透過 Cloud Composer 等外部排程器使用 Dataplex API 進行管道整合。

- 受管理的體驗。Dataplex 通用目錄會使用開放原始碼資料品質引擎 CloudDQ 執行資料品質檢查。不過,Dataplex Universal Catalog 提供無縫管理體驗,可執行資料品質檢查。

資料品質任務的運作方式

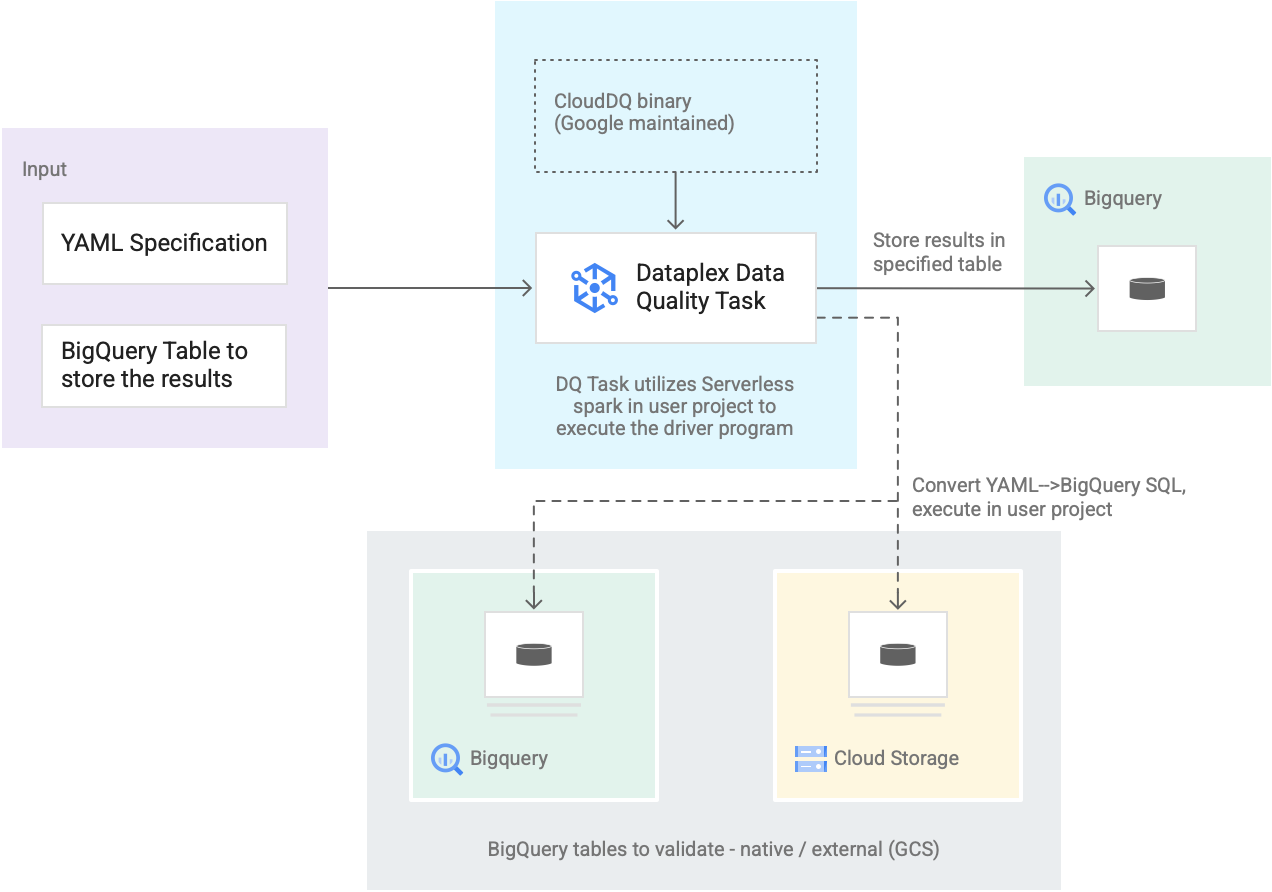

下圖說明 Dataplex 通用目錄資料品質工作的工作方式:

- 使用者意見回饋

- YAML 規格:一或多個 YAML 檔案組合,可根據規格語法定義資料品質規則。您可以將 YAML 檔案儲存在專案的 Cloud Storage 值區中。使用者可以同時執行多個規則,且這些規則可套用至不同的 BigQuery 資料表,包括不同資料集或 Google Cloud專案中的資料表。規格支援增量執行作業,但只會驗證新資料。如要建立 YAML 規格,請參閱「建立規格檔案」。

- BigQuery 結果資料表:使用者指定的資料表,用於儲存資料品質驗證結果。這個資料表所在的 Google Cloud 專案可以與使用 Dataplex 通用目錄資料品質工作時的專案不同。

- 要驗證的資料表

- 在 YAML 規格中,您需要指定要針對哪些規則驗證哪些資料表,這也稱為「規則繫結」。資料表可以是 BigQuery 原生資料表,也可以是 Cloud Storage 中的 BigQuery 外部資料表。您可以使用 YAML 規格,指定 Dataplex 通用目錄區域內或外的資料表。

- 在單一執行作業中驗證的 BigQuery 和 Cloud Storage 資料表可以屬於不同的專案。

- Dataplex 通用目錄資料品質工作:Dataplex 通用目錄資料品質工作會使用預先建構且維護的 CloudDQ PySpark 二進位檔進行設定,並採用 YAML 規格和 BigQuery 結果資料表做為輸入內容。與其他 Dataplex 通用目錄工作一樣,Dataplex 通用目錄資料品質工作會在無伺服器 Spark 環境中執行,將 YAML 規格轉換為 BigQuery 查詢,然後針對規格檔案中定義的資料表執行這些查詢。

定價

執行 Dataplex 通用目錄資料品質工作時,系統會向您收取 BigQuery 和 Dataproc Serverless (批次) 的使用費。

Dataplex 通用目錄資料品質工作會將規格檔案轉換為 BigQuery 查詢,並在使用者專案中執行這些查詢。請參閱 BigQuery 定價。

Dataplex 通用目錄會使用 Spark 執行 Google 維護的預先建構開放原始碼 CloudDQ 驅動程式,將使用者規格轉換為 BigQuery 查詢。請參閱「Dataproc Serverless 定價」。

您可以使用 Dataplex 通用目錄來整理資料,或使用 Dataplex 通用目錄中的無伺服器排程器來排定資料品質檢查時間,而無須支付任何費用。請參閱 Dataplex 通用目錄定價。