Se connecter à un réseau VPC

Nous vous recommandons d'utiliser la sortie VPC directe pour envoyer du trafic vers un réseau VPC sans avoir besoin de connecteur.

Toutefois, si la sortie VPC directe n'est pas une option pour vous, vous pouvez configurer un connecteur d'accès au VPC sans serveur à la place. Cette page explique comment connecter un service ou un job Cloud Run à votre réseau VPC à l'aide d'un connecteur, ce qui permet d'acheminer le trafic de sortie (sortant) depuis Cloud Run vers les instances de VM Compute Engine, les instances Memorystore et toute autre ressource disposant d'une adresse IP interne.

Avant de commencer

Si vous n'avez pas encore de réseau VPC dans votre projet, créez-en un.

Si vous utilisez un VPC partagé, consultez la documentation sur la configuration spécifique de l'accès au VPC sans serveur pour votre produit.

- Cloud Run : Se connecter à un réseau VPC partagé

- Cloud Run Functions : Se connecter à un réseau VPC partagé

- App Engine : Se connecter à un réseau VPC partagé

Si une contrainte de règle d'administration empêche l'utilisation de Cloud Deployment Manager, vous ne pourrez pas créer ni supprimer de connecteurs d'accès au VPC sans serveur. Pour créer ou supprimer un connecteur, vous devez disposer de la fonctionnalité Deployment Manager.

Si vous avez configuré un règlement relatif aux images de confiance pour votre projet, assurez-vous d'autoriser le projet

serverless-vpc-access-imagesdans la règle d'administrationconstraints/compute.trustedimageProjects.Exigences concernant les sous-réseaux des connecteurs

Chaque connecteur nécessite son propre sous-réseau dédié à usage privé (

PRIVATE) avec une plage d'adresses IPv4 principale/28. Ce sous-réseau ne peut pas être utilisé par d'autres ressources telles que les VM, Private Service Connect ou les équilibreurs de charge. Une fois le connecteur créé, le sous-réseau ne peut pas être étendu. Elle doit rester une/28.Pour créer un connecteur dans un projet de service qui utilise un réseau VPC partagé dans un projet hôte, un administrateur réseau du réseau VPC partagé doit créer manuellement le sous-réseau du connecteur avant que vous puissiez créer le connecteur.

Pour déterminer si un sous-réseau existant créé manuellement peut être utilisé par un connecteur, décrivez le sous-réseau :

gcloud compute networks subnets describe SUBNET --region=REGION

Remplacez SUBNET par le nom du sous-réseau et REGION par la région qui contient le sous-réseau.

Dans le résultat, vérifiez les points suivants :

- Le sous-réseau est un sous-réseau standard. Dans Google Cloud CLI, cela signifie que la valeur de usage est

PRIVATE(privé). - La plage d'adresses IPv4 principale du sous-réseau,

ipCidrRange, est une plage/28.

- Le sous-réseau est un sous-réseau standard. Dans Google Cloud CLI, cela signifie que la valeur de usage est

Si vous devez créer un connecteur d'accès au VPC sans serveur dans le même projet que celui qui contient le réseau VPC utilisé par le connecteur, vous pouvez créer manuellement le sous-réseau du connecteur avant de créer le connecteur, ou Google Cloud peut créer automatiquement le sous-réseau pour le connecteur.

Lorsque Google Cloud crée un sous-réseau pour un connecteur, tenez compte des points suivants :

Les sous-réseaux créés automatiquement pour les connecteurs ne sont pas visibles lorsque vous listez les sous-réseaux, que vous utilisiez la console Google Cloud , Google Cloud CLI ou l'API Compute Engine.

Les sous-réseaux créés automatiquement pour les connecteurs ne peuvent pas être décrits.

Les sous-réseaux créés automatiquement sont inclus dans la liste des sous-réseaux qui s'affiche lorsque vous décrivez un réseau VPC.

Pour en savoir plus sur les sous-réseaux, y compris comment lister ceux qui existent déjà pour déterminer les plages d'adresses IP déjà utilisées, consultez la section Utiliser des sous-réseaux.

Limites

Le trafic IPv6 n'est pas accepté.

Créer un connecteur

Pour envoyer des requêtes à votre réseau VPC et recevoir les réponses correspondantes sans utiliser l'Internet public, vous pouvez utiliser un connecteur d'accès au VPC sans serveur.

Si votre connecteur se trouve dans le même projet que son réseau VPC, vous pouvez soit créer un connecteur à l'aide d'un sous-réseau existant, soit créer un connecteur et un sous-réseau.

Si votre connecteur est situé dans un projet de service et utilise un réseau VPC partagé, alors le connecteur et le réseau VPC associé se trouvent dans des projets différents. Lorsqu'un connecteur et son réseau VPC se trouvent dans des projets différents, un administrateur de réseau VPC partagé doit créer le sous-réseau du connecteur dans le réseau VPC partagé avant que vous ne puissiez créer le connecteur. En outre, vous devez créer le connecteur à l'aide d'un sous-réseau existant.

Pour en savoir plus sur les exigences concernant les sous-réseaux, consultez Exigences concernant les sous-réseaux des connecteurs.

Pour en savoir plus sur le débit du connecteur, y compris le type de machine et le scaling, consultez Débit et scaling.

Vous pouvez créer un connecteur à l'aide de la console Google Cloud , de la Google Cloud CLI ou de Terraform.

Console

Accédez à la page de présentation de l'accès au VPC sans serveur.

Cliquez sur Créer un connecteur.

Dans le champ Nom, spécifiez un nom pour votre connecteur, en respectant les conventions d'attribution de noms de Compute Engine, auxquelles s'ajoutent ces exigences supplémentaires : le nom doit comporter moins de 21 caractères, et les tirets (-) comptent pour deux caractères.

Dans le champ Région, sélectionnez une région pour votre connecteur. Elle doit correspondre à la région de votre service sans serveur.

Si votre service ou job se trouve dans la région

us-centraloueurope-west, utilisezus-central1oueurope-west1.Dans le champ Réseau, sélectionnez le réseau VPC auquel associer le connecteur.

Dans le champ Sous-réseau, sélectionnez l'une des options suivantes :

Créer un connecteur à l'aide d'un sous-réseau existant : sélectionnez le sous-réseau existant dans le champ Sous-réseau.

Créer un connecteur et un sous-réseau : sélectionnez Plage d'adresses IP personnalisée dans le champ Sous-réseau. Saisissez ensuite la première adresse d'une plage CIDR

/28inutilisée (par exemple,10.8.0.0/28) à utiliser comme plage d'adresses IPv4 principale d'un nouveau sous-réseau, que Google Cloud va créer dans le réseau VPC du connecteur. Assurez-vous que la plage d'adresses IP n'entre pas en conflit avec des routes existantes dans le réseau VPC du connecteur. Le nom du nouveau sous-réseau commence par le préfixe "aet-".

(Facultatif) Pour définir les options de scaling afin de renforcer le contrôle du connecteur, cliquez sur Afficher les paramètres de scaling pour afficher le formulaire de scaling.

- Définissez le nombre minimal et maximal d'instances de votre connecteur ou utilisez les valeurs par défaut, qui sont 2 (min.) et 10 (max.). Le connecteur effectue un scaling à la hausse jusqu'à la valeur maximale spécifiée si l'utilisation du trafic l'exige, mais il ne réduit pas le nombre d'instances lorsque le trafic diminue. Les valeurs doivent être comprises entre

2et10. - Dans le menu Type d'instance, choisissez le type de machine à utiliser pour le connecteur ou utilisez la valeur par défaut

e2-micro. Notez la barre latérale des coûts sur la droite lorsque vous choisissez le type d'instance, qui affiche des estimations de bande passante et de coûts.

- Définissez le nombre minimal et maximal d'instances de votre connecteur ou utilisez les valeurs par défaut, qui sont 2 (min.) et 10 (max.). Le connecteur effectue un scaling à la hausse jusqu'à la valeur maximale spécifiée si l'utilisation du trafic l'exige, mais il ne réduit pas le nombre d'instances lorsque le trafic diminue. Les valeurs doivent être comprises entre

Cliquez sur Créer.

Une coche verte apparaît à côté du nom du connecteur lorsque celui-ci est prêt à être utilisé.

gcloud

-

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

Mettez à jour les composants

gcloudvers la dernière version :gcloud components update

Assurez-vous que l'API Serverless VPC Access est activée pour votre projet :

gcloud services enable vpcaccess.googleapis.com

Créez le connecteur à l'aide de l'une des options suivantes :

Pour plus d'informations et pour connaître les arguments facultatifs, consultez la documentation de référence sur

gcloud.Créez un connecteur à l'aide d'un sous-réseau existant :

gcloud compute networks vpc-access connectors create CONNECTOR_NAME \ --region REGION \ --subnet SUBNET_NAME \ --subnet-project HOST_PROJECT_ID \ --min-instances MIN \ --max-instances MAX \ --machine-type MACHINE_TYPE

Remplacez les éléments suivants :

CONNECTOR_NAME: nom de votre connecteur, qui respecte les conventions d'attribution de noms de Compute Engine, auxquelles s'ajoutent ces exigences supplémentaires : le nom doit comporter moins de 21 caractères, et les tirets (-) comptent pour deux caractères.REGION: région du connecteur, correspondant à la région de votre service ou job sans serveur. Si votre service ou votre job se trouve dans la régionus-centraloueurope-west, utilisezus-central1oueurope-west1.SUBNET_NAME: nom du sous-réseau existant.HOST_PROJECT_ID: ID du projet hôte de VPC partagé. Si le connecteur et le sous-réseau existant se trouvent dans le même projet, omettez le flag--subnet-project.MIN: nombre minimal d'instances à utiliser pour le connecteur. Saisissez un nombre entier compris entre2(valeur par défaut) et9.MAX: nombre maximal d'instances à utiliser pour le connecteur. Saisissez un nombre entier compris entre3et10(valeur par défaut). Si le connecteur effectue un scaling à la hausse jusqu'à atteindre le nombre maximal d'instances, il ne réduit pas ensuite le nombre d'instances lorsque le trafic diminue.MACHINE_TYPE: le type de machine doit être défini sur l'une des valeurs suivantes :f1-micro,e2-microoue2-standard-4.

Créer un connecteur et un sous-réseau :

gcloud compute networks vpc-access connectors create CONNECTOR_NAME \ --region REGION \ --network VPC_NETWORK \ --range IP_RANGE --min-instances MIN \ --max-instances MAX \ --machine-type MACHINE_TYPE

Remplacez les éléments suivants :

CONNECTOR_NAME: nom de votre connecteur, qui respecte les conventions d'attribution de noms de Compute Engine, auxquelles s'ajoutent ces exigences supplémentaires : le nom doit comporter moins de 21 caractères, et les tirets (-) comptent pour deux caractères.REGION: région du connecteur, correspondant à la région de votre service ou job sans serveur. Si votre service ou votre job se trouve dans la régionus-centraloueurope-west, utilisezus-central1oueurope-west1.VPC_NETWORK: nom du réseau VPC auquel associer le connecteur. Le connecteur et le réseau VPC doivent se trouver dans le même projet.IP_RANGE: indiquez une plage CIDR/28inutilisée (par exemple,10.8.0.0/28) à utiliser comme plage d'adresses IPv4 principale d'un nouveau sous-réseau, que Google Cloud va créer dans le réseau VPC du connecteur. Assurez-vous que la plage d'adresses IP n'entre pas en conflit avec des routes existantes dans le réseau VPC du connecteur. Le nom du nouveau sous-réseau commence par le préfixe "aet-".MIN: nombre minimal d'instances à utiliser pour le connecteur. Saisissez un nombre entier compris entre2(valeur par défaut) et9.MAX: nombre maximal d'instances à utiliser pour le connecteur. Saisissez un nombre entier compris entre3et10(valeur par défaut). Si le connecteur effectue un scaling à la hausse jusqu'à atteindre le nombre maximal d'instances, il ne réduit pas ensuite le nombre d'instances lorsque le trafic diminue.MACHINE_TYPE: le type de machine doit être défini sur l'une des valeurs suivantes :f1-micro,e2-microoue2-standard-4.

Avant d'utiliser le connecteur, vérifiez qu'il est dans l'état

READY:gcloud compute networks vpc-access connectors describe CONNECTOR_NAME \ --region REGION

Remplacez les éléments suivants :

CONNECTOR_NAME: nom du connecteur. Il s'agit du nom que vous avez spécifié à l'étape précédente.REGION: région du connecteur. Il s'agit de la région que vous avez spécifiée à l'étape précédente.

Le résultat doit contenir la ligne

state: READY.

Terraform

Vous pouvez utiliser une ressource Terraform pour activer l'API vpcaccess.googleapis.com.

Vous pouvez utiliser les modules Terraform pour créer un réseau et un sous-réseau VPC, puis créer le connecteur.

Configurer votre environnement sans serveur pour utiliser un connecteur

Après avoir créé un connecteur d'accès au VPC sans serveur, configurez votre environnement sans serveur pour qu'il utilise le connecteur en suivant les instructions de votre environnement sans serveur :

- Configurer Cloud Run

- Configurer Cloud Run Functions

- Configurer App Engine

Configurer Cloud Run pour utiliser un connecteur

Lorsque vous créez un service ou que vous déployez une nouvelle révision, vous pouvez configurer le service pour qu'il utilise un connecteur. Cela peut se faire via la console Google Cloud , Google Cloud CLI, un fichier YAML ou une ressource Terraform.

Console

Dans la console Google Cloud , accédez à Cloud Run :

Sélectionnez Services dans le menu, puis cliquez sur Déployer un conteneur pour configurer un nouveau service. Si vous configurez un service existant, cliquez sur celui-ci puis sur Modifier et déployer la nouvelle révision.

Si vous configurez un nouveau service, remplissez la page initiale des paramètres du service, puis cliquez sur Conteneur(s), volumes, mise en réseau et sécurité pour développer la page de configuration du service.

Cliquez sur l'onglet Connexions.

- Dans le champ Connecteur VPC, sélectionnez un connecteur à utiliser ou Aucun pour déconnecter votre service d'un réseau VPC.

Cliquez sur Créer ou Déployer.

gcloud

-

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

Pour spécifier un connecteur lors du déploiement, utilisez l'option

--vpc-connector:gcloud run deploy SERVICE --image IMAGE_URL --vpc-connector CONNECTOR_NAME

- Remplacez

SERVICEpar le nom du service. - Remplacez

IMAGE_URL. - Remplacez

CONNECTOR_NAMEpar le nom de votre connecteur. Si votre connecteur se trouve dans le projet hôte d'un VPC partagé, il doit s'agir du nom complet, par exemple :projects/HOST_PROJECT_ID/locations/CONNECTOR_REGION/connectors/CONNECTOR_NAME

Pour associer, mettre à jour ou supprimer un connecteur pour un service existant, utilisez la commande

gcloud run services updateavec l'une des options suivantes selon vos besoins :Par exemple, pour associer ou mettre à jour un connecteur :

gcloud run services update SERVICE --vpc-connector CONNECTOR_NAME

- Remplacez

SERVICEpar le nom du service. - Remplacez

CONNECTOR_NAMEpar le nom de votre connecteur.

- Remplacez

Si vous créez un service, ignorez cette étape. Si vous mettez à jour un service existant, téléchargez sa configuration YAML :

gcloud run services describe SERVICE --format export > service.yaml

Ajoutez ou mettez à jour l'attribut

run.googleapis.com/vpc-access-connectorsous l'attributannotationssous l'attribut de niveau supérieurspec:apiVersion: serving.knative.dev/v1 kind: Service metadata: name: SERVICE spec: template: metadata: annotations: run.googleapis.com/vpc-access-connector: CONNECTOR_NAME

- Remplacez

SERVICEpar le nom de votre service Cloud Run. - Remplacez

CONNECTOR_NAMEpar le nom de votre connecteur. Si votre connecteur se trouve dans le projet hôte d'un VPC partagé, il doit s'agir du nom complet, par exemple :projects/HOST_PROJECT_ID/locations/CONNECTOR_REGION/connectors/CONNECTOR_NAME

- Remplacez

Remplacez la configuration du service en utilisant la commande suivante :

gcloud beta run services replace service.yaml

YAML

Terraform

Vous pouvez utiliser une ressource Terraform pour créer un service et le configurer pour qu'il utilise votre connecteur.

Configurer Cloud Run Functions pour utiliser un connecteur

Vous pouvez configurer une fonction pour qu'elle utilise un connecteur depuis la console Google Cloud ou la Google Cloud CLI :

Console

Accédez à la page de présentation de Cloud Run Functions dans la consoleGoogle Cloud :

Cliquez sur Créer une fonction. Vous pouvez également cliquer sur une fonction existante pour accéder à sa page d'informations, puis sur Modifier.

Développez les paramètres avancés en cliquant sur Paramètres d'exécution, de compilation et de connexion.

Dans l'onglet Connexions, sous "Paramètres de sortie", saisissez le nom de votre connecteur dans le champ Connecteur VPC.

gcloud

-

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

Exécutez la commande

gcloud functions deploypour déployer la fonction et spécifiez l'indicateur--vpc-connector:gcloud functions deploy FUNCTION_NAME \ --vpc-connector CONNECTOR_NAME \ FLAGS...

où :

FUNCTION_NAMEest le nom de la fonction.CONNECTOR_NAMEest le nom du connecteur. Si votre connecteur se trouve dans le projet hôte d'un VPC partagé, il doit s'agir du nom complet, par exemple :projects/HOST_PROJECT_ID/locations/CONNECTOR_REGION/connectors/CONNECTOR_NAME

FLAGS...fait référence aux autres options que vous transmettez lors du déploiement de la fonction.

Pour apprendre à contrôler plus précisément les requêtes acheminées via le connecteur, consultez la section Paramètres de sortie.

Configurer App Engine pour utiliser un connecteur

Python 2

Arrêtez l'utilisation du service de récupération d'URL App Engine.

Par défaut, toutes les requêtes sont acheminées via le service de récupération d'URL. Cela entraîne l'échec des requêtes adressées à votre réseau VPC. Pour désactiver ce paramètre par défaut, consultez la section Désactiver le service de récupération d'URL pour la gestion de toutes les requêtes sortantes.

Vous pouvez toujours utiliser la bibliothèque

urlfetchdirectement pour des requêtes individuelles si nécessaire, mais cela n'est pas recommandé.Ajoutez le champ "Accès au VPC sans serveur" au fichier

app.yaml:vpc_access_connector: name: projects/PROJECT_ID/locations/REGION/connectors/CONNECTOR_NAME

Remplacez les éléments suivants :

PROJECT_IDpar l'ID de votre projet Google Cloud . Si votre connecteur se trouve dans le projet hôte d'un VPC partagé, il doit s'agir de l'ID du projet hôte.REGIONpar la région où se trouve le connecteur.CONNECTOR_NAMEpar le nom de votre connecteur.

Déployez le service :

gcloud app deploy

Une fois votre service déployé, il peut envoyer des requêtes aux adresses IP internes afin d'accéder aux ressources de votre réseau VPC.

Java 8

Arrêtez l'utilisation du service de récupération d'URL App Engine

URLFetchService.Ajoutez l'élément "Accès au VPC sans serveur" au fichier

appengine-web.xmlde votre service :<vpc-access-connector> <name>projects/PROJECT_ID/locations/REGION/connectors/CONNECTOR_NAME</name> </vpc-access-connector>

Remplacez les éléments suivants :

PROJECT_IDpar l'ID de votre projet Google Cloud . Si votre connecteur se trouve dans le projet hôte d'un VPC partagé, il doit s'agir de l'ID du projet hôte.REGIONpar la région où se trouve le connecteur.CONNECTOR_NAMEpar le nom de votre connecteur.

Déployez le service :

gcloud app deploy WEB-INF/appengine-web.xml

Une fois votre service déployé, il peut envoyer des requêtes aux adresses IP internes afin d'accéder aux ressources de votre réseau VPC.

Go 1.11

Arrêtez l'utilisation du service de récupération d'URL App Engine.

L'accès au VPC sans serveur n'est pas compatible avec le service de récupération d'URL. Les requêtes effectuées à l'aide de ce service ignorent les paramètres d'accès au VPC sans serveur. Établissez des connexions sortantes avec des sockets.

Ajoutez le champ "Accès au VPC sans serveur" au fichier

app.yaml:vpc_access_connector: name: projects/PROJECT_ID/locations/REGION/connectors/CONNECTOR_NAME

Remplacez les éléments suivants :

PROJECT_IDpar l'ID de votre projet Google Cloud .REGIONpar la région où se trouve le connecteurCONNECTOR_NAMEpar le nom de votre connecteur

Déployez le service :

gcloud app deploy

Une fois votre service déployé, il peut envoyer des requêtes aux adresses IP internes afin d'accéder aux ressources de votre réseau VPC.

Tous les autres environnements d'exécution

Ajoutez le champ "Accès au VPC sans serveur" au fichier

app.yaml:vpc_access_connector: name: projects/PROJECT_ID/locations/REGION/connectors/CONNECTOR_NAME

Remplacez les éléments suivants :

PROJECT_IDpar l'ID de votre projet Google Cloud . Si votre connecteur se trouve dans le projet hôte d'un VPC partagé, il doit s'agir de l'ID du projet hôte.REGIONpar la région où se trouve le connecteur.CONNECTOR_NAMEpar le nom de votre connecteur.

Déployez le service :

gcloud app deploy

Une fois votre service déployé, il peut envoyer des requêtes aux adresses IP internes afin d'accéder aux ressources de votre réseau VPC.

Configurer des règles de pare-feu pour les connecteurs

Règles de pare-feu requises pour les connecteurs dans les projets de service

Si vous créez un connecteur dans un réseau VPC autonome ou dans le projet hôte d'un réseau VPC partagé, Google Cloud crée toutes les règles de pare-feu nécessaires au fonctionnement du connecteur. Pour en savoir plus, consultez la section Règles de pare-feu pour les connecteurs dans les réseaux VPC autonomes ou les projets hôtes de VPC partagés.

Toutefois, si vous créez un connecteur dans un projet de service et qu'il cible un réseau VPC partagé dans le projet hôte, vous devez ajouter des règles de pare-feu afin d'autoriser le trafic nécessaire au fonctionnement du connecteur provenant des plages d'adresses suivantes :

- Plage d'adresses IP de l'infrastructure sans serveur :

35.199.224.0/19 - Plages d'adresses IP de vérification d'état :

35.191.0.0/16,35.191.192.0/18et130.211.0.0/22

Ces plages sont utilisées par l'infrastructure Google sous-jacente à Cloud Run, Cloud Run Functions et l'environnement standard App Engine. Toutes les requêtes provenant de ces adresses IP sont émises par l'infrastructure Google pour s'assurer que chaque ressource sans serveur ne communique qu'avec le connecteur auquel elle est connectée.

Vous devez également autoriser le trafic du sous-réseau du connecteur vers les ressources de votre réseau VPC.

Pour effectuer ces étapes, vous devez disposer de l'un des rôles suivants sur le projet hôte :

- Rôle Propriétaire (

roles/owner) - Rôle Administrateur de sécurité de Compute (

roles/compute.securityAdmin) - Rôle personnalisé Identity and Access Management (IAM) avec l'autorisation

compute.firewalls.createactivée

Pour une configuration de base, appliquez les règles pour autoriser les ressources sans serveur dans tout projet de service connecté au réseau VPC partagé à envoyer des requêtes à n'importe quelle ressource du réseau.

Pour appliquer ces règles, exécutez les commandes suivantes dans le projet hôte :

Créez des règles de pare-feu permettant aux requêtes de l'infrastructure sans serveur de Google et aux vérifications d'état d'atteindre tous les connecteurs du réseau. Dans ces commandes, les ports UDP et TCP sont utilisés respectivement en tant que proxys et pour les vérifications d'état HTTP. Ne modifiez pas les ports spécifiés.

gcloud compute firewall-rules create serverless-to-vpc-connector \ --allow tcp:667,udp:665-666,icmp \ --source-ranges=35.199.224.0/19 \ --direction=INGRESS \ --target-tags vpc-connector \ --network=VPC_NETWORK

gcloud compute firewall-rules create vpc-connector-to-serverless \ --allow tcp:667,udp:665-666,icmp \ --destination-ranges=35.199.224.0/19 \ --direction=EGRESS \ --target-tags vpc-connector \ --network=VPC_NETWORK

gcloud compute firewall-rules create vpc-connector-health-checks \ --allow tcp:667 \ --source-ranges=35.191.0.0/16,35.191.192.0/18,130.211.0.0/22 \ --direction=INGRESS \ --target-tags vpc-connector \ --network=VPC_NETWORK

Remplacez

VPC_NETWORKpar le nom du réseau VPC auquel associer le connecteur.Créez une règle de pare-feu d'entrée sur votre réseau VPC pour autoriser les requêtes provenant de connecteurs qui ciblent ce réseau :

gcloud compute firewall-rules create vpc-connector-requests \ --allow tcp,udp,icmp \ --direction=INGRESS \ --source-tags vpc-connector \ --network=VPC_NETWORK

Cette règle permet au connecteur d'accéder à chaque ressource du réseau. Pour limiter les ressources auxquelles votre environnement sans serveur peut accéder à l'aide de l'accès au VPC sans serveur, consultez la page Limiter l'accès des VM du connecteur aux ressources de réseau VPC.

Créer des règles de pare-feu pour des connecteurs spécifiques

La procédure décrite à la section Règles de pare-feu requises pour les connecteurs dans les projets de service permet de créer des règles de pare-feu qui s'appliquent à tous les connecteurs actuels et créés ultérieurement. Si vous ne souhaitez pas utiliser cette fonctionnalité, mais que vous préférez créer des règles pour des connecteurs spécifiques, vous pouvez définir des règles de sorte qu'elles ne s'appliquent qu'à ces connecteurs.

Pour limiter le champ d'application des règles à des connecteurs spécifiques, vous pouvez utiliser l'un des mécanismes suivants :

- Tags réseau : chaque connecteur dispose de deux tags réseau,

vpc-connectoretvpc-connector-REGION-CONNECTOR_NAME. Utilisez ce dernier format pour limiter le champ d'application de vos règles de pare-feu à un connecteur spécifique. - Plages d'adresses IP : utilisez cette option uniquement pour les règles de sortie, car elle ne fonctionne pas pour les règles d'entrée. Vous pouvez utiliser la plage d'adresses IP du sous-réseau du connecteur pour limiter le champ d'application de vos règles de pare-feu à un seul connecteur VPC.

Limiter l'accès des VM du connecteur aux ressources de réseau VPC

Vous pouvez limiter l'accès du connecteur aux ressources de son réseau VPC cible à l'aide de règles de pare-feu VPC ou de règles de stratégies de pare-feu. Vous pouvez respecter ces restrictions en utilisant l'une des stratégies suivantes :

- Créez des règles d'entrée où les cibles représentent les ressources pour lesquelles vous souhaitez limiter l'accès des VM du connecteur et où les sources représentent les VM du connecteur.

- Créez des règles de sortie où les cibles représentent les VM du connecteur et où les destinations représentent les ressources auxquelles vous souhaitez leur limiter l'accès.

Les exemples suivants illustrent chaque stratégie.

Restreindre l'accès à l'aide de règles d'entrée

Choisissez des tags réseau ou des plages CIDR pour contrôler le trafic entrant vers votre réseau VPC.

Tags réseau

Les étapes suivantes expliquent comment créer des règles d'entrée limitant l'accès d'un connecteur à votre réseau VPC en fonction des tags réseau du connecteur.

Vérifiez que vous disposez des autorisations requises pour insérer des règles de pare-feu. Vous devez disposer de l'un des rôles Identity and Access Management (IAM) suivants :

- Rôle Administrateur de sécurité de Compute

- Rôle IAM personnalisé avec l'autorisation

compute.firewalls.createactivée

Refusez le trafic du connecteur sur votre réseau VPC.

Créez une règle de pare-feu d'entrée ayant une priorité inférieure à 1 000 sur votre réseau VPC pour refuser l'entrée en provenance du tag réseau du connecteur. Cette option remplace la règle de pare-feu implicite créée par défaut par l'accès au VPC sans serveur sur votre réseau VPC.

gcloud compute firewall-rules create RULE_NAME \ --action=DENY \ --rules=PROTOCOL \ --source-tags=VPC_CONNECTOR_NETWORK_TAG \ --direction=INGRESS \ --network=VPC_NETWORK \ --priority=PRIORITY

Remplacez les éléments suivants :

RULE_NAME : nom de votre nouvelle règle de pare-feu. Exemple :

deny-vpc-connector.PROTOCOL : un ou plusieurs protocoles que vous souhaitez autoriser à partir de votre connecteur VPC. Les protocoles acceptés sont

tcpouudp. Par exemple,tcp:80,udpautorise le trafic TCP via le port 80 et le trafic UDP. Pour en savoir plus, consultez la documentation sur le flagallow.Pour des raisons de sécurité et de validation, vous pouvez également configurer des règles de refus pour bloquer le trafic correspondant aux protocoles non compatibles suivants :

ah,all,esp,icmp,ipipetsctp.VPC_CONNECTOR_NETWORK_TAG : tag réseau de connecteur universel si vous souhaitez limiter l'accès de tous les connecteurs (y compris ceux créés ultérieurement), ou tag réseau unique si vous souhaitez limiter l'accès d'un connecteur spécifique.

- Tag réseau universel :

vpc-connector Tag réseau unique :

vpc-connector-REGION-CONNECTOR_NAMERemplacez :

- REGION : région du connecteur que vous souhaitez restreindre

- CONNECTOR_NAME : nom du connecteur que vous souhaitez restreindre

Pour en savoir plus sur les tags réseau de connecteur, consultez Tags réseau.

- Tag réseau universel :

VPC_NETWORK : nom de votre réseau VPC

PRIORITY : entier compris entre 0 et 65 535. Par exemple, 0 définit la priorité la plus élevée.

Autorisez le trafic de connecteur vers la ressource qui doit recevoir le trafic du connecteur.

Utilisez les flags

allowettarget-tagspour créer une règle de pare-feu d'entrée ciblant la ressource de votre réseau VPC à laquelle vous souhaitez que le connecteur VPC accède. Définissez la priorité de cette règle sur une valeur inférieure à celle de la règle que vous avez définie à l'étape précédente.gcloud compute firewall-rules create RULE_NAME \ --allow=PROTOCOL \ --source-tags=VPC_CONNECTOR_NETWORK_TAG \ --direction=INGRESS \ --network=VPC_NETWORK \ --target-tags=RESOURCE_TAG \ --priority=PRIORITY

Remplacez les éléments suivants :

RULE_NAME : nom de votre nouvelle règle de pare-feu. Exemple :

allow-vpc-connector-for-select-resources.PROTOCOL : un ou plusieurs protocoles que vous souhaitez autoriser à partir de votre connecteur VPC. Les protocoles acceptés sont

tcpouudp. Par exemple,tcp:80,udpautorise le trafic TCP via le port 80 et le trafic UDP. Pour en savoir plus, consultez la documentation sur le flagallow.VPC_CONNECTOR_NETWORK_TAG : tag réseau de connecteur universel si vous souhaitez limiter l'accès de tous les connecteurs (y compris ceux créés ultérieurement), ou tag réseau unique si vous souhaitez limiter l'accès d'un connecteur spécifique. Il doit correspondre au tag réseau que vous avez spécifié à l'étape précédente.

- Tag réseau universel :

vpc-connector Tag réseau unique :

vpc-connector-REGION-CONNECTOR_NAMERemplacez :

- REGION : région du connecteur que vous souhaitez restreindre

- CONNECTOR_NAME : nom du connecteur que vous souhaitez restreindre

Pour en savoir plus sur les tags réseau de connecteur, consultez Tags réseau.

- Tag réseau universel :

VPC_NETWORK : nom de votre réseau VPC

RESOURCE_TAG : tag réseau de la ressource VPC à laquelle votre connecteur VPC doit accéder

PRIORITY : entier inférieur à la priorité définie à l'étape précédente. Par exemple, si vous définissez la priorité de la règle que vous avez créée à l'étape précédente sur 990, essayez 980.

Pour en savoir plus sur les flags obligatoires et facultatifs pour la création de règles de pare-feu, consultez la documentation sur gcloud compute firewall-rules create.

Plage CIDR

Les étapes suivantes montrent comment créer des règles d'entrée qui limitent l'accès d'un connecteur à votre réseau VPC en fonction de la plage CIDR du connecteur.

Vérifiez que vous disposez des autorisations requises pour insérer des règles de pare-feu. Vous devez disposer de l'un des rôles Identity and Access Management (IAM) suivants :

- Rôle Administrateur de sécurité de Compute

- Rôle IAM personnalisé avec l'autorisation

compute.firewalls.createactivée

Refusez le trafic du connecteur sur votre réseau VPC.

Créez une règle de pare-feu d'entrée ayant une priorité inférieure à 1 000 sur votre réseau VPC pour refuser l'entrée en provenance de la plage CIDR du connecteur. Cette option remplace la règle de pare-feu implicite créée par défaut par l'accès au VPC sans serveur sur votre réseau VPC.

gcloud compute firewall-rules create RULE_NAME \ --action=DENY \ --rules=PROTOCOL \ --source-ranges=VPC_CONNECTOR_CIDR_RANGE \ --direction=INGRESS \ --network=VPC_NETWORK \ --priority=PRIORITY

Remplacez les éléments suivants :

RULE_NAME : nom de votre nouvelle règle de pare-feu. Exemple :

deny-vpc-connector.PROTOCOL : un ou plusieurs protocoles que vous souhaitez autoriser à partir de votre connecteur VPC. Les protocoles acceptés sont

tcpouudp. Par exemple,tcp:80,udpautorise le trafic TCP via le port 80 et le trafic UDP. Pour en savoir plus, consultez la documentation sur le flagallow.Pour des raisons de sécurité et de validation, vous pouvez également configurer des règles de refus pour bloquer le trafic correspondant aux protocoles non compatibles suivants :

ah,all,esp,icmp,ipipetsctp.VPC_CONNECTOR_CIDR_RANGE : plage CIDR du connecteur dont vous limitez l'accès

VPC_NETWORK : nom de votre réseau VPC

PRIORITY : entier compris entre 0 et 65 535. Par exemple, 0 définit la priorité la plus élevée.

Autorisez le trafic de connecteur vers la ressource qui doit recevoir le trafic du connecteur.

Utilisez les flags

allowettarget-tagspour créer une règle de pare-feu d'entrée ciblant la ressource de votre réseau VPC à laquelle vous souhaitez que le connecteur VPC accède. Définissez la priorité de cette règle sur une valeur inférieure à celle de la règle que vous avez définie à l'étape précédente.gcloud compute firewall-rules create RULE_NAME \ --allow=PROTOCOL \ --source-ranges=VPC_CONNECTOR_CIDR_RANGE \ --direction=INGRESS \ --network=VPC_NETWORK \ --target-tags=RESOURCE_TAG \ --priority=PRIORITY

Remplacez les éléments suivants :

RULE_NAME : nom de votre nouvelle règle de pare-feu. Exemple :

allow-vpc-connector-for-select-resources.PROTOCOL : un ou plusieurs protocoles que vous souhaitez autoriser à partir de votre connecteur VPC. Les protocoles acceptés sont

tcpouudp. Par exemple,tcp:80,udpautorise le trafic TCP via le port 80 et le trafic UDP. Pour en savoir plus, consultez la documentation sur le flagallow.VPC_CONNECTOR_CIDR_RANGE : plage CIDR du connecteur dont vous limitez l'accès

VPC_NETWORK : nom de votre réseau VPC

RESOURCE_TAG : tag réseau de la ressource VPC à laquelle votre connecteur VPC doit accéder

PRIORITY : entier inférieur à la priorité définie à l'étape précédente. Par exemple, si vous définissez la priorité de la règle que vous avez créée à l'étape précédente sur 990, essayez 980.

Pour en savoir plus sur les flags obligatoires et facultatifs pour la création de règles de pare-feu, consultez la documentation sur gcloud compute firewall-rules create.

Limiter l'accès à l'aide de règles de sortie

Les étapes suivantes expliquent comment créer des règles de sortie afin de limiter l'accès du connecteur.

Vérifiez que vous disposez des autorisations requises pour insérer des règles de pare-feu. Vous devez disposer de l'un des rôles Identity and Access Management (IAM) suivants :

- Rôle Administrateur de sécurité de Compute

- Rôle IAM personnalisé avec l'autorisation

compute.firewalls.createactivée

Refusez le trafic sortant de votre connecteur.

Créez une règle de pare-feu de sortie sur votre connecteur d'accès au VPC sans serveur pour l'empêcher d'envoyer du trafic sortant, à l'exception des réponses établies, vers n'importe quelle destination.

gcloud compute firewall-rules create RULE_NAME \ --action=DENY \ --rules=PROTOCOL \ --direction=EGRESS \ --target-tags=VPC_CONNECTOR_NETWORK_TAG \ --network=VPC_NETWORK \ --priority=PRIORITY

Remplacez les éléments suivants :

RULE_NAME : nom de votre nouvelle règle de pare-feu. Exemple :

deny-vpc-connector.PROTOCOL : un ou plusieurs protocoles que vous souhaitez autoriser à partir de votre connecteur VPC. Les protocoles acceptés sont

tcpouudp. Par exemple,tcp:80,udpautorise le trafic TCP via le port 80 et le trafic UDP. Pour en savoir plus, consultez la documentation sur le flagallow.Pour des raisons de sécurité et de validation, vous pouvez également configurer des règles de refus pour bloquer le trafic correspondant aux protocoles non compatibles suivants :

ah,all,esp,icmp,ipipetsctp.VPC_CONNECTOR_NETWORK_TAG : tag réseau universel du connecteur VPC si vous souhaitez que la règle s'applique à tous les connecteurs VPC existants et à tous les connecteurs VPC créés ultérieurement. Ou tag réseau unique du connecteur VPC si vous souhaitez contrôler un connecteur spécifique.

VPC_NETWORK : nom de votre réseau VPC

PRIORITY : entier compris entre 0 et 65 535. Par exemple, 0 définit la priorité la plus élevée.

Autorisez le trafic sortant lorsque la destination se trouve dans la plage CIDR à laquelle vous souhaitez que votre connecteur accède.

Utilisez les flags

allowetdestination-rangespour créer une règle de pare-feu autorisant le trafic sortant de votre connecteur pour une plage de destination spécifique. Définissez la plage de destination sur la plage CIDR de la ressource de votre réseau VPC à laquelle vous souhaitez que le connecteur accède. Définissez la priorité de cette règle sur une valeur inférieure à celle de la règle que vous avez configurée à l'étape précédente.gcloud compute firewall-rules create RULE_NAME \ --allow=PROTOCOL \ --destination-ranges=RESOURCE_CIDR_RANGE \ --direction=EGRESS \ --network=VPC_NETWORK \ --target-tags=VPC_CONNECTOR_NETWORK_TAG \ --priority=PRIORITY

Remplacez les éléments suivants :

RULE_NAME : nom de votre nouvelle règle de pare-feu. Exemple :

allow-vpc-connector-for-select-resources.PROTOCOL : un ou plusieurs protocoles que vous souhaitez autoriser à partir de votre connecteur VPC. Les protocoles acceptés sont

tcpouudp. Par exemple,tcp:80,udpautorise le trafic TCP via le port 80 et le trafic UDP. Pour en savoir plus, consultez la documentation sur le flagallow.RESOURCE_CIDR_RANGE : plage CIDR du connecteur dont vous limitez l'accès

VPC_NETWORK : nom de votre réseau VPC

VPC_CONNECTOR_NETWORK_TAG : tag réseau universel du connecteur VPC si vous souhaitez que la règle s'applique à tous les connecteurs VPC existants et à tous les connecteurs VPC créés ultérieurement. Ou tag réseau unique du connecteur VPC si vous souhaitez contrôler un connecteur spécifique. Si vous avez utilisé le tag réseau unique à l'étape précédente, utilisez-le.

PRIORITY : entier inférieur à la priorité définie à l'étape précédente. Par exemple, si vous définissez la priorité de la règle que vous avez créée à l'étape précédente sur 990, essayez 980.

Pour plus d'informations sur les options obligatoires et facultatives de création de règles de pare-feu, reportez-vous à la documentation de gcloud compute firewall-rules create.

Mettre à jour un connecteur

Vous pouvez mettre à jour et surveiller les attributs suivants de votre connecteur à l'aide de la console Google Cloud , de la Google Cloud CLI ou de l'API :

- Type de machine (instance)

- Nombre minimal et maximal d'instances

- Débit récent, nombre d'instances et utilisation du processeur

Mettre à jour le type de machine

Console

Accédez à la page de présentation de l'accès au VPC sans serveur.

Sélectionnez le connecteur que vous souhaitez modifier, puis cliquez sur Modifier.

Dans la liste Type d'instance, sélectionnez le type de machine (instance) de votre choix. Pour en savoir plus sur les types de machines disponibles, consultez la documentation Débit et scaling.

gcloud

-

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

Pour mettre à jour le type de machine du connecteur, exécutez la commande suivante dans votre terminal :

gcloud beta compute networks vpc-access connectors update CONNECTOR_NAME --region=REGION --machine-type=MACHINE_TYPE

CONNECTOR_NAME: nom de votre connecteurREGION: nom de la région du connecteurMACHINE_TYPE: type de machine de votre choix Pour en savoir plus sur les types de machines disponibles, consultez la documentation Débit et scaling.

Réduire le nombre minimal et maximal d'instances

Pour réduire le nombre minimal et maximal d'instances, vous devez procéder comme suit :

- Créez un connecteur avec les valeurs de votre choix.

- Mettez à jour votre service ou votre fonction pour utiliser le nouveau connecteur.

- Supprimez l'ancien connecteur une fois que vous avez déplacé son trafic.

Augmenter le nombre minimal et maximal d'instances

Console

Accédez à la page de présentation de l'accès au VPC sans serveur.

Sélectionnez le connecteur que vous souhaitez modifier, puis cliquez sur Modifier.

Dans le champ Nombre minimal d'instances, sélectionnez le nombre minimal d'instances de votre choix.

La plus petite valeur possible de ce champ est la valeur actuelle. La plus grande valeur possible pour ce champ est la valeur actuelle figurant dans le champ Nombre maximal d'instances moins 1. Par exemple, si la valeur du champ Nombre maximal d'instances est 8, la valeur la plus élevée possible pour le champ Nombre minimal d'instances est 7.

Dans le champ Nombre maximal d'instances, sélectionnez le nombre maximal d'instances souhaité.

La plus petite valeur possible de ce champ est la valeur actuelle. La plus grande valeur possible pour ce champ est 10.

gcloud

-

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

Pour augmenter le nombre minimal ou maximal d'instances du connecteur, exécutez la commande suivante dans votre terminal :

gcloud beta compute networks vpc-access connectors update CONNECTOR_NAME --region=REGION --min-instances=MIN_INSTANCES --max-instances=MAX_INSTANCES

CONNECTOR_NAME: nom de votre connecteurREGION: nom de la région du connecteurMIN_INSTANCES: nombre minimal d'instances souhaité.- La plus petite valeur possible pour ce champ est la valeur actuelle de

min_instances. Pour trouver la valeur actuelle, consultez la section Rechercher les valeurs d'attribut actuelles. - La plus grande valeur possible pour ce champ est la valeur actuelle de

max_instancesmoins 1, carmin_instancesdoit être inférieur àmax_instances. Par exemple, simax_instancesest défini sur 8, la valeur la plus élevée possible pour ce champ est 7. Si votre connecteur utilise la valeurmax-instancespar défaut de 10, la plus grande valeur possible de ce champ est 9. Pour trouver la valeur demax-instances, consultez Rechercher les valeurs d'attributs actuelles.

- La plus petite valeur possible pour ce champ est la valeur actuelle de

MAX_INSTANCES:- La plus petite valeur possible pour ce champ est la valeur actuelle de

max_instances. Pour trouver la valeur actuelle, consultez Rechercher les valeurs d'attribut actuelles. - La plus grande valeur possible pour ce champ est 10.

Si vous souhaitez augmenter le nombre minimal d'instances, mais pas le nombre maximal, vous devez quand même spécifier le nombre maximal d'instances. Inversement, si vous souhaitez modifier le nombre maximal d'instances, mais pas le nombre minimal, vous devez quand même spécifier le nombre minimal d'instances. Pour conserver la valeur actuelle définie pour le nombre minimal ou maximal d'instances, vous devez la spécifier. Pour trouver la valeur actuelle, consultez Rechercher les valeurs d'attribut actuelles.

- La plus petite valeur possible pour ce champ est la valeur actuelle de

Rechercher les valeurs d'attribut actuelles

Pour trouver les valeurs d'attribut actuelles de votre connecteur, exécutez la commande suivante dans votre terminal :

gcloud compute networks vpc-access connectors describe CONNECTOR_NAME --region=REGION --project=PROJECT

CONNECTOR_NAME: nom de votre connecteurREGION: nom de la région du connecteurPROJECT: nom de votre projet Google Cloud

Surveiller l'utilisation des connecteurs

Surveiller l'utilisation au fil du temps peut vous aider à déterminer quand ajuster les paramètres d'un connecteur. Par exemple, si l'utilisation du processeur connaît un pic, vous pouvez essayer d'augmenter le nombre maximal d'instances pour obtenir de meilleurs résultats. Si vous atteignez le débit maximal, vous pouvez également décider de passer à un type de machine de capacité supérieure.

Pour afficher des graphiques concernant le débit du connecteur, le nombre d'instances et les métriques d'utilisation du processeur au fil du temps à l'aide de la console Google Cloud , procédez comme suit :

Accédez à la page de présentation de l'accès au VPC sans serveur.

Cliquez sur le nom du connecteur que vous souhaitez surveiller.

Sélectionnez le nombre de jours à afficher, compris entre 1 et 90 jours.

Dans le graphique Débit, pointez sur le graphique pour afficher le débit récent du connecteur.

Dans le graphique Nombre d'instances, pointez sur le graphique pour afficher le nombre d'instances récemment utilisées par le connecteur.

Dans le graphique Utilisation du processeur, pointez sur le graphique pour afficher l'utilisation récente du processeur par le connecteur. Le graphique affiche l'utilisation du processeur répartie sur les instances pour les 50e, 95e et 99e centiles.

Supprimer un connecteur

Avant de supprimer un connecteur, vous devez le retirer de toutes les ressources sans serveur qui l'utilisent encore. Si vous supprimez un connecteur avant de le retirer de vos ressources sans serveur, vous ne pourrez pas supprimer le réseau VPC ultérieurement.

Pour les utilisateurs de VPC partagé qui configurent des connecteurs dans le projet hôte de VPC partagé, vous pouvez exécuter la commande gcloud compute networks vpc-access connectors describe pour lister les projets dans lesquels des ressources sans serveur utilisent un connecteur donné.

Pour supprimer un connecteur, utilisez la console Google Cloud ou la Google Cloud CLI :

Console

Accédez à la page de présentation de l'accès au VPC sans serveur dans la consoleGoogle Cloud :

Sélectionnez le connecteur que vous souhaitez supprimer.

Cliquez sur Supprimer.

gcloud

-

In the Google Cloud console, activate Cloud Shell.

At the bottom of the Google Cloud console, a Cloud Shell session starts and displays a command-line prompt. Cloud Shell is a shell environment with the Google Cloud CLI already installed and with values already set for your current project. It can take a few seconds for the session to initialize.

Utilisez la commande

gcloudsuivante pour supprimer un connecteur :gcloud compute networks vpc-access connectors delete CONNECTOR_NAME --region=REGION

Remplacez les éléments suivants :

- CONNECTOR_NAME par le nom du connecteur que vous souhaitez supprimer

- REGION par la région où se trouve le connecteur

Gérer les contraintes personnalisées pour les projets

Cette section explique comment créer des contraintes personnalisées pour les connecteurs d'accès au VPC sans serveur et comment les appliquer au niveau du projet. Pour en savoir plus sur les règles d'administration personnalisées, consultez Créer et gérer des règles d'administration personnalisées.

Les règles d'administrationGoogle Cloud vous offrent un contrôle centralisé et automatisé sur les ressources de votre organisation. En tant qu'administrateur des règles d'administration, vous pouvez définir des ensembles de restrictions appelées contraintes qui s'appliquent aux ressourcesGoogle Cloud et à leurs descendants dans la hiérarchie des ressourcesGoogle Cloud . Chaque ensemble de restrictions constitue une règle d'administration. Vous pouvez appliquer des règles d'administration au niveau d'une organisation, d'un dossier ou d'un projet.

Les règles d'administration offrent des contraintes prédéfinies pour divers servicesGoogle Cloud . Toutefois, si vous souhaitez exercer un contrôle plus précis et personnalisable sur les champs spécifiques qui sont restreints par vos règles d'administration, vous pouvez également créer des règles d'administration personnalisées.

Avantages

L'accès au VPC sans serveur vous permet d'écrire un nombre illimité de contraintes personnalisées à l'aide de la plupart des champs configurés par l'utilisateur dans l'API Accès au VPC sans serveur. Par exemple, vous pouvez créer une contrainte personnalisée spécifiant les sous-réseaux qu'un connecteur d'accès au VPC sans serveur peut utiliser.

Une fois appliquées, les requêtes qui ne respectent pas une règle imposant une contrainte personnalisée affichent un message d'erreur dans gcloud CLI et dans les journaux d'accès au VPC sans serveur. Le message d'erreur contient l'ID de la contrainte et la description de la contrainte personnalisée non respectée.

Héritage des règles

Par défaut, les règles d'administration sont héritées par les descendants des ressources sur lesquelles vous les appliquez. Par exemple, si vous appliquez une règle au niveau d'un dossier, Google Cloud l'applique à tous les projets du dossier. Pour mieux comprendre ce comportement et savoir comment le modifier, consultez Règles d'évaluation hiérarchique.

Limites

Il n'est pas possible de spécifier le type de machine, le nombre minimal d'instances ni le nombre maximal d'instances.

Avant de commencer

Assurez-vous de connaître votre ID d'organisation.

Rôles requis

Pour obtenir les autorisations nécessaires pour gérer des règles d'administration#39;administration, demandez à votre administrateur de vous accorder le rôle IAM Administrateur des règles d'administration (roles/orgpolicy.policyAdmin) dans la ressource d'organisation.

Pour en savoir plus sur l'attribution de rôles, consultez la page Gérer l'accès aux projets, aux dossiers et aux organisations.

Vous pouvez également obtenir les autorisations requises avec des rôles personnalisés ou d'autres rôles prédéfinis.

Créer une contrainte personnalisée

Une contrainte personnalisée est définie dans un fichier YAML, qui spécifie les ressources, méthodes, conditions et actions compatibles avec le service auquel vous appliquez la règle d'administration. Les conditions de vos contraintes personnalisées sont définies à l'aide du langage CEL (Common Expression Language). Pour en savoir plus sur la création de conditions dans des contraintes personnalisées à l'aide du CEL, consultez la section CEL de la page Créer et gérer des contraintes personnalisées.

Pour créer un fichier YAML pour une contrainte personnalisée d'accès au VPC sans serveur, reportez-vous à l'exemple suivant :

name: organizations/ORGANIZATION_ID/customConstraints/CONSTRAINT_NAME

resourceTypes:

- vpcaccess.googleapis.com/Connector

methodTypes:

- CREATE

condition: "CONDITION"

actionType: ACTION

displayName: DISPLAY_NAME

description: DESCRIPTION

Remplacez les éléments suivants :

ORGANIZATION_ID: ID de votre organisation (par exemple,123456789).CONSTRAINT_NAME: nom souhaité pour votre nouvelle contrainte personnalisée. Une contrainte personnalisée doit commencer parcustom.et ne peut inclure que des lettres majuscules, minuscules ou des chiffres (par exemple, custom.defaultNetworkConstraint). La longueur maximale de ce champ est de 70 caractères, sans compter le préfixe.CONDITION: condition CEL écrite pour une représentation d'une ressource de service acceptée. Ce champ ne doit pas comporter plus de 1 000 caractères. Exemple :"resource.network == default".ACTION: action à effectuer si laconditionest remplie. Peut être défini surALLOWouDENY.DISPLAY_NAME: nom convivial de la contrainte. Ce champ ne doit pas comporter plus de 200 caractères.DESCRIPTION: description conviviale de la contrainte, qui sera affichée dans un message d'erreur en cas de non-respect de la règle (par exemple,"Require network to not be set to default."). Ce champ ne doit pas comporter plus de 2 000 caractères.

Pour en savoir plus sur la création d'une contrainte personnalisée, consultez Définir des contraintes personnalisées.

Configurer une contrainte personnalisée

Après avoir créé le fichier YAML pour une nouvelle contrainte personnalisée, vous devez le configurer de sorte qu'il soit disponible pour les règles d'administration de votre organisation. Pour configurer une contrainte personnalisée, utilisez la commandegcloud org-policies set-custom-constraint :

gcloud org-policies set-custom-constraint CONSTRAINT_PATH

CONSTRAINT_PATH par le chemin d'accès complet à votre fichier de contrainte personnalisée. Exemple : /home/user/customconstraint.yaml.

Une fois l'opération terminée, vos contraintes personnalisées sont disponibles en tant que règles d'administration dans votre liste de règles d'administration Google Cloud .

Pour vérifier que la contrainte personnalisée existe, utilisez la commande gcloud org-policies list-custom-constraints :

gcloud org-policies list-custom-constraints --organization=ORGANIZATION_ID

ORGANIZATION_ID par l'ID de votre ressource d'organisation.

Pour en savoir plus, consultez la page Afficher les règles d'administration.

Appliquer une contrainte personnalisée

Vous pouvez appliquer une contrainte en créant une règle d'administration qui y fait référence, puis en appliquant cette règle à une ressource Google Cloud .Console

- Dans la console Google Cloud , accédez à la page Règles d'administration.

- Dans le sélecteur de projets, choisissez le projet pour lequel vous souhaitez définir la règle d'administration.

- Dans la liste de la page Règles d'administration, sélectionnez votre contrainte pour afficher la page Détails de la règle de cette contrainte.

- Pour personnaliser la règle d'administration pour cette ressource, cliquez sur Gérer la règle.

- Sur la page Modifier la stratégie, sélectionnez Ignorer la règle parente.

- Cliquez sur Ajouter une règle.

- Dans la section Application, indiquez si l'application de cette règle d'administration est activée ou désactivée.

- Facultatif : pour rendre la règle d'administration conditionnelle à un tag, cliquez sur Ajouter une condition. Notez que si vous ajoutez une règle conditionnelle à une règle d'administration, vous devez ajouter au moins une règle non conditionnelle, sinon la règle ne pourra pas être enregistrée. Pour en savoir plus, consultez Définir une règle d'administration avec des tags.

- Cliquez sur Tester les modifications pour simuler l'effet de la règle d'administration. La simulation de règles n'est pas disponible pour les anciennes contraintes gérées. Pour en savoir plus, consultez Tester les modifications apportées aux règles d'administration à l'aide de Policy Simulator.

- Pour terminer et appliquer la règle d'administration, cliquez sur Définir des règles. L'application de la règle peut prendre jusqu'à 15 minutes.

gcloud

Pour créer une règle d'administration avec des règles booléennes, créez un fichier YAML de règle qui fait référence à la contrainte :

name: projects/PROJECT_ID/policies/CONSTRAINT_NAME spec: rules: - enforce: true

Remplacez les éléments suivants :

-

PROJECT_ID: projet sur lequel vous souhaitez appliquer votre contrainte. -

CONSTRAINT_NAME: nom que vous avez défini pour la contrainte personnalisée. Exemple :custom.defaultNetworkConstraint.

Pour appliquer la règle d'administration contenant la contrainte, exécutez la commande suivante :

gcloud org-policies set-policy POLICY_PATH

Remplacez POLICY_PATH par le chemin d'accès complet au fichier YAML de votre règle d'administration. L'application de la règle peut prendre jusqu'à 15 minutes.

Tester la contrainte personnalisée

Pour tester l'exemple qui limite les paramètres d'entrée, déployez un connecteur dans le projet avec le réseau défini sur default :

gcloud compute networks vpc-access connectors create org-policy-test \

--project=PROJECT_ID \

--region=REGION_ID \

--network=default

Le résultat est le suivant :

Operation denied by custom org policies: ["customConstraints/custom.defaultNetworkConstraint": "Require network to not be set to default."]

Exemples de règles d'administration personnalisées pour des cas d'utilisation courants

Le tableau suivant fournit des exemples de contraintes personnalisées qui peuvent s'avérer utiles avec les connecteurs d'accès au VPC sans serveur :

| Description | Syntaxe de la contrainte |

|---|---|

| Exige que les connecteurs d'accès au VPC sans serveur ne puissent utiliser qu'un réseau spécifique. |

name: organizations/ORGANIZATION_ID/customConstraints/custom.allowlistNetworks resourceTypes: - vpcaccess.googleapis.com/Connector methodTypes: - CREATE condition: "resource.network == 'allowlisted-network'" actionType: ALLOW displayName: allowlistNetworks description: Require connectors to use a specific network. |

| Description | Syntaxe de la contrainte |

| Exigez que les connecteurs d'accès au VPC sans serveur n'aient accès qu'à un sous-réseau spécifique. |

name: organizations/ORGANIZATION_ID/customConstraints/custom.restrictSubnetForProject resourceTypes: - vpcaccess.googleapis.com/Connector methodTypes: - CREATE condition: "resource.subnet.name == 'allocated-subnet'" actionType: ALLOW displayName: restrictSubnetForProject description: This project is only allowed to use the subnet "allocated-subnet". |

Configurer votre environnement Cloud Run pour utiliser le VPC direct au lieu d'un connecteur

Vous pouvez activer votre service Cloud Run pour envoyer le trafic de sortie (sortant) directement vers un réseau VPC, autorisant l'accès aux instances de VM Compute Engine, aux instances Memorystore et à toute autre ressource avec une adresse IP interne.

Configurer votre service pour utiliser le VPC direct

La sortie directe VPC permet à votre service Cloud Run d'envoyer du trafic vers un réseau VPC sans connecteur d'accès au VPC sans serveur. Les coûts réseau sont réduits à zéro comme le service lui-même. Vous pouvez également ajouter des tags réseau directement sur les révisions du service Cloud Run pour une sécurité réseau plus précise, par exemple en appliquant des règles de pare-feu VPC.

Vous pouvez configurer la sortie directe du VPC avec un service à l'aide de la consoleGoogle Cloud , de Google Cloud CLI, de YAML ou de Terraform.

Console

Cliquez sur Créer un service si vous configurez un nouveau service sur lequel effectuer un déploiement. Si vous configurez et déployez un service existant, cliquez sur ce service, puis sur Modifier et déployer la nouvelle révision.

Si vous configurez un nouveau service, remplissez la page initiale des paramètres du service selon vos besoins, puis cliquez sur Conteneur(s), Volumes, Mise en réseau, Sécurité pour développer la page de configuration du service.

Cliquez sur l'onglet Réseau.

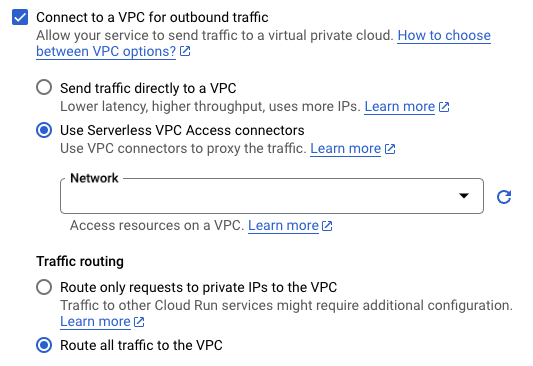

Cliquez sur Se connecter à un VPC pour le trafic sortant.

Cliquez sur Envoyer le trafic directement à un VPC.

Dans le champ Réseau, sélectionnez le réseau VPC vers lequel vous souhaitez envoyer du trafic.

Dans le champ Sous-réseau, sélectionnez le sous-réseau à partir duquel votre service reçoit des adresses IP. Vous pouvez déployer plusieurs services sur le même sous-réseau.

Facultatif : saisissez les noms des tags réseau que vous souhaitez associer à votre ou vos services. Les tags réseau sont spécifiés au niveau de la révision. Chaque révision de service peut avoir des tags réseau différents, tels que

network-tag-2.Dans le champ Routage du trafic, sélectionnez l'une des options suivantes :

- N'acheminez que les requêtes adressées à des adresses IP privées vers le VPC pour envoyer uniquement le trafic vers des adresses internes via le réseau VPC.

- Acheminez tout le trafic vers le VPC pour envoyer tout le trafic sortant via le réseau VPC.

Cliquez sur Créer ou Déployer.

Pour vérifier que votre service se trouve sur votre réseau VPC, cliquez sur le service, puis sur l'onglet Mise en réseau. Le réseau et le sous-réseau sont répertoriés dans la fiche VPC.

Vous pouvez désormais envoyer des requêtes à partir de votre service Cloud Run vers n'importe quelle ressource du réseau VPC, conformément à vos règles de pare-feu.

gcloud

Pour déployer un service Cloud Run sans connecteur à partir de Google Cloud CLI, procédez comme suit :

Mettez à jour les composants

gcloudvers la dernière version :gcloud components update

Assurez-vous que l'API Compute Engine est activée pour votre projet :

gcloud services enable compute.googleapis.com

Déployez votre service Cloud Run à l'aide de la commande suivante :

gcloud run deploy SERVICE_NAME \ --image=IMAGE_URL \ --network=NETWORK \ --subnet=SUBNET \ --network-tags=NETWORK_TAG_NAMES \ --vpc-egress=EGRESS_SETTING \ --region=REGION

Remplacez :

- SERVICE_NAME par le nom de votre service Cloud Run.

- IMAGE_URL : référence à l'image de conteneur, par exemple

us-docker.pkg.dev/cloudrun/container/hello:latest. Si vous utilisez Artifact Registry, le dépôt REPO_NAME doit déjà être créé. L'URL est au formatLOCATION-docker.pkg.dev/PROJECT_ID/REPO_NAME/PATH:TAG. - Facultatif : NETWORK par le nom de votre réseau VPC. Spécifiez un réseau VPC ou un sous-réseau, ou les deux. Si vous ne spécifiez qu'un réseau, le sous-réseau utilise le même nom que le réseau.

- Facultatif : remplacez SUBNET par le nom de votre sous-réseau. Le sous-réseau doit être

/26ou supérieur. La sortie VPC directe est compatible avec les plages IPv4 RFC 1918, RFC 6598 et Classe E. Vous pouvez déployer ou exécuter plusieurs services ou jobs sur le même sous-réseau, mais le sous-réseau ne peut pas être partagé par des connecteurs existants. - Facultatif: NETWORK_TAG_NAMES par les noms des tags réseau séparés par une virgule que vous souhaitez associer à un service. Pour les services, les tags réseau sont spécifiés au niveau de la révision. Chaque révision de service peut avoir des tags réseau différents, tels que

network-tag-2. - EGRESS_SETTING par une valeur de paramètre de sortie :

all-traffic: achemine tout le trafic sortant via le réseau VPC.private-ranges-only: achemine uniquement le trafic destiné à des adresses internes via le réseau VPC.

- REGION par une région pour votre service.

Pour vérifier que votre service se trouve sur votre réseau VPC, exécutez la commande suivante :

gcloud run services describe SERVICE_NAME \ --region=REGION

Remplacez :

SERVICE_NAMEpar le nom de votre service.REGIONpar la région du service que vous avez spécifiée à l'étape précédente.

La sortie doit contenir le nom du réseau, du sous-réseau et du trafic sortant, par exemple :

VPC access: Network: default Subnet: subnet Egress: private-ranges-only

Vous pouvez désormais envoyer des requêtes à partir de votre service Cloud Run vers n'importe quelle ressource du réseau VPC, conformément à vos règles de pare-feu.

YAML

Si vous créez un service, ignorez cette étape. Si vous mettez à jour un service existant, téléchargez sa configuration YAML :

gcloud run services describe SERVICE --format export > service.yaml

Mettez à jour les attributs suivants :

apiVersion: serving.knative.dev/v1 kind: Service metadata: name: SERVICE_NAME labels: cloud.googleapis.com/location: REGION spec: template: metadata: annotations: run.googleapis.com/network-interfaces: '[{"network":"NETWORK","subnetwork":"SUBNET","tags":"NETWORK_TAG_NAMES"}]' run.googleapis.com/vpc-access-egress: EGRESS_SETTING spec: containers: - image: IMAGE

Remplacez :

- SERVICE_NAME par le nom de votre service Cloud Run. Les noms de service doivent comporter un maximum de 49 caractères et être uniques par région et par projet.

- REGION par la région de votre service Cloud Run, qui doit correspondre à la région de votre sous-réseau.

- Facultatif : NETWORK par le nom de votre réseau VPC. Spécifiez un réseau VPC ou un sous-réseau, ou les deux. Si vous ne spécifiez qu'un réseau, le sous-réseau utilise le même nom que le réseau.

- Facultatif : remplacez SUBNET par le nom de votre sous-réseau. Le sous-réseau doit être

/26ou supérieur. La sortie VPC directe est compatible avec les plages IPv4 RFC 1918, RFC 6598 et Classe E. Vous pouvez déployer ou exécuter plusieurs services ou jobs sur le même sous-réseau, mais le sous-réseau ne peut pas être partagé par des connecteurs existants. - Facultatif: NETWORK_TAG_NAMES par les noms des tags réseau que vous souhaitez associer à un service. Pour les services, les tags réseau sont spécifiés au niveau de la révision. Chaque révision de service peut avoir des tags réseau différents, tels que

network-tag-2. - EGRESS_SETTING par une valeur de paramètre de sortie :

all-traffic: achemine tout le trafic sortant via le réseau VPC.private-ranges-only: achemine uniquement le trafic destiné à des adresses internes via le réseau VPC.

- IMAGE par l'URL de votre image de conteneur de service.

Vous pouvez également spécifier d'autres éléments de configuration, tels que des variables d'environnement ou des limites de mémoire.

Créez ou mettez à jour le service à l'aide de la commande suivante :

gcloud run services replace service.yaml

Terraform

Pour savoir comment appliquer ou supprimer une configuration Terraform, consultez la page Commandes Terraform de base.

Ajoutez le code ci-dessous à votre fichier

main.tf:

Vous pouvez éventuellement rendre votre service public si vous souhaitez autoriser un accès non authentifié à celui-ci.

Configurer votre job pour utiliser le VPC direct

La sortie directe de VPC permet à votre job Cloud Run d'envoyer du trafic vers un réseau VPC sans connecteur d'accès au VPC sans serveur. Vous pouvez également ajouter des tags réseau directement sur les jobs Cloud Run pour une sécurité réseau plus précise, par exemple en appliquant des règles de pare-feu VPC.

Vous pouvez configurer une sortie VPC directe avec un job à l'aide de la consoleGoogle Cloud , de Google Cloud CLI ou de YAML.

Console

Si vous configurez un nouveau job, cliquez sur l'onglet Jobs et remplissez la page des paramètres initiaux du job selon vos besoins. Si vous configurez un job existant, cliquez sur celui-ci, puis sur Modifier.

Cliquez sur Conteneur, variables et secrets, connexions, sécurité pour développer la page des propriétés du job.

Cliquez sur l'onglet Connexions.

Cliquez sur Se connecter à un VPC pour le trafic sortant.

Cliquez sur Envoyer le trafic directement à un VPC.

Dans le champ Réseau, sélectionnez le réseau VPC auquel vous souhaitez envoyer du trafic.

Dans le champ Sous-réseau, sélectionnez le sous-réseau à partir duquel votre job reçoit des adresses IP. Vous pouvez exécuter plusieurs jobs sur le même sous-réseau.

Dans le champ Routage du trafic, sélectionnez l'une des options suivantes :

- N'acheminez que les requêtes adressées à des adresses IP privées vers le VPC pour envoyer uniquement le trafic vers des adresses internes via le réseau VPC.

- Acheminez tout le trafic vers le VPC pour envoyer tout le trafic sortant via le réseau VPC.

Facultatif : saisissez les noms des tags réseau que vous souhaitez associer à votre ou vos services. Les tags réseau sont spécifiés au niveau de la révision. Chaque révision de service peut avoir des tags réseau différents, tels que

network-tag-2.Facultatif : saisissez les noms des tags réseau que vous souhaitez associer à votre ou vos jobs. Pour les jobs, les tags réseau sont spécifiés au niveau de l'exécution. Chaque exécution de job peut avoir des tags réseau différents, tels que

network-tag-2.Cliquez sur Créer ou Mettre à jour.

Pour vérifier que votre job se trouve sur votre réseau VPC, cliquez sur le job, puis sur l'onglet Configuration. Le réseau et le sous-réseau sont répertoriés dans la fiche VPC.

Vous pouvez maintenant exécuter votre job Cloud Run et envoyer des requêtes à partir du job vers n'importe quelle ressource du réseau VPC, conformément à vos règles de pare-feu.

gcloud

Pour créer un job Cloud Run sans connecteur à partir de Google Cloud CLI, procédez comme suit :

Mettez à jour les composants

gcloudvers la dernière version :gcloud components update

Assurez-vous que l'API Compute Engine est activée pour votre projet :

gcloud services enable compute.googleapis.com

Créez un job Cloud Run à l'aide de la commande suivante :

gcloud run jobs create JOB_NAME \ --image=IMAGE_URL \ --network=NETWORK \ --subnet=SUBNET \ --network-tags=NETWORK_TAG_NAMES \ --vpc-egress=EGRESS_SETTING \ --region=REGION

Remplacez :

- JOB_NAME par le nom de votre job Cloud Run

- IMAGE_URL : référence à l'image de conteneur, par exemple

us-docker.pkg.dev/cloudrun/container/job:latest - Facultatif : NETWORK par le nom de votre réseau VPC. Spécifiez un réseau VPC ou un sous-réseau, ou les deux. Si vous ne spécifiez qu'un réseau, le sous-réseau utilise le même nom que le réseau.

- Facultatif : remplacez SUBNET par le nom de votre sous-réseau. Le sous-réseau doit être

/26ou supérieur. La sortie VPC directe est compatible avec les plages IPv4 RFC 1918, RFC 6598 et Classe E. Vous pouvez déployer ou exécuter plusieurs services ou jobs sur le même sous-réseau, mais le sous-réseau ne peut pas être partagé par des connecteurs existants. - Facultatif: NETWORK_TAG_NAMES par les noms des tags réseau que vous souhaitez associer à un job. Pour les jobs, les tags réseau sont spécifiés au niveau de l'exécution. Chaque exécution de job peut avoir des tags réseau différents, tels que

network-tag-2. - EGRESS_SETTING par une valeur de paramètre de sortie :

all-traffic: achemine tout le trafic sortant via le réseau VPC.private-ranges-only: achemine uniquement le trafic destiné à des adresses internes via le réseau VPC.

- REGION par une région pour votre job.

Pour vérifier que le job se trouve sur votre réseau VPC, exécutez la commande suivante :

gcloud run jobs describe JOB_NAME \ --region=REGION

Remplacez :

JOB_NAMEpar le nom de votre tâche.REGIONpar la région de votre job que vous avez spécifié à l'étape précédente.

Le résultat doit contenir le nom de votre réseau et de votre sous-réseau, par exemple :

VPC network: Network: default Subnet: default

Vous pouvez maintenant exécuter votre job Cloud Run et envoyer des requêtes à partir du job vers n'importe quelle ressource du réseau VPC, conformément à vos règles de pare-feu.

YAML

Si vous créez un job, ignorez cette étape. Si vous mettez à jour un job existant, téléchargez sa configuration YAML :

gcloud run jobs describe JOB_NAME --format export > job.yaml

Mettez à jour les attributs suivants :

apiVersion: run.googleapis.com/v1 kind: Job metadata: name: JOB_NAME labels: cloud.googleapis.com/location: REGION spec: template: metadata: annotations: run.googleapis.com/network-interfaces: '[{"network":"NETWORK","subnetwork":"SUBNET","tags":"NETWORK_TAG_NAMES"}]' run.googleapis.com/vpc-access-egress: EGRESS_SETTING spec: containers: - image: IMAGE

Remplacez :

- JOB_NAME par le nom de votre job Cloud Run Les noms de job doivent comporter un maximum de 49 caractères et être uniques par région et par projet.

- REGION par la région de votre job Cloud Run, qui doit correspondre à la région de votre sous-réseau.

- Facultatif : NETWORK par le nom de votre réseau VPC. Spécifiez un réseau VPC ou un sous-réseau, ou les deux. Si vous ne spécifiez qu'un réseau, le sous-réseau utilise le même nom que le réseau.

- Facultatif : remplacez SUBNET par le nom de votre sous-réseau. Le sous-réseau doit être

/26ou supérieur. La sortie VPC directe est compatible avec les plages IPv4 RFC 1918, RFC 6598 et Classe E. Vous pouvez déployer ou exécuter plusieurs services ou jobs sur le même sous-réseau, mais le sous-réseau ne peut pas être partagé par des connecteurs existants. - Facultatif: NETWORK_TAG_NAMES par les noms des tags réseau que vous souhaitez associer à un job. Pour les jobs, les tags réseau sont spécifiés au niveau de l'exécution. Chaque exécution de job peut avoir des tags réseau différents, tels que

network-tag-2. - EGRESS_SETTING par une valeur de paramètre de sortie :

all-traffic: achemine tout le trafic sortant via le réseau VPC.private-ranges-only: achemine uniquement le trafic destiné à des adresses internes via le réseau VPC.

- IMAGE par l'URL de votre image de conteneur de job.

Créez ou mettez à jour le job à l'aide de la commande suivante :

gcloud run jobs replace job.yaml

Dépannage

Autorisations de compte de service

Pour effectuer des opérations dans votre projet Google Cloud , l'accès au VPC sans serveur utilise le compte de service Agent de service de l'accès au VPC sans serveur. L'adresse e-mail de ce compte de service est au format suivant :

service-PROJECT_NUMBER@gcp-sa-vpcaccess.iam.gserviceaccount.com

Par défaut, ce compte de service dispose du rôle Agent de service d'accès au VPC sans serveur (roles/vpcaccess.serviceAgent). Les opérations d'accès au VPC sans serveur peuvent échouer si vous modifiez les autorisations de ce compte.

Mauvaises performances du réseau ou utilisation élevée du processeur inactif

L'utilisation d'un seul connecteur pour des milliers d'instances peut entraîner une dégradation des performances et une utilisation élevée du processeur inactif. Pour résoudre ce problème, répartissez vos services entre plusieurs connecteurs.

Problèmes liés à la MTU personnalisée

Si vous rencontrez des problèmes avec une MTU personnalisée, assurez-vous d'utiliser le paramètre de MTU par défaut pour Cloud Run.

Erreurs

Erreur liée à un compte de service nécessitant un rôle d'agent de service

Si vous utilisez la contrainte de règle d'administration Restreindre l'utilisation des services de ressources pour bloquer Cloud Deployment Manager (deploymentmanager.googleapis.com), il est possible que le message d'erreur suivant s'affiche :

Serverless VPC Access service account (service-<PROJECT_NUMBER>@gcp-sa-vpcaccess.iam.gserviceaccount.com) needs Serverless VPC Access Service Agent role in the project.

Définissez la règle d'administration pour retirer Deployment Manager de la liste de blocage ou l'ajouter à la liste d'autorisation.

Erreur de création de connecteur

Si la création d'un connecteur entraîne une erreur, procédez comme suit :

- Spécifiez une plage d'adresses IP interne RFC 1918 qui ne chevauche aucune réservation d'adresses IP existantes sur le réseau VPC.

- Accordez à votre projet l'autorisation d'utiliser les images de VM Compute Engine du projet avec l'ID

serverless-vpc-access-images. Pour savoir comment mettre à jour votre règle d'administration en conséquence, consultez Définir des contraintes d'accès aux images.

Impossible d'accéder aux ressources

Si vous avez spécifié un connecteur, mais que vous ne pouvez toujours pas accéder aux ressources de votre réseau VPC, assurez-vous qu'aucune règle de pare-feu de votre réseau VPC ayant une priorité inférieure à 1 000 ne refuse l'entrée en provenance de la plage d'adresses IP de votre connecteur.

Si vous configurez un connecteur dans un projet de service VPC partagé, assurez-vous que vos règles de pare-feu autorisent l'entrée de votre infrastructure sans serveur vers le connecteur.

Erreur de connexion refusée

Si vous recevez des erreurs connection refused ou connection timeout qui dégradent les performances du réseau, cela signifie peut-être que le nombre de vos connexions augmente sans cesse au fur et à mesure des appels de votre application sans serveur. Pour limiter le nombre maximal de connexions utilisées par instance, utilisez une bibliothèque cliente compatible avec les pools de connexions. Pour obtenir des exemples détaillés d'utilisation des pools de connexions, consultez Gérer les connexions aux bases de données.

Erreur de ressource introuvable

Lorsque vous supprimez un réseau VPC ou une règle de pare-feu, un message semblable au suivant peut s'afficher : The resource

"aet-uscentral1-subnet--1-egrfw" was not found.

Pour en savoir plus sur cette erreur et sa solution, consultez la section Erreur de ressource introuvable dans la documentation sur les règles de pare-feu VPC.

Étapes suivantes

- Surveillez l'activité des administrateurs avec les journaux d'audit de l'accès au VPC sans serveur.

- Protégez les ressources et les données en créant un périmètre de service avec VPC Service Controls.