Auf dieser Seite wird erläutert, wie Sie die Antworten eines Modells mit der Google Suche fundieren, die öffentlich verfügbare Webdaten verwendet.

Fundierung mit der Google Suche

Verwenden Sie die Funktion „Mit der Google Suche fundieren“, wenn Sie Ihr Modell mit dem Wissen der ganzen Welt, einer Vielzahl von Themen oder aktuellen Informationen im Internet verknüpfen möchten.

Die Funktion „Mit der Google Suche fundieren“ unterstützt die dynamische Abfrage, mit der Sie fundierte Antworten mit der Google Suche generieren können. Daher wird in der Konfiguration für die dynamische Abfrage geprüft, ob für einen Prompt Wissen über aktuelle Ereignisse erforderlich ist, und die Fundierung mit der Google Suche wird aktiviert. Weitere Informationen finden Sie unter Dynamisches Abrufen.

Weitere Informationen zur Fundierung in Vertex AI finden Sie im Fundierungs-Überblick.

Unterstützte Modelle

In diesem Abschnitt sind die Modelle aufgeführt, die Grounding mit der Google Suche unterstützen. So erfahren Sie, wie die einzelnen Modelle fundierte Antworten generieren:

Probieren Sie ein in dieser Tabelle aufgeführtes Modell in der Google Cloud Console aus.

Klicken Sie auf die Ein/Aus-Schaltfläche Fundierung, um die Fundierung zu aktivieren.

| Modell | Beschreibung | Modell testen |

|---|---|---|

|

Gemini 2.0 Flash |

Text, Code, Bilder, Audio, Video, Video mit Audio, PDF Unterstützt keinen dynamischen Abruf. Weitere Informationen finden Sie unter Hinweise. |

Gemini 2.0 Flash-Modell testen |

|

Gemini 1.5 Pro |

Nur Texteingabe | Gemini 1.5 Pro-Modell testen |

|

Gemini 1.5 Flash |

Nur Texteingabe | Gemini 1.5 Flash-Modell testen |

Unterstützte Sprachen

Eine Liste der unterstützten Sprachen finden Sie unter Sprachen.

Modell mit der Google Suche fundieren

Folgen Sie der nachstehenden Anleitung, um ein Modell mit öffentlich verfügbaren Webdaten zu fundieren.

Dynamisches Abrufen

Mit der dynamischen Abfrage in Ihrer Anfrage können Sie festlegen, wann die Fundierung mit der Google Suche deaktiviert werden soll. Das ist nützlich, wenn für den Prompt keine Antwort erforderlich ist, die auf der Google Suche basiert, und die unterstützten Modelle eine Antwort auf der Grundlage ihres Wissens ohne Grundwahrheit liefern können. So lassen sich Latenz, Qualität und Kosten effizienter verwalten.

Bevor Sie die Konfiguration für den dynamischen Abruf in Ihrer Anfrage aufrufen, sollten Sie sich mit den folgenden Begriffen vertraut machen:

Vorhersagewert: Wenn Sie eine fundierte Antwort anfordern, weist Vertex AI dem Prompt einen Vorhersagewert zu. Der Vorhersagewert ist ein Gleitkommawert im Bereich [0,1]. Der Wert hängt davon ab, ob die Antwort auf den Prompt durch die neuesten Informationen aus der Google Suche fundiert werden kann. Daher hat ein Prompt, für den eine Antwort auf der Grundlage der neuesten Fakten im Web erforderlich ist, eine höhere Vorhersagebewertung. Ein Prompt, für den eine vom Modell generierte Antwort ausreicht, hat einen niedrigeren Vorhersagewert.

Hier sind einige Beispiele für Prompts und ihre Vorhersagewerte.

Prompt Vorhersagewert Kommentar „Schreib ein Gedicht über Pfingstrosen“ 0,13 Das Modell kann auf sein Wissen zurückgreifen und die Antwort muss nicht begründet werden. „Empfehle mir ein Spielzeug für ein zweijähriges Kind“ 0,36 Das Modell kann auf sein Wissen zurückgreifen und die Antwort muss nicht begründet werden. „Kannst du mir ein Rezept für eine asiatisch inspirierte Guacamole nennen?“ 0,55 Die Google Suche kann eine fundierte Antwort liefern, eine Fundierung ist aber nicht unbedingt erforderlich. Das Modellwissen reicht möglicherweise aus. „Was ist Agent Builder? Wie wird die Fundierung in Agent Builder abgerechnet?“ 0,72 Erfordert die Google Suche, um eine fundierte Antwort zu generieren „Wer hat den letzten Formel-1-Grand-Prix gewonnen?“ 0,97 Erfordert die Google Suche, um eine fundierte Antwort zu generieren Schwellenwert: In Ihrer Anfrage können Sie eine Konfiguration für den dynamischen Abruf mit einem Grenzwert angeben. Der Schwellenwert ist ein Gleitkommawert im Bereich [0,1] und liegt standardmäßig bei 0,7. Wenn der Schwellenwert null ist, wird die Antwort immer mit der Google Suche fundiert. Für alle anderen Schwellenwerte gilt Folgendes:

- Wenn der Vorhersagewert größer oder gleich dem Schwellenwert ist, basiert die Antwort auf der Google Suche. Ein niedrigerer Schwellenwert bedeutet, dass für mehr Prompts Antworten mithilfe der Google Suche generiert werden.

- Wenn der Vorhersagewert unter dem Schwellenwert liegt, generiert das Modell möglicherweise trotzdem eine Antwort, die aber nicht auf der Google Suche basiert.

Um einen geeigneten Schwellenwert für Ihre Geschäftsanforderungen zu finden, können Sie eine repräsentative Reihe von Suchanfragen erstellen, die Sie voraussichtlich erhalten werden. Anschließend können Sie die Abfragen nach dem Vorhersagewert in der Antwort sortieren und einen geeigneten Schwellenwert für Ihren Anwendungsfall auswählen.

Hinweise

Wenn Sie die Funktion „Fundierung mit der Google Suche“ verwenden möchten, müssen Sie die Google-Suchvorschläge aktivieren. Weitere Informationen finden Sie unter Google-Suchvorschläge.

Die besten Ergebnisse erzielen Sie mit einer Temperatur von

0.0. Weitere Informationen zum Festlegen dieser Konfiguration finden Sie unter Gemini API-Anfragetext in der Modellreferenz.Die Fundierung mit der Google Suche ist auf eine Million Abfragen pro Tag beschränkt. Wenn du weitere Fragen hast, wende dich bitte an den Google Cloud Support.

Nur die Modelle Gemini 1.0 und Gemini 1.5 unterstützen die dynamische Abfrage. Die Gemini 2.0-Modelle unterstützen kein dynamisches Abrufen.

Gen AI SDK for Python

Installieren

pip install --upgrade google-genai

Legen Sie Umgebungsvariablen fest, um das Gen AI SDK mit Vertex AI zu verwenden:

# Replace the `GOOGLE_CLOUD_PROJECT` and `GOOGLE_CLOUD_LOCATION` values # with appropriate values for your project. export GOOGLE_CLOUD_PROJECT=GOOGLE_CLOUD_PROJECT export GOOGLE_CLOUD_LOCATION=us-central1 export GOOGLE_GENAI_USE_VERTEXAI=True

Console

So verwenden Sie die Fundierung mit der Google Suche mit Vertex AI Studio:

- Rufen Sie in der Google Cloud Console die Seite „Vertex AI Studio“ auf.

- Klicken Sie auf den Tab Freies Format.

- Klicken Sie in der Seitenleiste auf die Ein/Aus-Schaltfläche Antworten für Bodenmodelle.

- Klicken Sie auf Anpassen und legen Sie die Google Suche als Quelle fest.

- Geben Sie Ihren Prompt in das Textfeld ein und klicken Sie auf Senden.

Ihre Prompt-Antworten werden jetzt in der Google Suche fundiert.

REST

Ersetzen Sie diese Werte in den folgenden Anfragedaten:

- LOCATION: Die Region, in der die Anfrage verarbeitet werden soll.

- PROJECT_ID: Ihre Projekt-ID.

- MODEL_ID: Die Modell-ID des multimodalen Modells. Gemini 2.0-Modelle und höher unterstützen keinen dynamischen Abruf.

- TEXT: Die Textanleitung, die in den Prompt eingefügt werden soll.

- DYNAMIC_THRESHOLD: Optionales Feld zum Festlegen des Grenzwerts, bei dem die Konfiguration für die dynamische Abfrage aufgerufen wird. Es ist ein Gleitkommawert im Bereich [0,1]. Wenn Sie das Feld

dynamicThresholdnicht festlegen, wird der Schwellenwert standardmäßig auf 0,7 festgelegt.

HTTP-Methode und URL:

POST https://LOCATION-aiplatform.googleapis.com/v1beta1/projects/PROJECT_ID/locations/LOCATION/publishers/google/models/MODEL_ID:generateContent

JSON-Text anfordern:

{

"contents": [{

"role": "user",

"parts": [{

"text": "TEXT"

}]

}],

"tools": [{

"googleSearchRetrieval": {

"dynamicRetrievalConfig": {

"mode": "MODE_DYNAMIC",

"dynamicThreshold": DYNAMIC_THRESHOLD

}

}

}],

"model": "projects/PROJECT_ID/locations/LOCATION/publishers/google/models/MODEL_ID"

}

Wenn Sie die Anfrage senden möchten, maximieren Sie eine der folgenden Optionen:

Sie sollten eine JSON-Antwort ähnlich wie diese erhalten:

{

"candidates": [

{

"content": {

"role": "model",

"parts": [

{

"text": "Chicago weather changes rapidly, so layers let you adjust easily. Consider a base layer, a warm mid-layer (sweater-fleece), and a weatherproof outer layer."

}

]

},

"finishReason": "STOP",

"safetyRatings":[

"..."

],

"groundingMetadata": {

"webSearchQueries": [

"What's the weather in Chicago this weekend?"

],

"searchEntryPoint": {

"renderedContent": "....................."

}

"groundingSupports": [

{

"segment": {

"startIndex": 0,

"endIndex": 65,

"text": "Chicago weather changes rapidly, so layers let you adjust easily."

},

"groundingChunkIndices": [

0

],

"confidenceScores": [

0.99

]

},

]

"retrievalMetadata": {

"webDynamicRetrievalScore": 0.96879

}

}

}

],

"usageMetadata": { "..."

}

}

Ihre Antwort verstehen

Wenn Ihr Modell-Prompt von Vertex AI Studio oder der API erfolgreich bei der Google Suche fundiert wird, enthalten die Antworten Metadaten mit Quelllinks (Web-URLs). Es gibt jedoch mehrere Gründe, warum diese Metadaten möglicherweise nicht bereitgestellt werden und die Prompt-Antwort nicht fundiert wird. Dazu gehören eine geringe Quellenrelevanz oder unvollständige Informationen in der Antwort des Modells.

Zitate

Die Anzeige von Zitaten wird dringend empfohlen. Sie helfen den Nutzern, die Antworten der Publisher selbst zu validieren, und bieten Möglichkeiten zum weiteren Lernen.

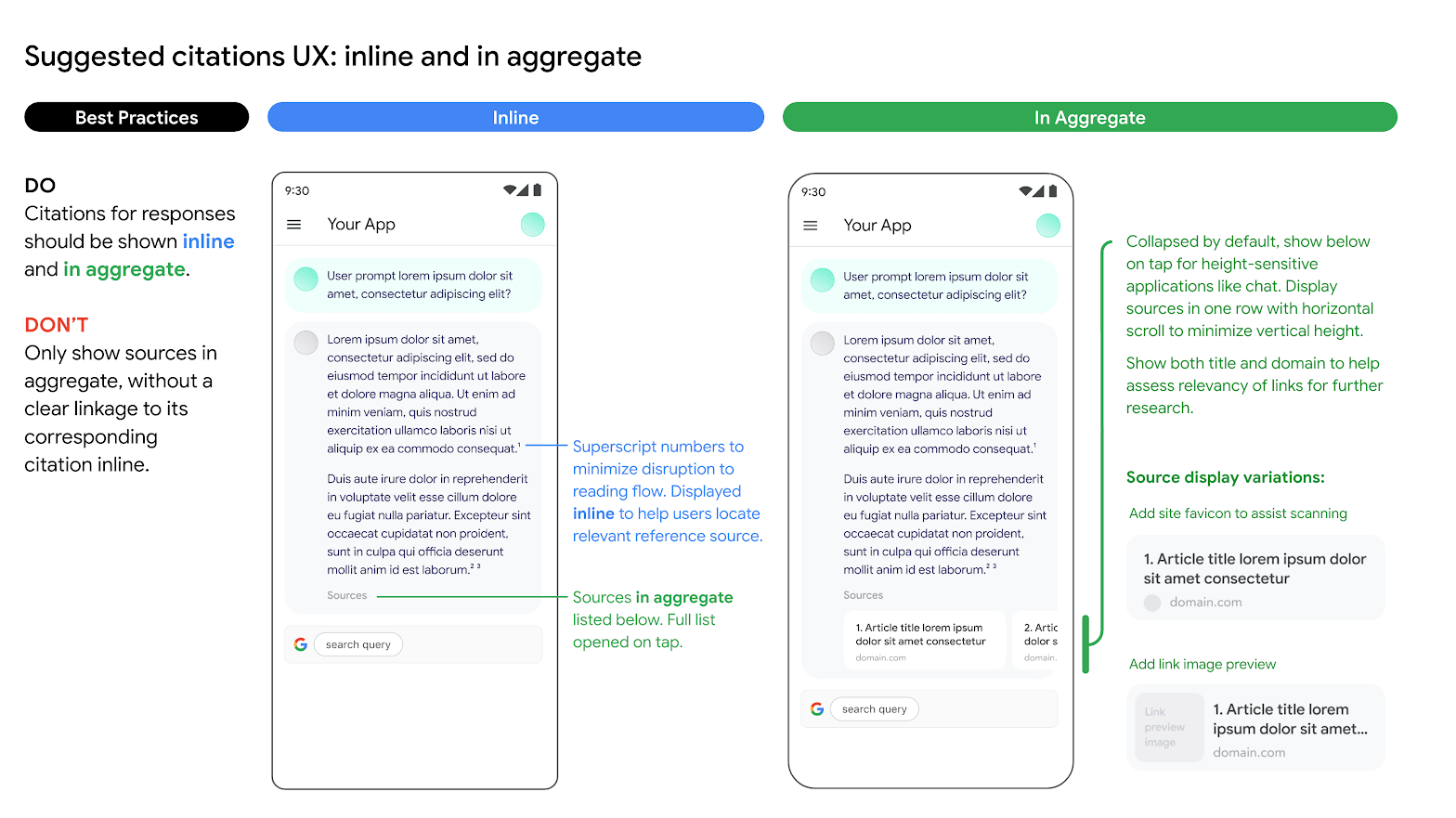

Zitate für Antworten aus Quellen der Google Suche sollten sowohl inline als auch aggregiert angezeigt werden. In der folgenden Abbildung sehen Sie einen Vorschlag dafür.

Verwendung alternativer Suchmaschinenoptionen

Die Verwendung der Funktion „Grundlagen mit der Google Suche“ durch den Kunden hindert ihn nicht daran, alternative Suchmaschinenoptionen anzubieten, alternative Suchoptionen als Standardoption für Kundenanwendungen festzulegen oder eigene Suchvorschläge oder Suchergebnisse von Drittanbietern in Kundenanwendungen anzuzeigen, sofern diese Dienste oder zugehörigen Ergebnisse, die nicht von der Google Suche stammen, getrennt von den Ergebnissen der Funktion „Grundlagen“ und den Suchvorschlägen angezeigt werden und nicht vernünftigerweise Google-Ergebnissen zugeordnet oder mit diesen verwechselt werden können.

Nächste Schritte

- Informationen zum Senden von Anfragen für Chat-Prompts finden Sie unter Mehrere Antworten in einem Chat.

- Weitere Informationen zu Best Practices für verantwortungsbewusste KI und den Sicherheitsfiltern von Vertex AI finden Sie unter Best Practices für Sicherheit.

- Informationen zur Einbindung der PaLM-Modelle finden Sie unter Grounding in Vertex AI.