Vertex AI Vision은 동영상 데이터를 수집, 분석, 저장하는 데 사용할 수 있는 AI 기반 플랫폼입니다. Vertex AI Vision을 사용하면 AI 애플리케이션을 빌드하고 배포할 수 있습니다. 다른 제품 구성요소와의 Vertex AI Vision 통합을 활용하여 엔드 투 엔드 Vertex AI Vision 솔루션을 빌드할 수 있습니다.

Vertex AI Vision 플랫폼을 사용하여 솔루션을 구현하려면 다음 Vertex AI Vision 개념과 구성요소를 검토하세요.

스트림: 솔루션의 동영상 스트리밍 레이어를 나타냅니다. 스트림 소스는 라이브 동영상 (예: IP 카메라) 또는 동영상 파일(예: MP4 파일)일 수 있습니다.

애플리케이션: 스트림과 AI 프로세서 간의 연결을 사용 설정하여 동영상에 머신러닝 작업을 실행합니다. 예를 들어 카메라 스트림을 카메라 앞을 지나가는 사람 수를 세는 AI 모델에 연결할 수 있습니다.

앱 출력 대상: 분석된 데이터를 저장소 대상(Vertex AI Vision의 미디어 저장소 또는 BigQuery)으로 전송하거나 실시간 데이터를 수신합니다. Vertex AI Vision의 미디어 웨어하우스에 저장하면 수집된 스트림의 데이터에 사용된 AI 프로세서의 분석 출력과 메타데이터를 검색할 수 있습니다. BigQuery에 저장하면 제품의 오프라인 분석 기능을 사용할 수 있습니다. 앱 출력을 직접 수신하는 경우 통계를 사용하여 즉시 비즈니스 결정을 내릴 수 있습니다. 자세한 내용은 개요: 데이터 대상에 앱 출력 연결을 참고하세요.

데이터를 수신하도록 BigQuery 설정

데이터를 수신하고 분석 앱 데이터에서 예측을 하려면 처리된 정보와 일치하는 BigQuery 데이터 세트와 테이블을 만들어야 합니다.

데이터 세트 만들기

BigQuery 테이블을 만들려면 먼저 앱에서 분석된 정보를 수신할 데이터 세트를 만들어야 합니다.

콘솔

Google Cloud 콘솔에서 BigQuery 페이지를 엽니다.

탐색기 패널에서 데이터 세트를 만들 프로젝트를 선택합니다.

작업 옵션을 펼치고 데이터 세트 만들기를 클릭합니다.

데이터 세트 만들기 페이지에서 다음을 실행합니다.

- 데이터세트 ID에

occupancy_dataset을 입력합니다. 데이터 위치에서 데이터 세트의 지리적 위치를 선택합니다. 데이터 세트가 생성된 후에는 위치를 변경할 수 없습니다.

기본 테이블 만료 시간에서 다음 옵션 중 하나를 선택합니다.

- 사용 안 함: (기본값) 데이터 세트에 생성된 테이블이 자동으로 삭제되지 않습니다. 수동으로 삭제해야 합니다.

테이블 생성 후 경과 일수: 이 값은 데이터 세트에서 새로 만든 테이블이 삭제되는 시기를 결정합니다. 테이블이 생성될 때 테이블 만료 시간을 설정하지 않은 경우에 이 값이 적용됩니다.

데이터 세트 만들기를 클릭합니다.

- 데이터세트 ID에

BigQuery 테이블 만들기

콘솔

Google Cloud 콘솔에서 BigQuery 페이지로 이동합니다.

- 탐색기 창에서 프로젝트를 펼친 후

occupancy_dataset데이터 세트를 선택합니다. - 데이터 세트 정보 섹션에서 테이블 만들기를 클릭합니다.

- 테이블 만들기 패널에서 다음 세부정보를 지정합니다.

- 소스 섹션의 다음 항목으로 테이블 만들기 목록에서 빈 테이블을 선택합니다.

- 대상 섹션에서 다음 세부정보를 지정합니다.

- 데이터 세트 필드에

occupancy_dataset이 지정되어 있는지 확인합니다. - 테이블 필드에

occupancy_dataset_table을 입력합니다. - 테이블 유형 필드가 기본 테이블로 설정되어 있는지 확인합니다.

- 데이터 세트 필드에

- 스키마 섹션에 스키마 정의를 입력합니다. 다음과 같이 스키마 정보를 직접 입력할 수 있습니다.

-

텍스트로 수정을 클릭하고 다음 JSON 배열 스키마를 붙여넣습니다. JSON 배열을 사용하는 경우 JSON 스키마 파일 만들기와 동일한 프로세스를 수행하여 스키마를 생성합니다.

[ { "name": "ingestion_time", "type": "TIMESTAMP", "mode": "REQUIRED" }, { "name": "application", "type": "STRING", "mode": "REQUIRED" }, { "name": "instance", "type": "STRING", "mode": "REQUIRED" }, { "name": "node", "type": "STRING", "mode": "REQUIRED" }, { "name": "annotation", "type": "STRING" } ]

-

텍스트로 수정을 클릭하고 다음 JSON 배열 스키마를 붙여넣습니다. JSON 배열을 사용하는 경우 JSON 스키마 파일 만들기와 동일한 프로세스를 수행하여 스키마를 생성합니다.

- 테이블 만들기를 클릭합니다.

점유 수 계산 애플리케이션 만들기

BigQuery 데이터 세트와 테이블을 설정한 후에는 이러한 BigQuery 리소스로 전송된 데이터를 처리하는 앱을 만들 수 있습니다.

빈 앱 만들기

앱 그래프를 채우려면 먼저 빈 앱을 만들어야 합니다.

콘솔

Google Cloud 콘솔에서 앱을 만듭니다.

Vertex AI Vision 대시보드의 애플리케이션 탭을 엽니다.

만들기 버튼을 클릭합니다.

앱 이름으로

occupancy-bq-app를 입력하고 지역을 선택합니다.만들기를 클릭합니다.

앱 구성요소 노드 추가

빈 애플리케이션을 만든 후에는 앱 그래프에 다음 세 노드를 추가할 수 있습니다.

- 수집 노드: 사용자가 만든 Compute Engine VM 인스턴스에서 전송된 데이터를 수집하는 스트림 리소스입니다.

- 처리 노드: 수집된 데이터를 기반으로 작동하는 재실 분석 모델입니다.

- BigQuery 노드: 앱이 BigQuery 테이블에 메타데이터를 저장할 수 있도록 지원하는 커넥터 노드입니다.

콘솔

콘솔에서 앱에 구성요소 노드를 추가합니다.

Vertex AI Vision 대시보드의 애플리케이션 탭을 엽니다.

occupancy-bq-app줄에서 그래프 보기를 선택합니다. 그러면 처리 파이프라인의 그래프 시각화로 이동합니다.

데이터 수집 노드 추가

입력 스트림 노드를 추가하려면 사이드 메뉴의 커넥터 섹션에서 스트림 옵션을 선택합니다.

열리는 스트림 메뉴의 소스 섹션에서 스트림 추가를 선택합니다.

스트림 추가 메뉴에서 새 스트림 등록을 선택하고

occupancy-bq-stream을 스트림 이름으로 추가합니다.앱 그래프에 스트림을 추가하려면 스트림 추가를 클릭합니다.

데이터 처리 노드 추가

재실 수 모델 노드를 추가하려면 사이드 메뉴의 특수 모델 섹션에서 재실 분석 옵션을 선택합니다.

기본 선택 항목인 사람과 차량을 그대로 둡니다.

BigQuery 노드 추가

출력 대상 (스토리지) 노드를 추가하려면 사이드 메뉴의 커넥터 섹션에서 BigQuery 옵션을 선택합니다.

BigQuery 메뉴에서

occupancy_dataset_table를 검색하고 테이블을 선택합니다.다음에서 메타데이터 저장: 섹션에서 스트림과 재실 분석을 모두 선택합니다.

사용을 위해 앱 배포하기

필요한 모든 구성요소로 엔드 투 엔드 앱을 빌드한 후 앱을 사용하는 마지막 단계는 앱을 배포하는 것입니다.

콘솔

Vertex AI Vision 대시보드의 애플리케이션 탭을 엽니다.

목록에서

occupancy-bq-app앱 옆에 있는 그래프 보기를 선택합니다.애플리케이션 그래프 빌더 페이지에서 배포 버튼을 클릭합니다.

다음 확인 대화상자에서 배포를 선택합니다.

배포 작업을 완료하는 데 몇 분 정도 걸릴 수 있습니다. 배포가 완료되면 노드 옆에 녹색 체크표시가 나타납니다.

동영상을 스트리밍하도록 원격 머신 설정하기

이제 스트리밍 데이터를 수신, 처리, BigQuery 테이블에 저장할 준비가 된 점유율 앱이 배포되었으므로 실제로 앱에 동영상 데이터를 스트리밍해야 합니다.

이 튜토리얼에서는 동영상을 호스팅하는 Compute Engine VM 인스턴스를 만들고 VM에서 스트리밍 동영상 데이터를 전송합니다.

Linux VM 만들기

Compute Engine VM 인스턴스에서 동영상을 전송하는 첫 번째 단계는 VM 인스턴스를 만드는 것입니다.

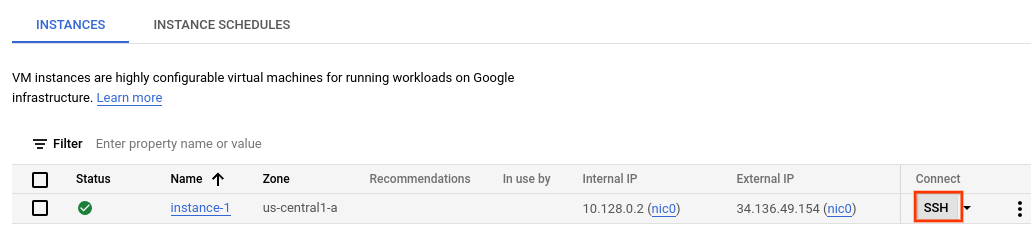

콘솔

콘솔에서 VM 인스턴스 페이지로 이동합니다.

프로젝트를 선택하고 계속을 클릭합니다.

인스턴스 만들기를 클릭합니다.

VM의 이름을 지정합니다. 자세한 내용은 리소스 이름 지정 규칙을 참조하세요.

선택사항: 이 VM의 영역을 변경합니다. Compute Engine은 각 리전 내의 영역 목록의 순서를 무작위로 지정하여 여러 영역에서 사용하도록 권장합니다.

나머지 기본 옵션을 수락합니다. 이러한 옵션에 대한 자세한 내용은 VM 만들기 및 시작을 참고하세요.

만들기를 클릭하여 VM을 만들고 시작합니다.

VM 환경 설정

VM이 시작되면 콘솔을 사용하여 브라우저에서 SSH 연결을 설정할 수 있습니다. 이 연결을 설정한 후 vaictl 명령줄 도구를 다운로드하여 앱에 동영상을 인그레션할 수 있습니다.

콘솔

VM에 SSH 연결 설정

콘솔에서 VM 인스턴스 페이지로 이동합니다.

생성한 인스턴스 행의 연결 섹션에서 SSH를 클릭합니다. 그러면 새 브라우저 창에서 SSH 연결이 열립니다.

vaictl 명령줄 도구 다운로드

브라우저에서 SSH를 통해 연결 창에서 다음 명령어를 사용하여 Vertex AI Vision(

vaictl) 명령줄 도구를 다운로드합니다.wget https://github.com/google/visionai/releases/download/v0.0.5/visionai_0.0-5_amd64.deb다음 명령어를 실행하여 명령줄 도구를 설치합니다.

sudo apt install ./visionai_0.0-5_amd64.deb다음 명령어를 실행하여 설치를 테스트할 수 있습니다.

vaictl --help

앱에 동영상 파일 처리

VM 환경을 설정한 후 샘플 동영상 파일을 복사한 다음 vaictl를 사용하여 동영상 데이터를 재실자 수 앱으로 스트리밍할 수 있습니다.

이 명령어를 보낸 후 다음 단계로 이동하기 전에 몇 시간 동안 데이터를 스트리밍해야 합니다.

브라우저에서 SSH를 통해 연결

샘플 동영상을 VM에 복사

- VM의 브라우저에서 SSH를 통해 연결 창에서 다음

gcloud storage cp명령어를 사용하여 샘플 동영상을 복사합니다. 다음 변수를 바꿉니다.- SOURCE: 사용할 동영상 파일의 위치입니다. 자체 동영상 파일 소스 (예:

gs://BUCKET_NAME/FILENAME.mp4)를 사용하거나 샘플 동영상 중 하나를 사용할 수 있습니다.

gcloud storage cp SOURCE .

- SOURCE: 사용할 동영상 파일의 위치입니다. 자체 동영상 파일 소스 (예:

VM에서 동영상을 스트리밍하고 앱에 데이터를 수집

- 이 로컬 동영상 파일을 앱 입력 스트림으로 전송하려면 다음 명령어를 사용합니다. 다음 변수를 바꿔야 합니다.

- PROJECT_ID: Google Cloud 프로젝트 ID입니다.

- LOCATION_ID: 위치 ID입니다. 예를 들면

us-central1입니다. 자세히 알아보기 - LOCAL_FILE.EXT: 로컬 동영상 파일의 파일 이름입니다.

예를 들면

my-video.mp4입니다. --loop플래그: 선택사항. 스트리밍을 시뮬레이션하기 위해 파일 데이터를 루프합니다.

이 명령어는 동영상 파일을 스트림으로 스트리밍합니다.

--loop플래그를 사용하는 경우 명령어를 중지할 때까지 동영상이 스트림에서 연속 재생됩니다.vaictl -p PROJECT_ID \ -l LOCATION_ID \ -c application-cluster-0 \ --service-endpoint visionai.googleapis.com \ send video-file to streams 'occupancy-bq-stream' --file-path LOCAL_FILE.EXT --loop

vaictl 수집 작업을 시작한 후 동영상이 대시보드에 표시되기까지 약 100초가 걸릴 수 있습니다.

스트림 수집이 완료되면 occupancy-bq-stream 스트림을 선택하여 Vertex AI Vision 대시보드의 스트림 탭에서 동영상 피드를 확인할 수 있습니다.

BigQuery ML로 예측 모델 빌드

이제 BigQuery에 메타데이터를 저장하는 작동하는 앱이 있습니다. 앱으로 스트리밍된 데이터가 몇 시간 분량 쌓이면 BigQuery ML로 예측 모델을 빌드할 수 있습니다.

선택사항: 점유 쿼리 실행

간단한 쿼리를 실행하여 테이블에 저장된 앱 생성 데이터를 볼 수 있습니다.

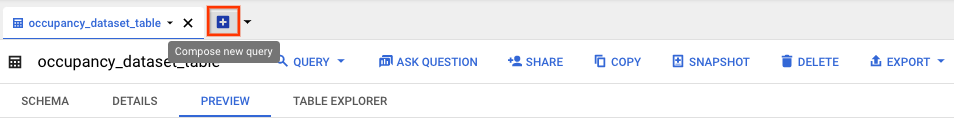

콘솔

Google Cloud 콘솔에서 BigQuery 페이지를 엽니다.

occupancy_dataset옆에 있는 펼치기를 선택하고occupancy_dataset_table를 선택합니다.표 세부정보 보기에서 새 쿼리 작성을 클릭합니다.

쿼리 편집기 텍스트 영역에 다음 Google 표준 SQL 쿼리를 입력합니다.

SELECT * FROM ( SELECT TIMESTAMP_TRUNC(PARSE_TIMESTAMP('"%Y-%m-%dT%H:%M:%E*SZ"', JSON_QUERY(annotation, "$.currentTime")), MINUTE) currentTime, CAST(JSON_QUERY(annotation, '$.stats.fullFrameCount[0].count') AS INT64) AS count, JSON_QUERY(annotation, '$.stats.fullFrameCount[0].entity.labelString') AS type FROM `PROJECT_ID.occupancy_dataset.occupancy_dataset_table` ) WHERE count IS NOT NULL

(선택사항) 데이터 처리 위치를 변경하려면 더보기, 쿼리 설정을 차례로 클릭합니다. 처리 위치에서 자동 선택을 클릭하고 데이터의 위치를 선택합니다. 마지막으로 저장을 클릭하여 쿼리 설정을 업데이트합니다.

실행을 클릭합니다.

그러면 임시 테이블에 출력을 쓰는 쿼리 작업이 생성됩니다.

이 쿼리를 실행하면 동영상에 사람이 있는 경우 시간 및 수 정보가 포함된 표가 생성됩니다.

| currentTime | 개수 | 유형 |

|---|---|---|

| 2022-08-10 16:17:00 UTC | 2 | 'Person' |

| 2022-08-10 16:17:00 UTC | 2 | 'Person' |

| 2022-08-10 16:17:00 UTC | 4 | 'Person' |

| 2022-08-10 16:17:00 UTC | 1 | 'Person' |

| 2022-08-10 16:17:00 UTC | 5 | 'Person' |

| 2022-08-10 16:17:00 UTC | 2 | 'Person' |

학습용 뷰 만들기

테이블에 저장된 데이터를 확인한 후 뷰를 만들고 결과 테이블의 콘텐츠를 검사할 수 있습니다. 이 조회 데이터를 사용하여 예측 모델을 학습시킵니다.

뷰에 액세스할 수 있는 데이터를 정의하는 데 사용되는 SQL 쿼리를 작성하여 뷰를 만들 수 있습니다. SQL 쿼리는 SELECT 문으로 구성되어야 합니다. BigQuery 뷰에 대한 자세한 내용은 뷰 소개를 참고하세요.

학습 테이블 뷰를 만들려면 다음 단계를 따르세요.

콘솔

Google Cloud 콘솔에서 BigQuery 페이지를 엽니다.

occupancy_dataset옆에 있는 펼치기를 선택하고occupancy_dataset_table를 선택합니다.표 세부정보 보기에서 새 쿼리 작성을 클릭합니다.

쿼리 편집기 텍스트 영역에 다음 Google 표준 SQL 쿼리를 입력합니다.

CREATE VIEW `PROJECT_ID.occupancy_dataset.forecast_training_data` AS ( WITH raw_counts AS ( SELECT * FROM ( SELECT TIMESTAMP_TRUNC( PARSE_TIMESTAMP('"%Y-%m-%dT%H:%M:%E*SZ"', JSON_QUERY(annotation, "$.currentTime")), MINUTE) AS currentTime, CAST(JSON_QUERY(annotation, '$.stats.fullFrameCount[0].count') AS INT64) AS count, JSON_QUERY(annotation, '$.stats.fullFrameCount[0].entity.labelString') AS type FROM `PROJECT_ID.occupancy_dataset.occupancy_dataset_table` ) WHERE count IS NOT NULL ) SELECT currentTime, SUM(count) AS total_count, type FROM raw_counts GROUP BY currentTime, type)

실행을 클릭합니다.

선택사항: 뷰 쿼리

다음 쿼리를 실행하여 새 뷰 학습 데이터의 결과를 확인합니다.

콘솔

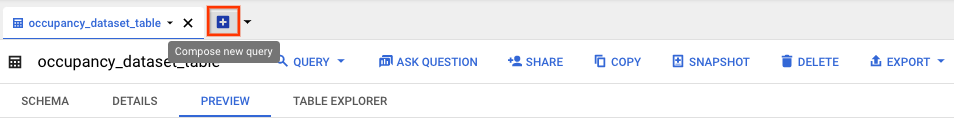

occupancy_dataset_table테이블 세부정보 보기에서 새 쿼리 작성을 클릭합니다.쿼리 편집기 텍스트 영역에 다음 Google 표준 SQL 쿼리를 입력합니다.

SELECT * FROM `PROJECT_ID.occupancy_dataset.forecast_training_data` ORDER BY currentTime, type LIMIT 100

실행을 클릭합니다.

그러면 다음과 같이 시간순으로 정렬된 결과가 반환됩니다.

| currentTime | total_count | 유형 |

|---|---|---|

| 2022-08-10 16:17:00 UTC | 129 | 'Person' |

| 2022-08-10 16:18:00 UTC | 150 | 'Person' |

| 2022-08-10 16:19:00 UTC | 80 | 'Person' |

| 2022-08-10 16:20:00 UTC | 129 | 'Person' |

| 2022-08-10 16:21:00 UTC | 142 | 'Person' |

| 2022-08-10 16:22:00 UTC | 71 | 'Person' |

| 2022-08-10 16:22:00 UTC | 2 | '차량' |

BigQuery ML로 예측 모델 학습

이제 학습 데이터로 사용할 뷰에 데이터가 있으므로 BigQuery ML을 사용하여 예측 모델을 학습시킬 수 있습니다.

콘솔

occupancy_dataset_table테이블 세부정보 보기에서 새 쿼리 작성을 클릭합니다.쿼리 편집기 텍스트 영역에 다음 Google 표준 SQL 쿼리를 입력합니다.

CREATE OR REPLACE MODEL `PROJECT_ID.occupancy_dataset.occupancy_forecast_model` OPTIONS( MODEL_TYPE = "ARIMA_PLUS", TIME_SERIES_TIMESTAMP_COL = "currentTime", TIME_SERIES_DATA_COL = "total_count", TIME_SERIES_ID_COL = "type" ) AS SELECT * FROM `PROJECT_ID.occupancy_dataset.forecast_training_data`

실행을 클릭합니다.

쿼리를 완료하는 데 몇 분 정도 걸립니다. 첫 번째 반복이 완료되면 탐색 패널에 모델 (occupancy_forecast_model)이 나타납니다. 이 쿼리에서는 CREATE MODEL 문을 사용하여 모델을 만들므로 쿼리 결과가 표시되지 않습니다.

모델 통계 탭을 확인하여 학습 중인 모델을 관찰할 수 있습니다. 첫 번째 반복이 완료되면 바로 탭이 업데이트됩니다. 반복이 완료될 때마다 통계가 계속 업데이트됩니다.

BigQuery로 점유 예측 가져오기

모델 학습이 완료되면 모델에서 재실자 수에 대한 예측을 얻을 수 있습니다.

다음 ML.FORECAST 쿼리는 HORIZON 함수 입력을 사용하여 다음 60분을 예측합니다.

콘솔

occupancy_dataset_table테이블 세부정보 보기에서 새 쿼리 작성을 클릭합니다.쿼리 편집기 텍스트 영역에 다음 Google 표준 SQL 쿼리를 입력합니다.

SELECT * FROM ML.FORECAST(MODEL `PROJECT_ID.occupancy_dataset.occupancy_forecast_model`, STRUCT(60 AS HORIZON))

실행을 클릭합니다.

모델은 유형이 "Person"인 미래 타임스탬프에 대해 forecast_value에서 예측을 생성합니다. 예를 들어 2022-08-12의 11:06:00에서 모델은 총 'Persons'이 약 15.26명일 것으로 예측합니다.

| 유형 | forecast_timestamp | forecast_value | standard_error | confidence_level | prediction_interval_lower_bound | prediction_interval_upper_bound |

|---|---|---|---|---|---|---|

| 'Person' | 2022-08-12 11:06:00 UTC | 15.2621986941298 | 2.56470066 | 0.95 | 10.2444693 | 20.2799280 |

| 'Person' | 2022-08-12 11:07:00 UTC | 13.235260043001354 | 3.19379743 | 0.95 | 6.98672921 | 19.4837908 |

| 'Person' | 2022-08-12 11:08:00 UTC | 16.257331475128712 | 3.87581375 | 0.95 | 8.67446430 | 23.8401986 |

| 'Person' | 2022-08-12 11:09:00 UTC | 31.432229611853742 | 4.24905293 | 0.95 | 23.1191356 | 39.7453236 |

| 'Person' | 2022-08-12 11:10:00 UTC | 26.199214148193725 | 4.26157413 | 0.95 | 17.8616229 | 34.5368053 |

| 'Person' | 2022-08-12 11:11:00 UTC | 26.211573546307324 | 4.27962512 | 0.95 | 17.8386663 | 34.5844807 |