Vertex AI Vision est une plate-forme basée sur l'IA que vous pouvez utiliser pour ingérer, analyser et stocker des données vidéo. Vertex AI Vision vous permet de créer et de déployer des applications d'IA. Vous pouvez créer des solutions Vertex AI Vision de bout en bout en tirant parti de l'intégration de Vertex AI Vision à d'autres composants du produit.

Pour commencer à implémenter des solutions à l'aide de la plate-forme Vertex AI Vision, consultez les concepts et composants Vertex AI Vision suivants :

Flux : représentent un calque de streaming vidéo de votre solution. La source du flux peut être une vidéo en direct (par exemple, une caméra IP) ou un fichier vidéo (par exemple, un fichier MP4).

Applications : permettent d'établir la connexion entre un flux et un processeur d'IA pour effectuer une opération de machine learning sur la vidéo. Par exemple, vous pouvez connecter un flux de caméra à un modèle d'IA qui compte les personnes qui passent devant.

Destination de sortie de l'application : envoyez les données analysées vers une destination de stockage (Media Warehouse de Vertex AI Vision ou BigQuery) ou recevez des données en direct. Le stockage dans Media Warehouse de Vertex AI Vision vous permet de rechercher les résultats d'analyse et les métadonnées des processeurs d'IA utilisés sur les données des flux ingérés. Le stockage dans BigQuery vous permet d'utiliser les fonctionnalités d'analyse hors connexion du produit. Si vous recevez directement les résultats de l'application, vous pouvez utiliser les insights pour prendre instantanément des décisions commerciales. Pour en savoir plus, consultez Présentation : Associer la sortie de l'application à une destination de données.

Configurer BigQuery pour recevoir des données

Pour pouvoir recevoir des données et générer des prédictions à partir des données de votre application d'analyse, vous devez créer un ensemble de données et une table BigQuery correspondant aux informations traitées.

Créer un ensemble de données

Avant de pouvoir créer une table BigQuery, vous devez d'abord créer un ensemble de données pour recevoir les informations analysées de votre application.

Console

Ouvrez la page BigQuery dans la console Google Cloud .

Dans le panneau Explorer, sélectionnez le projet dans lequel vous souhaitez créer l'ensemble de données.

Développez l'option Actions, puis cliquez sur Créer un ensemble de données.

Sur la page Create dataset (Créer un ensemble de données), procédez comme suit :

- Dans le champ ID de l'ensemble de données, saisissez

occupancy_dataset. Dans la liste déroulante permettant d'indiquer l'emplacement des données, sélectionnez un emplacement géographique pour l'ensemble de données. Une fois l'ensemble de données créé, l'emplacement ne peut plus être modifié.

Dans le champ Expiration de la table par défaut, choisissez l'une des options suivantes :

- Never (Jamais) : (par défaut) les tables créées dans l'ensemble de données ne sont jamais supprimées automatiquement. Vous devez les supprimer manuellement.

Nombre de jours après la création de la table : cette valeur détermine à quel moment une table nouvellement créée dans l'ensemble de données est supprimée. Cette valeur est appliquée si vous ne définissez pas de délai d'expiration pour la table lors de sa création.

Cliquez sur Créer un ensemble de données.

- Dans le champ ID de l'ensemble de données, saisissez

Créer une table BigQuery

Console

Dans la console Google Cloud , accédez à la page BigQuery.

- Dans le volet Explorateur, développez votre projet, puis sélectionnez l'ensemble de données

occupancy_dataset. - Dans la section Informations sur l'ensemble de données, cliquez sur Créer une table.

- Dans le panneau Créer une table, spécifiez les détails suivants :

- Dans la section Source, sélectionnez Table vide dans la liste Créer une table à partir de.

- Dans la section Destination, spécifiez les détails suivants :

- Vérifiez que

occupancy_datasetest spécifié dans le champ Ensemble de données. - Dans le champ Table, saisissez

occupancy_dataset_table. - Vérifiez que le champ Type de table est défini sur Table native.

- Vérifiez que

- Dans la section Schéma, saisissez la définition du schéma. Vous pouvez saisir manuellement les informations de schéma en procédant comme suit :

- Cliquez sur

Modifier sous forme de texte et collez le schéma de tableau JSON suivant. Lorsque vous utilisez un tableau JSON, vous générez le schéma en utilisant le même processus que pour la création d'un fichier de schéma JSON.

[ { "name": "ingestion_time", "type": "TIMESTAMP", "mode": "REQUIRED" }, { "name": "application", "type": "STRING", "mode": "REQUIRED" }, { "name": "instance", "type": "STRING", "mode": "REQUIRED" }, { "name": "node", "type": "STRING", "mode": "REQUIRED" }, { "name": "annotation", "type": "STRING" } ]

- Cliquez sur

Modifier sous forme de texte et collez le schéma de tableau JSON suivant. Lorsque vous utilisez un tableau JSON, vous générez le schéma en utilisant le même processus que pour la création d'un fichier de schéma JSON.

- Cliquez sur Créer une table.

Créer une application de comptage d'occupation

Une fois que vous avez configuré votre ensemble de données et votre table BigQuery, vous pouvez créer l'application qui traite les données envoyées à ces ressources BigQuery.

Créer une application vide

Avant de pouvoir remplir le graphique de l'application, vous devez d'abord créer une application vide.

Console

Créez une application dans la console Google Cloud .

Ouvrez l'onglet Applications du tableau de bord Vertex AI Vision.

Cliquez sur le bouton Créer.

Saisissez

occupancy-bq-appcomme nom d'application, puis choisissez votre région.Cliquez sur Créer.

Ajouter des nœuds de composant d'application

Une fois l'application vide créée, vous pouvez ajouter les trois nœuds au graphique de l'application :

- Nœud d'ingestion : ressource de flux qui ingère les données envoyées à partir d'une instance de VM Compute Engine que vous créez.

- Nœud de traitement : modèle d'analyse de l'occupation qui agit sur les données ingérées.

- Nœud BigQuery : nœud de connecteur qui permet à votre application de stocker des métadonnées dans votre table BigQuery.

Console

Ajoutez des nœuds de composant à votre application dans la console.

Ouvrez l'onglet Applications du tableau de bord Vertex AI Vision.

Sur la ligne

occupancy-bq-app, sélectionnez Afficher le graphique. Vous êtes alors redirigé vers la visualisation graphique du pipeline de traitement.

Ajouter un nœud d'ingestion de données

Pour ajouter un nœud de flux d'entrée, sélectionnez l'option Flux dans la section Connecteurs du menu latéral.

Dans la section Source du menu Flux qui s'affiche, sélectionnez Ajouter des flux.

Dans le menu Ajouter des flux, sélectionnez Enregistrer les nouveaux flux et ajoutez

occupancy-bq-streamcomme nom de flux.Pour ajouter le flux au graphique de l'application, cliquez sur Ajouter des flux.

Ajouter un nœud de traitement des données

Pour ajouter le nœud de modèle de comptage d'occupation, sélectionnez l'option Analyse de l'occupation dans la section Modèles spécialisés du menu latéral.

Laissez les sélections par défaut Personnes et Véhicules.

Ajouter un nœud BigQuery

Pour ajouter le nœud de destination de sortie (stockage), sélectionnez l'option BigQuery dans la section Connecteurs du menu latéral.

Dans le menu BigQuery, recherchez

occupancy_dataset_tableet sélectionnez votre table.Dans la section Stocker les métadonnées de :, sélectionnez Flux et Analyse de l'occupation.

Déployer votre application pour l'utiliser

Une fois que vous avez créé votre application de bout en bout avec tous les composants nécessaires, la dernière étape pour l'utiliser consiste à la déployer.

Console

Ouvrez l'onglet Applications du tableau de bord Vertex AI Vision.

Sélectionnez Afficher le graphique à côté de l'application

occupancy-bq-appdans la liste.Sur la page du générateur de graphiques d'application, cliquez sur le bouton Deploy (Déployer) .

Dans la boîte de dialogue de confirmation suivante, sélectionnez Déployer.

L'opération de déploiement peut prendre plusieurs minutes. Une fois le déploiement terminé, des coches vertes s'affichent à côté des nœuds.

Configurer une machine distante pour diffuser des vidéos

Maintenant que vous avez déployé une application de comptage d'occupation prête à recevoir, traiter et stocker des données de flux dans une table BigQuery, vous devez réellement diffuser des données vidéo dans l'application.

Dans ce tutoriel, vous allez créer une instance de VM Compute Engine qui héberge une vidéo, puis envoyer les données de streaming vidéo depuis la VM.

Créer une VM Linux

La première étape pour envoyer une vidéo depuis une instance de VM Compute Engine consiste à créer l'instance de VM.

Console

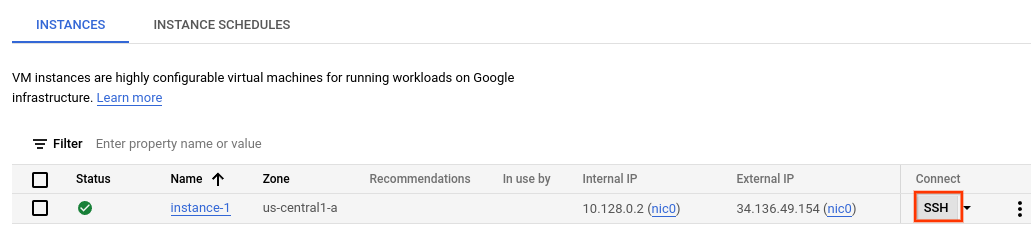

Dans la console, accédez à la page Instances de VM.

Sélectionnez le projet et cliquez sur Continuer.

Cliquez sur Créer une instance.

Spécifiez un nom pour votre VM. Pour en savoir plus, consultez Recommandation pour l'attribution de noms aux ressources.

Facultatif : modifiez la zone de cette VM. Compute Engine choisit de manière aléatoire la liste des zones de chaque région pour encourager l'utilisation dans plusieurs zones.

Acceptez les autres options par défaut. Pour en savoir plus sur ces options, consultez Créer et démarrer une VM.

Pour créer et démarrer la VM, cliquez sur Créer.

Configurer l'environnement de VM

Une fois la VM démarrée, vous pouvez utiliser la console pour établir une connexion SSH dans votre navigateur. Une fois cette connexion établie, vous pouvez télécharger l'outil de ligne de commande vaictl pour ingérer des vidéos dans votre application.

Console

Établir une connexion SSH avec votre VM

Dans la console, accédez à la page Instances de VM.

Dans la section Connecter de la ligne de l'instance que vous avez créée, cliquez sur SSH. Une connexion SSH s'ouvre dans une nouvelle fenêtre de navigateur.

Téléchargez l'outil de ligne de commande vaictl.

Dans la fenêtre SSH dans le navigateur, téléchargez l'outil de ligne de commande Vertex AI Vision (

vaictl) à l'aide de la commande suivante :wget https://github.com/google/visionai/releases/download/v0.0.5/visionai_0.0-5_amd64.debInstallez l'outil de ligne de commande en exécutant la commande suivante :

sudo apt install ./visionai_0.0-5_amd64.debVous pouvez tester l'installation en exécutant la commande suivante :

vaictl --help

Ingérer un fichier vidéo dans votre application

Après avoir configuré votre environnement de VM, vous pouvez copier un exemple de fichier vidéo, puis utiliser vaictl pour diffuser les données vidéo vers votre application de comptage d'occupation.

Après avoir envoyé cette commande, vous devez laisser plusieurs heures de données être diffusées avant de passer à l'étape suivante.

SSH dans votre navigateur

Copier un exemple de vidéo sur votre VM

- Dans la fenêtre SSH dans le navigateur de votre VM, copiez un exemple de vidéo avec la commande

gcloud storage cpsuivante. Remplacez la variable suivante :- SOURCE : emplacement d'un fichier vidéo à utiliser. Vous pouvez utiliser votre propre fichier vidéo source (par exemple,

gs://BUCKET_NAME/FILENAME.mp4) ou l'une des vidéos exemples :gs://cloud-samples-data/vertex-ai-vision/street_vehicles_people.mp4(vidéo avec des personnes et des véhicules, source vidéo)gs://cloud-samples-data/vertex-ai-vision/highway_vehicles.mp4(vidéo avec véhicules uniquement, source vidéo)

gcloud storage cp SOURCE .

- SOURCE : emplacement d'un fichier vidéo à utiliser. Vous pouvez utiliser votre propre fichier vidéo source (par exemple,

Diffuser des vidéos depuis une VM et ingérer des données dans votre application

- Pour envoyer ce fichier vidéo local au flux d'entrée de l'application, utilisez la commande suivante. Vous devez effectuer les substitutions de variables suivantes :

- PROJECT_ID : ID de votre projet Google Cloud .

- LOCATION_ID : ID de votre emplacement. Par exemple,

us-central1. En savoir plus - LOCAL_FILE.EXT : nom d'un fichier vidéo local.

Exemple :

my-video.mp4 - Option

--loop: facultative. Boucle les données du fichier pour simuler le streaming.

Cette commande diffuse un fichier vidéo dans un flux. Si vous utilisez l'indicateur

--loop, la vidéo est mise en boucle dans le flux jusqu'à ce que vous arrêtiez la commande :vaictl -p PROJECT_ID \ -l LOCATION_ID \ -c application-cluster-0 \ --service-endpoint visionai.googleapis.com \ send video-file to streams 'occupancy-bq-stream' --file-path LOCAL_FILE.EXT --loop

Il peut s'écouler environ 100 secondes entre le début de l'opération d'ingestion vaictl et l'apparition de la vidéo dans le tableau de bord.

Une fois l'ingestion du flux disponible, vous pouvez voir le flux vidéo dans l'onglet Flux du tableau de bord Vertex AI Vision en sélectionnant le flux occupancy-bq-stream.

Créer un modèle de prévision avec BigQuery ML

Vous disposez à présent d'une application fonctionnelle qui stocke les métadonnées dans BigQuery. Une fois que vous avez inséré en flux continu quelques heures de données dans votre application, vous pouvez commencer à créer un modèle de prévision avec BigQuery ML.

Facultatif : Exécuter une requête d'occupation

Vous pouvez afficher les données générées par l'application et stockées dans la table en exécutant une requête simple.

Console

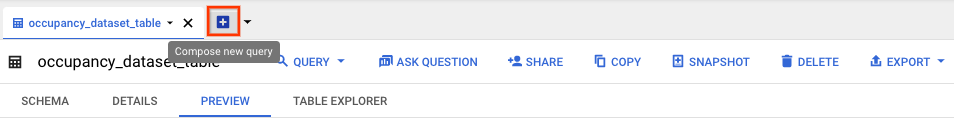

Dans la console Google Cloud , ouvrez la page "BigQuery".

Sélectionnez Développer à côté de

occupancy_dataset, puis sélectionnezoccupancy_dataset_table.Dans la vue détaillée de la table, cliquez surSaisir une nouvelle requête.

Saisissez la requête SQL standard de Google suivante dans la zone de texte Éditeur de requête :

SELECT * FROM ( SELECT TIMESTAMP_TRUNC(PARSE_TIMESTAMP('"%Y-%m-%dT%H:%M:%E*SZ"', JSON_QUERY(annotation, "$.currentTime")), MINUTE) currentTime, CAST(JSON_QUERY(annotation, '$.stats.fullFrameCount[0].count') AS INT64) AS count, JSON_QUERY(annotation, '$.stats.fullFrameCount[0].entity.labelString') AS type FROM `PROJECT_ID.occupancy_dataset.occupancy_dataset_table` ) WHERE count IS NOT NULL

Facultatif : Pour modifier l'emplacement de traitement des données, cliquez sur Plus, puis sur Paramètres de requête. Dans le champ Zone de traitement, cliquez sur Sélection automatique et choisissez l'emplacement de vos données. Cliquez ensuite sur Enregistrer pour mettre à jour les paramètres de la requête.

Cliquez sur Run (Exécuter).

Cette action crée une tâche de requête qui écrit les résultats dans une table temporaire.

L'exécution de cette requête génère un tableau contenant des informations sur l'heure et le nombre de personnes présentes dans la vidéo.

| currentTime | nombre | type |

|---|---|---|

| 2022-08-10 16:17:00 UTC | 2 | "Personne" |

| 2022-08-10 16:17:00 UTC | 2 | "Personne" |

| 2022-08-10 16:17:00 UTC | 4 | "Personne" |

| 2022-08-10 16:17:00 UTC | 1 | "Personne" |

| 2022-08-10 16:17:00 UTC | 5 | "Personne" |

| 2022-08-10 16:17:00 UTC | 2 | "Personne" |

Créer une vue pour l'entraînement

Après avoir consulté les données stockées dans la table, vous pouvez créer une vue, puis inspecter le contenu de la table résultante. Vous utilisez ces données de vues pour entraîner votre modèle de prévision.

Vous pouvez créer une vue en saisissant une requête SQL utilisée pour définir les données accessibles à la vue. La requête SQL doit contenir une instruction SELECT. Pour en savoir plus sur les vues BigQuery, consultez Présentation des vues.

Pour créer une vue Tableau d'entraînement :

Console

Dans la console Google Cloud , ouvrez la page "BigQuery".

Sélectionnez Développer à côté de

occupancy_dataset, puis sélectionnezoccupancy_dataset_table.Dans la vue détaillée de la table, cliquez surSaisir une nouvelle requête.

Saisissez la requête SQL standard de Google suivante dans la zone de texte Éditeur de requête :

CREATE VIEW `PROJECT_ID.occupancy_dataset.forecast_training_data` AS ( WITH raw_counts AS ( SELECT * FROM ( SELECT TIMESTAMP_TRUNC( PARSE_TIMESTAMP('"%Y-%m-%dT%H:%M:%E*SZ"', JSON_QUERY(annotation, "$.currentTime")), MINUTE) AS currentTime, CAST(JSON_QUERY(annotation, '$.stats.fullFrameCount[0].count') AS INT64) AS count, JSON_QUERY(annotation, '$.stats.fullFrameCount[0].entity.labelString') AS type FROM `PROJECT_ID.occupancy_dataset.occupancy_dataset_table` ) WHERE count IS NOT NULL ) SELECT currentTime, SUM(count) AS total_count, type FROM raw_counts GROUP BY currentTime, type)

Cliquez sur Exécuter.

Facultatif : Interroger la vue

Exécutez la requête suivante pour afficher les résultats des nouvelles données d'entraînement de la vue :

Console

Dans la vue détaillée du tableau

occupancy_dataset_table, cliquez sur Saisir une nouvelle requête.Saisissez la requête SQL standard de Google suivante dans la zone de texte Éditeur de requête :

SELECT * FROM `PROJECT_ID.occupancy_dataset.forecast_training_data` ORDER BY currentTime, type LIMIT 100

Cliquez sur Exécuter.

La réponse renvoyée est triée par heure et ressemble à ceci :

| currentTime | total_count | type |

|---|---|---|

| 2022-08-10 16:17:00 UTC | 129 | "Personne" |

| 2022-08-10 16:18:00 UTC | 150 | "Personne" |

| 2022-08-10 16:19:00 UTC | 80 | "Personne" |

| 2022-08-10 16:20:00 UTC | 129 | "Personne" |

| 2022-08-10 16:21:00 UTC | 142 | "Personne" |

| 2022-08-10 16:22:00 UTC | 71 | "Personne" |

| 2022-08-10 16:22:00 UTC | 2 | "Véhicule" |

Entraîner le modèle de prévision avec BigQuery ML

Maintenant que vous disposez de données dans une vue pour servir de données d'entraînement, vous pouvez entraîner le modèle de prévision avec BigQuery ML.

Console

Dans la vue détaillée du tableau

occupancy_dataset_table, cliquez sur Saisir une nouvelle requête.Saisissez la requête SQL standard de Google suivante dans la zone de texte Éditeur de requête :

CREATE OR REPLACE MODEL `PROJECT_ID.occupancy_dataset.occupancy_forecast_model` OPTIONS( MODEL_TYPE = "ARIMA_PLUS", TIME_SERIES_TIMESTAMP_COL = "currentTime", TIME_SERIES_DATA_COL = "total_count", TIME_SERIES_ID_COL = "type" ) AS SELECT * FROM `PROJECT_ID.occupancy_dataset.forecast_training_data`

Cliquez sur Exécuter.

L'exécution de la requête prend plusieurs minutes. Une fois la première itération terminée, votre modèle (occupancy_forecast_model) s'affiche dans le panneau de navigation. Étant donné que la requête utilise une instruction CREATE MODEL pour créer un modèle, les résultats de la requête ne sont pas affichés.

Vous pouvez observer le modèle pendant l'entraînement dans l'onglet Statistiques du modèle. Dès que la première itération est terminée, l'onglet est mis à jour. Les statistiques sont actualisées à la fin de chaque itération.

Obtenir une prédiction d'occupation avec BigQuery

Une fois l'entraînement de votre modèle terminé, vous pouvez obtenir une prédiction du modèle sur le nombre d'occupants.

La requête ML.FORECAST suivante utilise l'entrée de la fonction HORIZON pour effectuer une prévision pour les 60 prochaines minutes.

Console

Dans la vue détaillée du tableau

occupancy_dataset_table, cliquez sur Saisir une nouvelle requête.Saisissez la requête SQL standard de Google suivante dans la zone de texte Éditeur de requête :

SELECT * FROM ML.FORECAST(MODEL `PROJECT_ID.occupancy_dataset.occupancy_forecast_model`, STRUCT(60 AS HORIZON))

Cliquez sur Exécuter.

Le modèle génère des prévisions sous forecast_value pour les futurs codes temporels où le type est "Person". Par exemple, le modèle prévoit qu'il y aura environ 15, 26 "personnes" au total le 2022-08-12 à 11:06:00.

| type | forecast_timestamp | forecast_value | standard_error | confidence_level | prediction_interval_lower_bound | prediction_interval_upper_bound |

|---|---|---|---|---|---|---|

| "Personne" | 2022-08-12 11:06:00 UTC | 15.2621986941298 | 2,56470066 | 0,95 | 10.2444693 | 20.2799280 |

| "Personne" | 2022-08-12 11:07:00 UTC | 13.235260043001354 | 3,19379743 | 0,95 | 6.98672921 | 19.4837908 |

| "Personne" | 2022-08-12 11:08:00 UTC | 16.257331475128712 | 3,87581375 | 0,95 | 8.67446430 | 23.8401986 |

| "Personne" | 2022-08-12 11:09:00 UTC | 31.432229611853742 | 4.24905293 | 0,95 | 23.1191356 | 39.7453236 |

| "Personne" | 2022-08-12 11:10:00 UTC | 26.199214148193725 | 4.26157413 | 0,95 | 17.8616229 | 34.5368053 |

| "Personne" | 2022-08-12 11:11:00 UTC | 26.211573546307324 | 4.27962512 | 0,95 | 17,8386663 | 34.5844807 |