Vertex AI Vision es una plataforma potenciada por IA que puedes usar para ingerir, analizar y almacenar datos de video. Vertex AI Vision te permite compilar e implementar aplicaciones de IA. Puedes compilar soluciones de Vertex AI Vision de extremo a extremo aprovechando la integración de Vertex AI Vision con otros componentes del producto.

Para comenzar a implementar soluciones con la plataforma de Vertex AI Vision, revisa los siguientes conceptos y componentes de Vertex AI Vision:

Streams: Representan una capa de transmisión de video de tu solución. La fuente de transmisión puede ser un video en vivo (por ejemplo, una cámara IP) o un archivo de video (por ejemplo, un archivo MP4).

Aplicaciones: Habilitan la conexión entre una transmisión y un procesador de IA para realizar una operación de aprendizaje automático en el video. Por ejemplo, puedes conectar una transmisión de cámara a un modelo de IA que cuente las personas que pasan frente a ella.

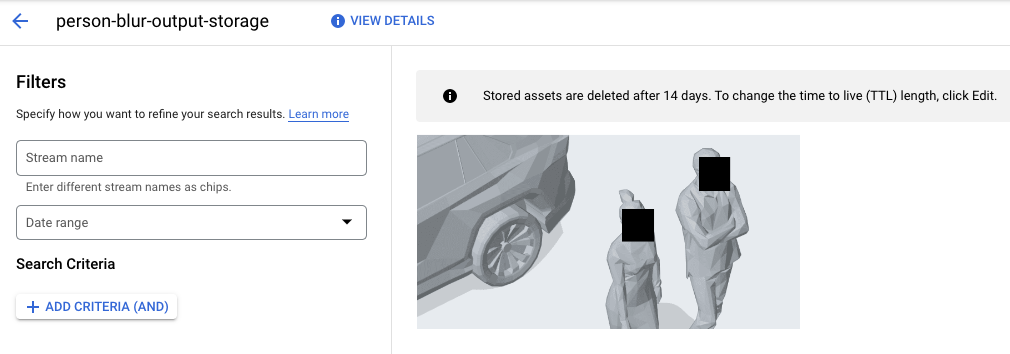

Almacenes de contenido multimedia: Almacenan el video que se transfiere desde las transmisiones aGoogle Cloud storage. Almacenar datos en este destino te permite consultar el resultado del análisis y los metadatos de los procesadores de IA que se usan en los datos de las transmisiones ingeridas.

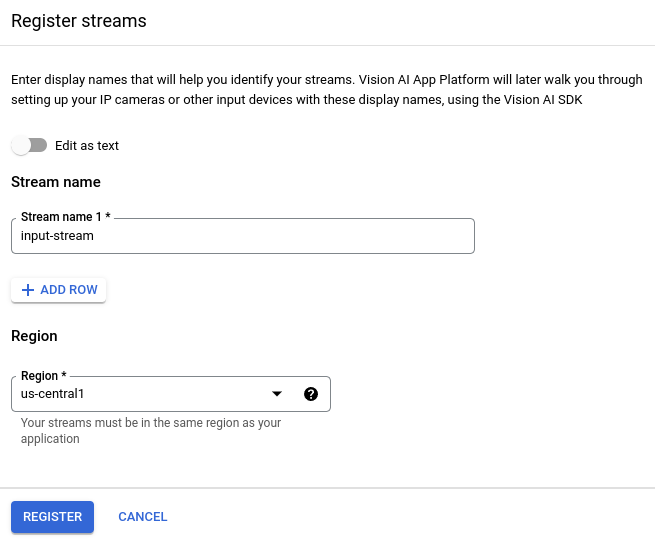

Crea una transmisión

Para crear una app de análisis de video en streaming, primero debes crear y registrar un recurso de transmisión. Como el recurso que recibe los datos de video de los usuarios, la transmisión es obligatoria en cualquier situación que crees con Vertex AI Vision.Console

Para crear un flujo nuevo en la consola de Google Cloud , sigue estos pasos.

Abre la pestaña Streams del panel de Vertex AI Vision.

Haz clic en Registrar.

Ingresa

input-streamcomo el nombre de la transmisión y selecciona la región en la que deseas crearla.Haz clic en Registrar para crear una o más transmisiones.

Transfiere el video a la transmisión

Después de crear un recurso de transmisión, puedes usar la herramienta de línea de comandos de vaictl para enviar datos de video a la transmisión.

Cámara IP

Si realizas pruebas con una cámara IP activa, debes obtener la dirección IP de la cámara. Debes proporcionar esta información con la solicitud, junto con otras sustituciones de variables:

- PROJECT_ID: El ID de tu proyecto de Google Cloud .

- LOCATION_ID: Es el ID de tu ubicación. Por ejemplo:

us-central1. Para obtener más información, consulta Ubicaciones de Cloud. - RTSP_ADDRESS: Es la dirección de tu feed del protocolo de transmisión en tiempo real (RTSP). Por ejemplo:

rtsp://192.168.1.180:540.

Este comando envía una transmisión RTSP al flujo. Debes ejecutar este comando en la red que tiene acceso directo al feed de RTSP.

vaictl -p PROJECT_ID \

-l LOCATION_ID \

-c application-cluster-0 \

--service-endpoint visionai.googleapis.com \

send rtsp to streams input-stream --rtsp-uri RTSP_ADDRESS

Si el comando se ejecuta correctamente, obtendrás el siguiente resultado:

[...] Waiting for long running operation projects/your-project/locations/us-central1/operations/operation-1651364156981-5dde82db7e4a9-dfb17ca5-1051eb20 ⠙ I20220430 21:16:28.024988 211449 gstvaisink.cc:417] cluster-id=application-cluster-0 I20220430 21:16:28.025032 211449 gstvaisink.cc:418] cluster-endpoint=c8khq35ftg78mn61ef50.us-central1.visionai.goog I20220430 21:16:28.025040 211449 gstvaisink.cc:419] event-id=ev-1651364114183255223 I20220430 21:16:28.025048 211449 gstvaisink.cc:420] stream-id=input-stream I20220430 21:16:28.025053 211449 gstvaisink.cc:421] series-id=ev-1651364114183255223--input-stream I20220430 21:16:28.025060 211449 gstvaisink.cc:422] Sending data

Archivo de video local

También puedes enviar datos de archivos de video a una transmisión en lugar de a un feed de video en vivo. Esta opción puede ser útil si no tienes acceso a una cámara IP.

La única diferencia en esta opción son los parámetros del comando vaictl. En lugar de pasar la información de la cámara IP, pasa la ruta de acceso al archivo de video local. Realiza las siguientes sustituciones de variables:

- PROJECT_ID: El ID de tu proyecto de Google Cloud .

- LOCATION_ID: Es el ID de tu ubicación. Por ejemplo:

us-central1. Más información. - LOCAL_FILE.EXT: Es el nombre de un archivo de video local.

Por ejemplo,

my-video.mp4 - Marca

--loop: Opcional. Repite los datos del archivo para simular la transmisión.

Este comando transmite un archivo de video a una transmisión. Si usas la marca --loop, el video se repetirá en el flujo hasta que detengas el comando:

vaictl -p PROJECT_ID \

-l LOCATION_ID \

-c application-cluster-0 \

--service-endpoint visionai.googleapis.com \

send video-file to streams 'input-stream' --file-path LOCAL_FILE.EXT --loop

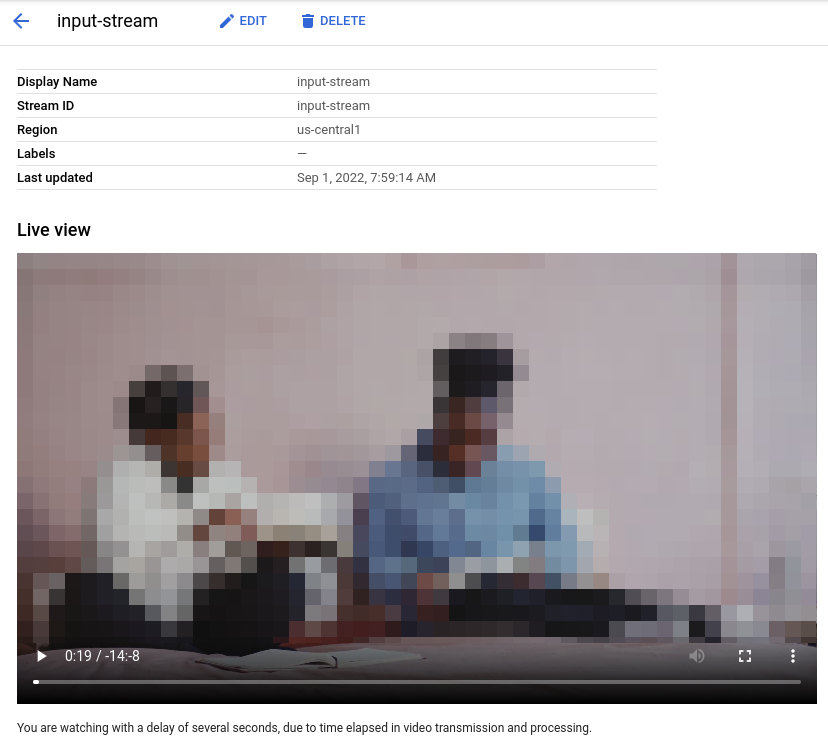

Es posible que transcurran alrededor de 100 segundos entre el inicio de la operación de transferencia vaictl y la aparición del video en el panel.

Una vez que la transferencia de la transmisión esté disponible, puedes ver el feed de video en la pestaña Transmisiones del panel de Vertex AI Vision. Para ello, selecciona la transmisión input-stream.

Crea una aplicación de desenfoque de rostros

Después de crear una transmisión y transferir datos a ella, es hora de crear una app de Vertex AI Vision para procesar los datos. Una app se puede considerar como una canalización automatizada que conecta los siguientes elementos:

- Transferencia de datos: Se transfiere un feed de video a una transmisión.

- Análisis de datos: Se puede agregar un modelo de IA después de la transferencia. Se puede realizar cualquier operación de visión por computadora en la información de video que se ingiere.

- Almacenamiento de datos: Las dos versiones del feed de video (la transmisión original y la transmisión procesada por el modelo de IA) se pueden almacenar en un almacén de contenido multimedia.

En la consola de Google Cloud , una app se representa como un gráfico. Además, en Vertex AI Vision, un gráfico de la app debe tener al menos dos nodos: un nodo de fuente de video (transmisión) y al menos un nodo más (un modelo de procesamiento o un destino de salida).

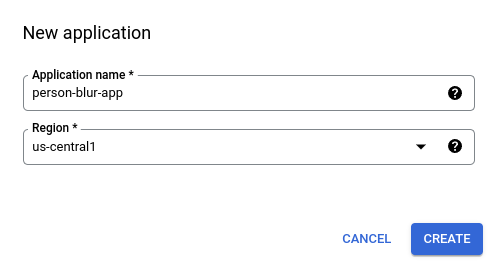

Crea una aplicación vacía

Antes de completar el gráfico de la app, primero debes crear una app vacía.Console

Crea una app en la consola de Google Cloud .

Abre la pestaña Aplicaciones del panel de Vertex AI Vision.

Haz clic en el botón Crear.

Ingresa

person-blur-appcomo el nombre de la app y elige tu región.Haz clic en Crear.

Agrega nodos componentes de la app

Después de crear la aplicación vacía, puedes agregar los tres nodos al gráfico de la app:

- Nodo de transferencia: Es el recurso de transmisión que ya está transfiriendo datos.

- Nodo de procesamiento: Es el modelo de desenfoque de personas que actúa sobre los datos ingeridos.

- Nodo de almacenamiento: Es el almacén de contenido multimedia que almacena los videos procesados y que también funciona como almacén de metadatos. El almacén permite generar información de análisis sobre los datos de video ingeridos, además de almacenar la información que infieren los modelos de IA sobre los datos.

Console

Agrega nodos de componentes a tu app en la consola.

Abre la pestaña Aplicaciones del panel de Vertex AI Vision.

En la línea

person-blur-app, selecciona Ver gráfico. Esta acción te llevará a la visualización del gráfico de la canalización de procesamiento.

Agrega un nodo de transferencia de datos

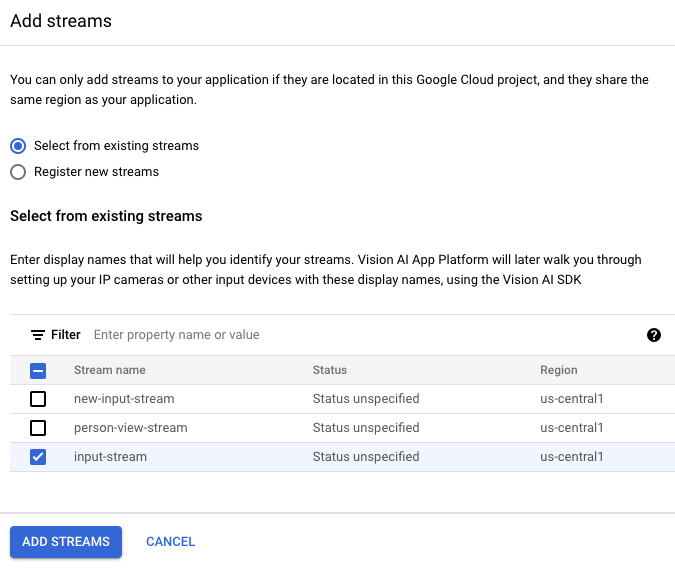

Para agregar el nodo de flujo de entrada, selecciona la opción Flujos en la sección Conectores del menú lateral.

En la sección Fuente del menú Transmisión que se abre, selecciona Agregar transmisiones.

En el menú Agregar transmisiones, elige Seleccionar entre transmisiones existentes y selecciona

person-blur-appen la lista de recursos de transmisión.

Para agregar el flujo al gráfico de la app, haz clic en Agregar flujos.

Agrega un nodo de procesamiento de datos

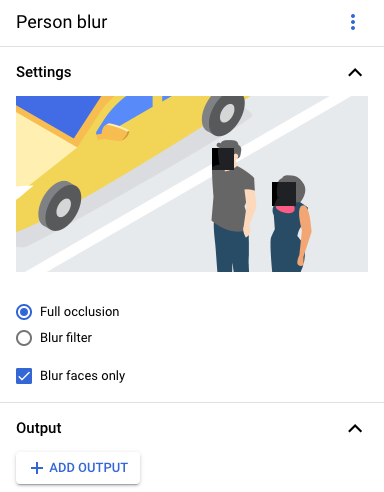

Para agregar el nodo del modelo de desenfoque de personas, selecciona la opción Desenfoque de personas en la sección Procesadores generales del menú lateral.

En el menú de opciones "Desenfoque de personas" que se abre, deja seleccionada la opción Oclusión completa y habilita la opción Desenfoque solo de rostros.

Cómo agregar un nodo de almacenamiento de datos

Para agregar el nodo de destino de salida (almacenamiento), selecciona la opción Almacén de contenido multimedia de Vertex AI Vision en la sección Conectores del menú lateral.

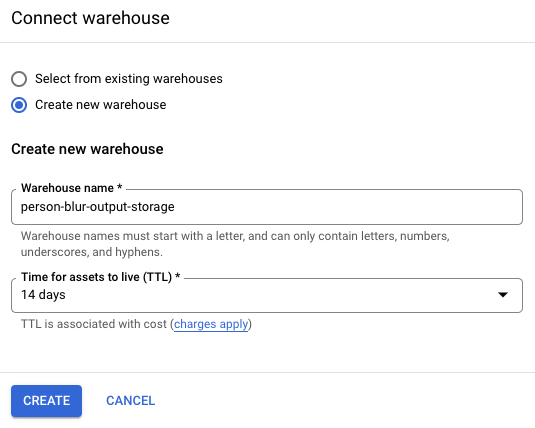

En el menú Vertex AI Vision's Media Warehouse, haz clic en Connect warehouse.

En el menú Conectar almacén, selecciona Crear almacén nuevo. Asigna el nombre

person-blur-appal almacén y deja la duración del TTL en 14 días.Para agregar el almacén, haz clic en Crear.

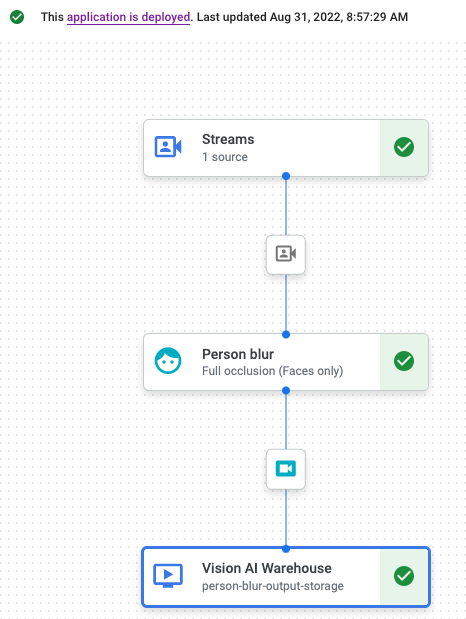

Implementa tu aplicación

Después de compilar tu app integral con todos los componentes necesarios, el último paso para usarla es implementarla.Console

Abre la pestaña Aplicaciones del panel de Vertex AI Vision.

Selecciona Ver gráfico junto a la app de

person-blur-appen la lista.En la página del compilador de gráficos de la aplicación, haz clic en el botón Implementar.

En el siguiente diálogo de confirmación, selecciona Implementar.

La operación de implementación puede tardar varios minutos en completarse. Cuando finalice la implementación, aparecerán marcas de verificación verdes junto a los nodos.

Cómo ver los datos de salida procesados

Console

Abre la pestaña Almacenes del panel de Vertex AI Vision.

Busca el almacén

person-blur-output-storageen la lista y haz clic en Ver recursos.