Filtres de sécurité configurables

Score de confiance et de gravité des attributs de sécurité

Le contenu traité via l'API Vertex AI PaLM est évalué en fonction d'une liste d'attributs de sécurité, qui incluent les "catégories dangereuses" et les sujets pouvant être considérés comme sensibles.

Chaque attribut de sécurité est associé à un score de confiance compris entre 0,0 et 1,0 arrondi à une décimale, ce qui reflète la probabilité que l'entrée ou la réponse appartienne à une catégorie donnée.

Quatre de ces attributs de sécurité (harcèlement, incitation à la haine, contenu dangereux et contenu à caractère sexuel explicite) sont associés à un score de sécurité (niveau de gravité) et à un score de gravité compris entre 0,0 et 1,0, arrondis à une décimale. Ces scores reflètent le niveau de gravité prédit du contenu appartenant à une catégorie donnée.

Exemple de réponse

{

"predictions": [

{

"safetyAttributes": {

"categories": [

"Derogatory",

"Toxic",

"Violent",

"Sexual",

"Insult",

"Profanity",

"Death, Harm & Tragedy",

"Firearms & Weapons",

"Public Safety",

"Health",

"Religion & Belief",

"Illicit Drugs",

"War & Conflict",

"Politics",

"Finance",

"Legal"

],

"scores": [

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1,

0.1

],

"safetyRatings": [

{"category": "Hate Speech", "severity": "NEGLIGIBLE", "severityScore": 0.0,"probabilityScore": 0.1},

{"category": "Dangerous Content", "severity": "LOW", "severityScore": 0.3, "probabilityScore": 0.1},

{"category": "Harassment", "severity": "MEDIUM", "severityScore": 0.6, "probabilityScore": 0.1},

{"category": "Sexually Explicit", "severity": "HIGH", "severityScore": 0.9, "probabilityScore": 0.1}

],

"blocked": false

},

"content": "<>"

}

]

}

Remarque : Les catégories dont le score est arrondi à 0,0 sont omises dans la réponse. Cet exemple de réponse n'est fourni qu'à titre indicatif.

Exemple de réponse en cas de blocage

{

"predictions": [

{

"safetyAttributes": {

"blocked": true,

"errors": [

150,

152,

250

]

},

"content": ""

}

]

}

Descriptions des attributs de sécurité

| Attribut de sécurité | Description |

|---|---|

| Contenu désobligeant | Commentaires négatifs ou offensants ciblant l'identité et/ou les attributs protégés. |

| Contenu toxique | Contenu offensant, irrespectueux ou grossier. |

| Contenu à caractère sexuel | Contient des références à des actes sexuels ou à d'autres contenus obscènes. |

| Violence | Descriptions de scénarios représentant des actes de violence contre un individu ou un groupe, ou descriptions générales de contenus sanglants. |

| Insultes | Commentaires insultants, provocateurs ou négatifs à l'égard d'une personne ou d'un groupe de personnes. |

| Grossièretés | Langage obscène ou grossier tel que les jurons. |

| Décès, torts et tragédie | Décès de personne, tragédies, accidents, catastrophes et automutilation. |

| Armes et armes à feu | Contenu faisant référence à des couteaux, des armes à feu, des armes personnelles et des accessoires tels que des munitions, des étuis, etc. |

| Sécurité publique | Services et organisations qui fournissent des soins et assurent la sécurité publique. |

| Santé | Santé humaine, ce qui inclut : affections, maladies et troubles de la santé ; thérapies, médication, vaccinations et pratiques médicales ; ressources pour la guérison, y compris les groupes de soutien. |

| Religions et croyances | Systèmes de croyance basés sur la possibilité de lois et d'êtres surnaturels ; religion, foi, croyance, pratique spirituelle, églises et lieux de culte. Inclut l'astrologie et l'occultisme. |

| Drogues illicites | Drogues récréatives et illicites ; accessoires pour la consommation de drogues et culture de la drogue, etc. Inclut l'utilisation médicale de médicaments généralement utilisés de manière récréative (par exemple, de la marijuana). |

| Guerre et conflit | Guerres, conflits militaires et conflits physiques majeurs impliquant de nombreuses personnes Inclut les discussions sur les services militaires, même si elles ne sont pas directement liées à une guerre ou un conflit. |

| Finance | Services financiers grand public et commerciaux, tels que les services bancaires, les prêts, le crédit, l'investissement, les assurances, etc. |

| Politique | Actualités et médias politiques ; discussions sur les politiques sociales, gouvernementales et publiques. |

| Juridique | Contenu lié au droit, y compris les cabinets juridiques, les informations juridiques, les documents juridiques principaux, les services parajuridiques, les publications et technologies juridiques, les témoins experts, les consultants en litige et d'autres fournisseurs de services juridiques. |

Attributs de sécurité avec évaluations de sécurité

| Attribut de sécurité | Définition | Niveaux |

|---|---|---|

| Incitation à la haine | Commentaires négatifs ou offensants ciblant l'identité et/ou les attributs protégés. | Élevé, moyen, faible, négligeable |

| Harcèlement | Commentaires malveillants, intimidants ou abusifs ciblant une autre personne. | Élevé, moyen, faible, négligeable |

| Contenu à caractère sexuel explicite | Contient des références à des actes sexuels ou à d'autres contenus obscènes. | Élevé, moyen, faible, négligeable |

| Contenu dangereux | Encourage ou facilite l'accès à des activités, produits et services dangereux. | Élevé, moyen, faible, négligeable |

Seuils de sécurité

Des seuils de sécurité ont été mis en place pour les attributs de sécurité suivants :

- Incitation à la haine

- Harcèlement

- Contenu à caractère sexuel explicite

- Contenu dangereux

Google bloque les réponses du modèle qui dépassent les scores de gravité désignés pour ces attributs de sécurité. Pour demander à pouvoir modifier un seuil de sécurité, contactez l'équipe chargée de votre Google Cloud compte.

Tester vos seuils de confiance et de gravité

Vous pouvez tester les filtres de sécurité de Google et définir des seuils de confiance adaptés à votre entreprise. En utilisant ces seuils, vous pouvez prendre des mesures complètes pour détecter les contenus qui ne respectent pas les règles d'utilisation ou les conditions d'utilisation de Google, et prendre les mesures appropriées.

Les scores de confiance ne sont que des prédictions. Vous ne devez pas compter sur ces scores pour la fiabilité ou la précision. Google n'est pas responsable de l'interprétation ni de l'utilisation de ces scores pour les décisions commerciales.

Important : probabilité et gravité

À l'exception des quatre attributs de sécurité avec des évaluations de sécurité, les scores de confiance des filtres de sécurité de l'API PaLM sont basés sur la probabilité que le contenu soit dangereux, et non sur la gravité. Cela est important, car certains contenus peuvent présenter une faible probabilité d'être non sécurisés, même si la gravité des dommages est toujours élevée. Par exemple, pour comparer les phrases :

- Le robot m'a frappé.

- Le robot m'a tranché.

La phrase 1 peut entraîner une probabilité de dangerosité plus élevée, mais vous pouvez considérer que la phrase 2 a un niveau de gravité supérieur en termes de violence.

Compte tenu de cela, il est important que les clients effectuent soigneusement les tests et de déterminer le niveau de blocage approprié pour prendre en charge leurs cas d'utilisation clés tout en minimisant les dommages aux utilisateurs finaux.

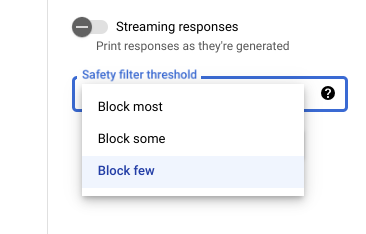

Paramètres de sécurité dans Vertex AI Studio

Avec le seuil de filtre de sécurité ajustable, vous pouvez ajuster la probabilité de voir des réponses potentiellement dangereuses. Les réponses du modèle sont bloquées, car elles sont susceptibles de comporter des contenus relevant du harcèlement, incitant à la haine, dangereux ou à caractère sexuel explicite. Le paramètre de filtre de sécurité est situé à droite de la zone de requête dans Vertex AI Studio. Vous avez le choix entre trois options : block most, block some et block few.

Filtre de citation

Nos fonctionnalités de code génératif sont destinées à produire du contenu original et non pas à reproduire intégralement le contenu existant. Nous avons conçu nos systèmes de façon à réduire le risque que cela se produise, et nous améliorons en continu leur fonctionnement. Si ces fonctionnalités reprennent directement et longuement le contenu d'une page Web, elles citent la page en question.

Quand plusieurs pages Web proposent le même contenu, nous tentons de vous renvoyer vers une source populaire. Dans le cas de citations de dépôts de code, celles-ci peuvent également faire référence à une licence Open Source applicable. Il vous incombe de respecter les conditions de cette licence.

Pour en savoir plus sur les métadonnées du filtre de citation, consultez la documentation de référence de l'API Citation.

Erreurs de sécurité

Les codes d'erreur de sécurité sont des codes à trois chiffres qui indiquent pourquoi une requête ou une réponse a été bloquée. Le premier chiffre est un préfixe qui indique si le code s'applique à la requête ou à la réponse, et les autres chiffres identifient la raison pour laquelle la requête ou la réponse a été bloquée.

Par exemple, un code d'erreur 251 indique que la réponse a été bloquée en raison d'un problème de contenu incitant à la haine dans la réponse du modèle.

Plusieurs codes d'erreur peuvent être renvoyés dans une seule réponse.

Si vous rencontrez des erreurs qui bloquent le contenu de votre réponse à partir du modèle (préfixe = 2, par exemple 250), ajustez le paramètre temperature dans votre requête. Cela permet de générer un autre ensemble de réponses tout en réduisant le risque de blocage.

Préfixe de code d'erreur

Le préfixe du code d'erreur correspond au premier chiffre du code d'erreur.

| 1 | Le code d'erreur s'applique à la requête envoyée au modèle. |

| 2 | Le code d'erreur s'applique à la réponse du modèle. |

Motif du code d'erreur

Le motif de ce code d'erreur correspond aux deuxième et troisième chiffres du code d'erreur.

Les motifs de code d'erreur commençant par 3 ou 4 indiquent des requêtes ou des réponses bloquées, car le seuil de confiance pour une violation d'attribut de sécurité a été atteint.

Les motifs de codes d'erreur commençant par 5 indiquent des requêtes ou des réponses dans lesquelles un contenu non sécurisé a été trouvé.

| 10 | La réponse a été bloquée en raison d'un problème de qualité ou d'un paramétrage qui a affecté les métadonnées de citation. Cela ne s'applique qu'aux réponses du modèle. Par exemple, Le vérificateur de citation identifie les problèmes de qualité ou les problèmes liés à un paramètre. Essayez d'augmenter les paramètres Pour en savoir plus, consultez la section Filtre de citation. |

| 20 | La langue fournie ou renvoyée n'est pas acceptée. Pour obtenir la liste des langues disponibles, consultez la page Langues acceptées. |

| 30 | La requête ou la réponse a été bloquée, car elle s'est avérée potentiellement dangereuse. Un terme est inclus dans la liste de blocage de terminologie. Reformulez votre requête. |

| 31 | Ces contenus peuvent inclure des informations personnelles sensibles. Reformulez votre requête. |

| 40 | La requête ou la réponse a été bloquée, car elle s'est avérée potentiellement dangereuse. Le contenu ne respecte pas les paramètres SafeSearch. Reformulez votre requête. |

| 50 | La requête ou la réponse a été bloquée, car elle est susceptible de comporter du contenu à caractère sexuel explicite. Reformulez votre requête. |

| 51 | La requête ou la réponse a été bloquée, car elle est susceptible de comporter du contenu incitant à la haine. Reformulez votre requête. |

| 52 | La requête ou la réponse a été bloquée, car elle est susceptible de comporter des contenus relevant du harcèlement. Reformulez votre requête. |

| 53 | La requête ou la réponse a été bloquée, car elle est susceptible de comporter du contenu dangereux. Reformulez votre requête. |

| 54 | La requête ou la réponse a été bloquée, car elle pourrait comporter du contenu toxique. Reformulez votre requête. |

| 00 | Motif inconnu. Reformulez votre requête. |

Étape suivante

- En savoir plus sur l'IA responsable.

- En savoir plus sur la gouvernance des données.