Cloud Trace 및 Cloud Service Mesh

Cloud Trace는 애플리케이션의 지연 시간 데이터를 수집하고 거의 실시간으로 표시하는 분산 추적 시스템입니다. 이를 사용하면 샘플 요청을 분산 시스템을 통해 추적하고, 네트워크 호출을 관측하고, 시스템 전체를 완전히 프로파일링할 수 있습니다.

Cloud Trace는 다음 플랫폼에서 Cloud Service Mesh 설치와 함께 제공됩니다.

- Google Cloud 기반 GKE

- Cloud Service Mesh 인증 기관으로 설치한 경우 온프레미스 GKE Enterprise 클러스터

Cloud Trace는 기본적으로 사용 중지되어 있습니다. 사용 설정되면 Google Cloud 콘솔의 Cloud Service Mesh 페이지에서 Cloud Trace 페이지의 trace에 대한 링크를 제공합니다. 자세한 가격 책정 정보는 Cloud Trace 가격 책정 페이지를 참조하세요.

Cloud Trace 사용 설정

이 섹션에서는 Cloud Trace를 사용 설정하는 방법을 보여줍니다.

관리됨

이 섹션에서는 관리형 Cloud Service Mesh에서 Cloud Trace를 사용 설정하는 방법을 보여줍니다.

다음 명령어를 실행합니다.

cat <<EOF | kubectl apply -f - apiVersion: v1 data: mesh: |- defaultConfig: tracing: stackdriver: {} kind: ConfigMap metadata: name: istio-release-channel namespace: istio-system EOF여기서 release-channel은 출시 채널입니다(

asm-managed,asm-managed-stable,asm-managed-rapid).다음 명령어를 실행하여 구성 맵을 확인합니다.

kubectl get configmap istio-release-channel -n istio-system -o yaml

Cloud Trace가 사용 설정되어 있는지 확인하려면 다음 줄이

mesh:섹션에 표시되는지 확인합니다.... apiVersion: v1 data: mesh: | .... defaultConfig: tracing: stackdriver:{} ...프록시를 다시 시작합니다.

참고로, 현재 추적기 구성은 프록시 부트스트랩 구성의 일부이므로 추적기 업데이트를 선택하려면 각 포드를 다시 시작하고 다시 주입해야 합니다. 예를 들어 다음 명령어를 사용하여 배포에 속한 포드를 다시 시작할 수 있습니다.

kubectl rollout restart deployment -n NAMESPACE DEPLOYMENT_NAME

클러스터 내

이 섹션에서는 클러스터 내 Cloud Service Mesh에서 Cloud Trace를 사용 설정하는 방법을 보여줍니다.

Cloud Trace를 사용 설정하려면 다음 오버레이 파일을 사용하여 고객 관리 컨트롤 플레인을 다시 배포합니다. 오버레이 파일에 대한 자세한 내용은 오버레이 파일 정보를 참조하세요.

기본값

다음 명령어를 실행하여 Cloud Trace를 사용하도록 설정합니다.

./asmcli install \

OTHER_FLAGS \

--option cloud-trace

이 명령어는 다음 오버레이 파일을 적용하여 기본 옵션으로 추적을 사용 설정합니다. 기본 샘플링 레이트는 1%입니다. 기본값을 재정의하려면 대신 --custom-overlay를 사용해야 합니다.

apiVersion: install.istio.io/v1alpha1

kind: IstioOperator

spec:

meshConfig:

enableTracing: true

values:

global:

proxy:

tracer: stackdriver

옵션 목록은 anthos-service-mesh 패키지를 참조하세요.

커스텀

tracing.sampling 값을 지정하여 기본값을 재정의할 수 있습니다. 값은 0.0에서 100.0 사이여야 하며 정밀도는 0.01입니다. 예를 들어 요청 10,000개마다 5개의 요청을 추적하려면 0.05를 사용합니다.

다음 예시는 샘플링 레이트 100%를 보여줍니다(데모 또는 문제 해결 목적으로만 수행).

apiVersion: install.istio.io/v1alpha1

kind: IstioOperator

spec:

meshConfig:

enableTracing: true

defaultConfig:

tracing:

sampling: 100

values:

global:

proxy:

tracer: stackdriver

다음 명령어를 실행하여 Cloud Trace를 사용하도록 설정합니다.

./asmcli install \

OTHER_FLAGS \

--custom_overlay PATH_TO_FILE

참고로, 추적기 구성은 프록시 부트스트랩 구성의 일부이므로 포드를 다시 시작하고 다시 주입받아 추적기 업데이트를 선택해야 합니다. 다음 명령어를 사용하여 배포에 속한 포드를 다시 시작합니다.

kubectl rollout restart deployment -n NAMESPACE DEPLOYMENT_NAME

추적 컨텍스트 전파

사이드카 프록시는 trace 스팬을 자동으로 전송할 수 있지만 전체 trace를 서로 결합하려면 약간의 힌트가 필요합니다. 프록시가 스팬 정보를 전송할 때 스팬이 단일 trace에 올바르게 연결될 수 있도록 하려면 애플리케이션이 관련 HTTP 헤더를 전파해야 합니다.

이를 위해 애플리케이션이 수신 요청에서 송신 요청까지 적절한 헤더를 수집하고 전파해야 합니다. Cloud Service Mesh Stackdriver 추적 구성은 다음 헤더 형식 중 하나를 허용하며 다음 형식을 모두 전파합니다.

- B3(

x-b3-traceid,x-b3-spanid,x-b3parentspanid,x-b3-sampled,x-b3-flags) - W3C TraceContext(

traceparent) - Google Cloud Trace(

x-cloud-trace-context) - gRPC TraceBin(

grpc-trace-bin)

즉, 애플리케이션은 이러한 형식을 사용하여 추적 컨텍스트를 전파할 수 있으며 트레이스가 생성되고 Stackdriver로 적절하게 설정됩니다.

예

다음은 원래 요청에 traceparent 헤더가 있는 HTTP-Get 요청의 예시입니다. 프록시에서 추가한 trace 컨텍스트 헤더를 확인하십시오.

$ kubectl exec -it sleep-557747455f-n6flv -- curl "httpbin:8000/anything?freeform=" -H "accept: application/json" -H "Traceparent: 00-7543d15e09e5d61801d4f74cde1269b8-604ef051d35c5b3f-01" -vv

* Trying 10.12.3.52:8000...

* Connected to httpbin (10.12.3.52) port 8000 (#0)

> GET /anything?freeform= HTTP/1.1

> Host: httpbin:8000

> User-Agent: curl/7.80.0-DEV

> accept: application/json

> Traceparent: 00-7543d15e09e5d61801d4f74cde1269b8-604ef051d35c5b3f-01

>

* Mark bundle as not supporting multiuse

< HTTP/1.1 200 OK

< server: envoy

< date: Wed, 10 Nov 2021 20:36:04 GMT

< content-type: application/json

< content-length: 1032

< access-control-allow-origin: *

< access-control-allow-credentials: true

< x-envoy-upstream-service-time: 5

<

{

"args": {

"freeform": ""

},

"data": "",

"files": {},

"form": {},

"headers": {

"Accept": "application/json",

"Grpc-Trace-Bin": "AAB1Q9FeCeXWGAHU90zeEmm4AaDHmGRtdM7wAgE",

"Host": "httpbin:8000",

"Traceparent": "00-7543d15e09e5d61801d4f74cde1269b8-a0c798646d74cef0-01",

"User-Agent": "curl/7.80.0-DEV",

"X-B3-Sampled": "1",

"X-B3-Spanid": "a0c798646d74cef0",

"X-B3-Traceid": "7543d15e09e5d61801d4f74cde1269b8",

"X-Cloud-Trace-Context": "7543d15e09e5d61801d4f74cde1269b8/11585396123534413552;o=1",

"X-Envoy-Attempt-Count": "1",

"X-Forwarded-Client-Cert": "<REDACTED>"

},

"json": null,

"method": "GET",

"origin": "127.0.0.6",

"url": "http://httpbin:8000/anything?freeform="

}

반환된 요청 헤더 집합에는 전체 trace 컨텍스트 헤더 집합이 있습니다.

헤더를 전파하는 자세한 예시는 Trace 컨텍스트 전파를 참조하세요.

커스텀 ID가 있는 클라이언트에서 trace 만들기

커스텀 ID가 있는 클라이언트에서 trace를 만들려면 curl 명령어를 사용하여 외부 클라이언트에 요청을 만들고 이를 적용해서 trace를 표시합니다. 예를 들면 다음과 같습니다.

curl $URL --header "x-client-trace-id: 105445aa7843bc8bf206b12000100000"

x-client-trace-id에 대한 자세한 내용은 Envoy 문서를 확인하세요.

trace 액세스

서비스의 trace 샘플 보기

앱에서 서비스의 trace 샘플링을 보려면 다음 단계를 따르세요.

Google Cloud 콘솔에서 Cloud Service Mesh 페이지로 이동합니다.

서비스에서 검사하려는 서비스의 이름을 선택합니다.

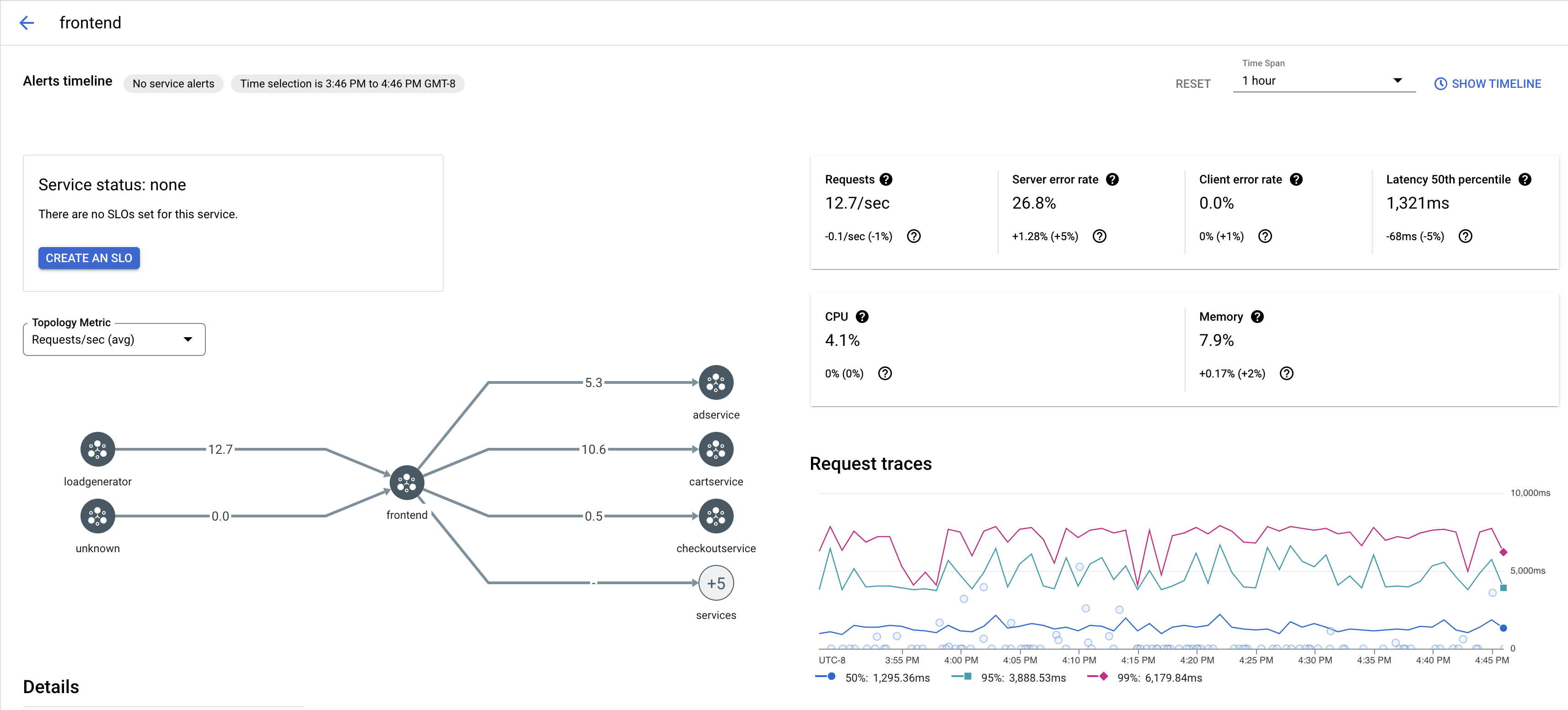

다음 스크린샷은

frontend서비스의 예시를 보여줍니다.

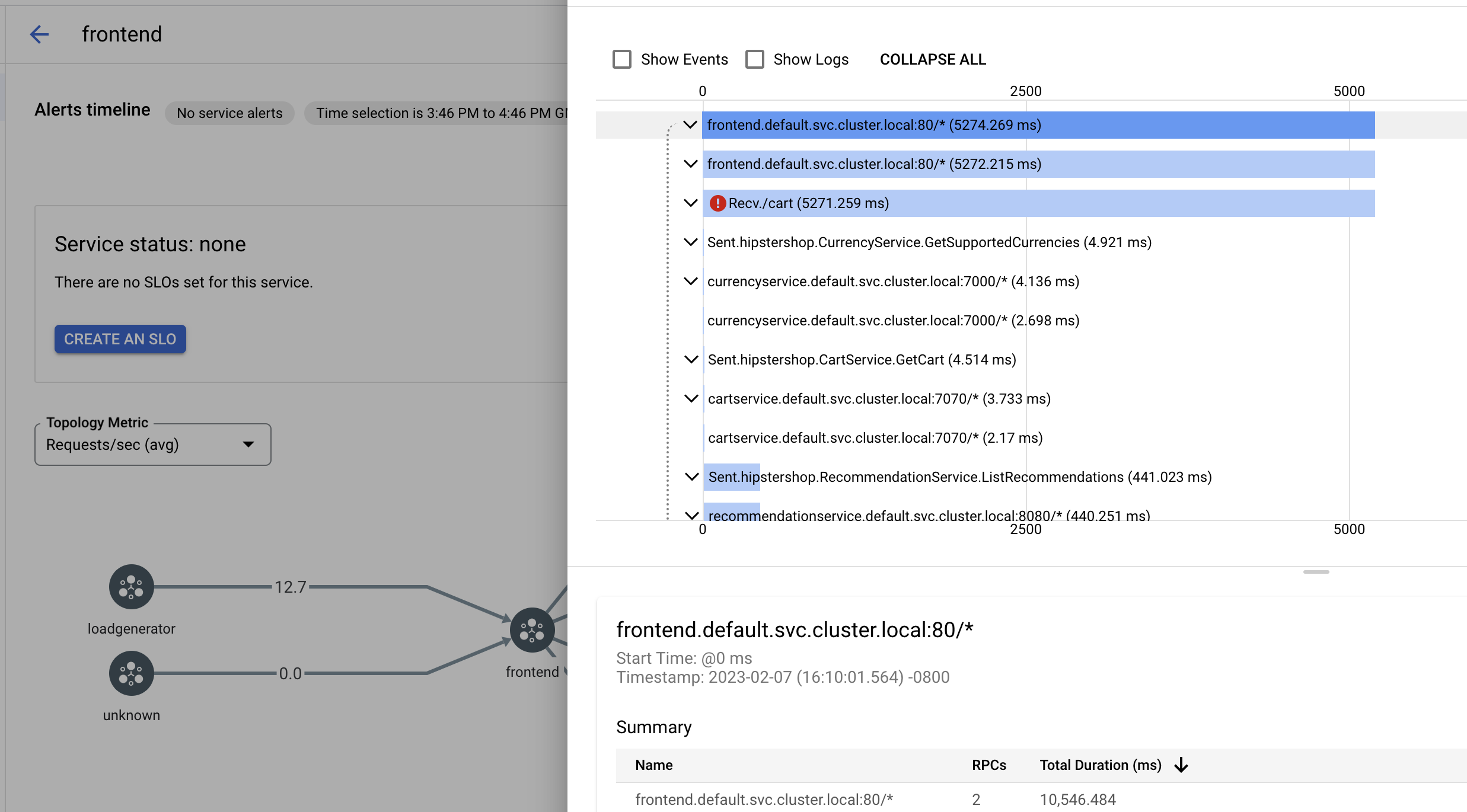

자세한 내용을 보려면 trace 요청에서 trace를 클릭합니다.

다음 스크린샷은 trace 요청 하위 패널의 예시를 보여줍니다.

모든 trace 보기

서비스의 모든 trace를 보려면 다음 단계를 수행합니다.

Google Cloud 콘솔에서 Cloud Service Mesh 페이지로 이동합니다.

서비스에서 검사하려는 서비스의 이름을 선택합니다.

측정항목 페이지로 이동합니다.

기간 드롭다운 메뉴에서 기간을 지정하거나 타임라인으로 커스텀 스팬을 설정합니다.

trace 보기를 클릭합니다.

Cloud Service Mesh의 서비스에 대한 trace에는 다음 정보가 포함됩니다.

- 메시에 있는 여러 서비스 간의 요청 지연 시간

- ID, URL, 크기, 지연 시간, 프로토콜을 비롯한 HTTP 요청 속성

- 각각

istio.canonical_service,istio.namespace,istio.mesh_id라벨의 일부로 포함된 서비스 이름, 네임스페이스, 메시 ID